Impazzienti di mettere le mani su NSX-T? Volete curiosare tra tutte le voci della web console del Manager? Preferite l’approcio imparare facendo?

Se siete come me credo proprio di si 🙂

Tuttavia l’esperienza mi ha insegnato che partire direttamente con l’installazione, saltando le verifiche sui requisiti e un opportuno dimensionamento, presto o tardi porta inevitabilmente a dover rifare tutto 🙁

Niente paura, la guida di NSX-T Data Center mette a disposizione i Workflows per ogni tipo di installazione, questa quella per vSphere:

- Review the NSX Manager installation requirements.

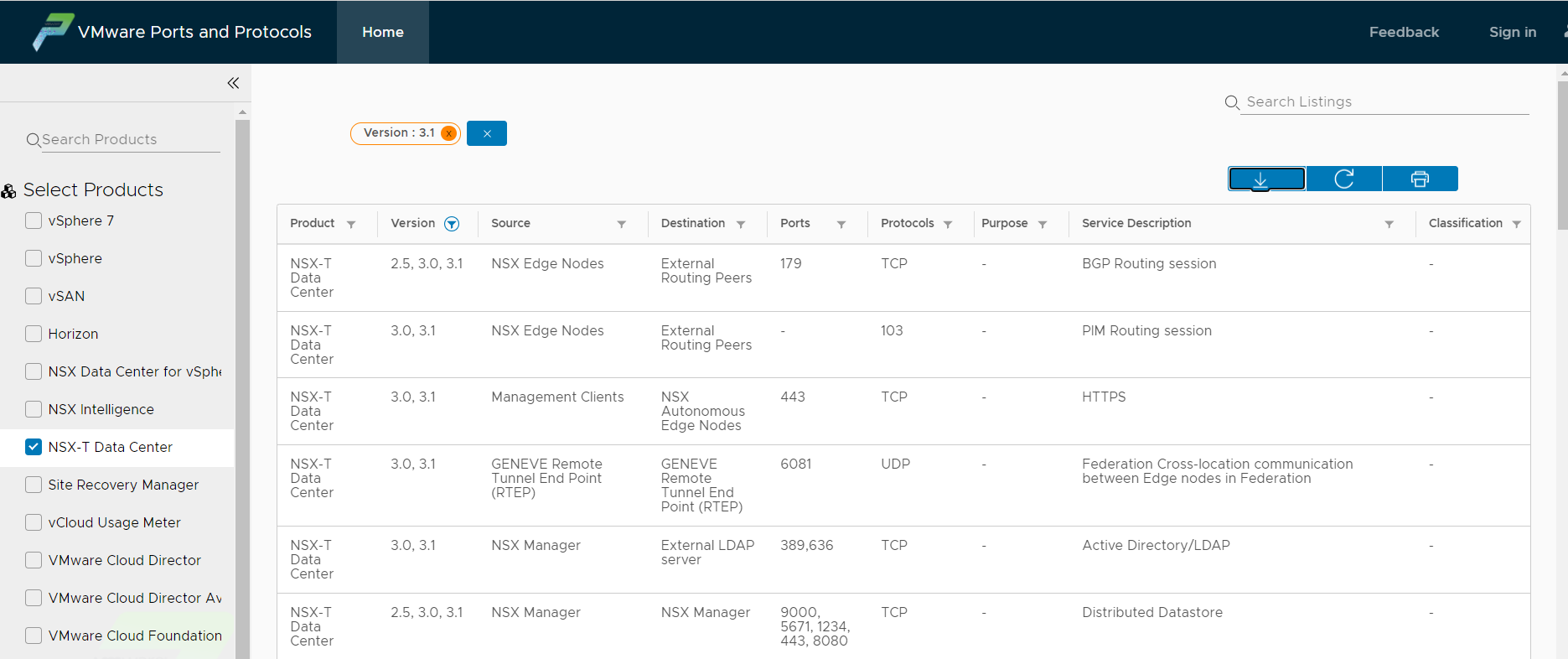

- Configure the necessary ports and protocols.

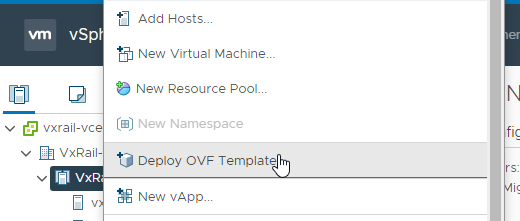

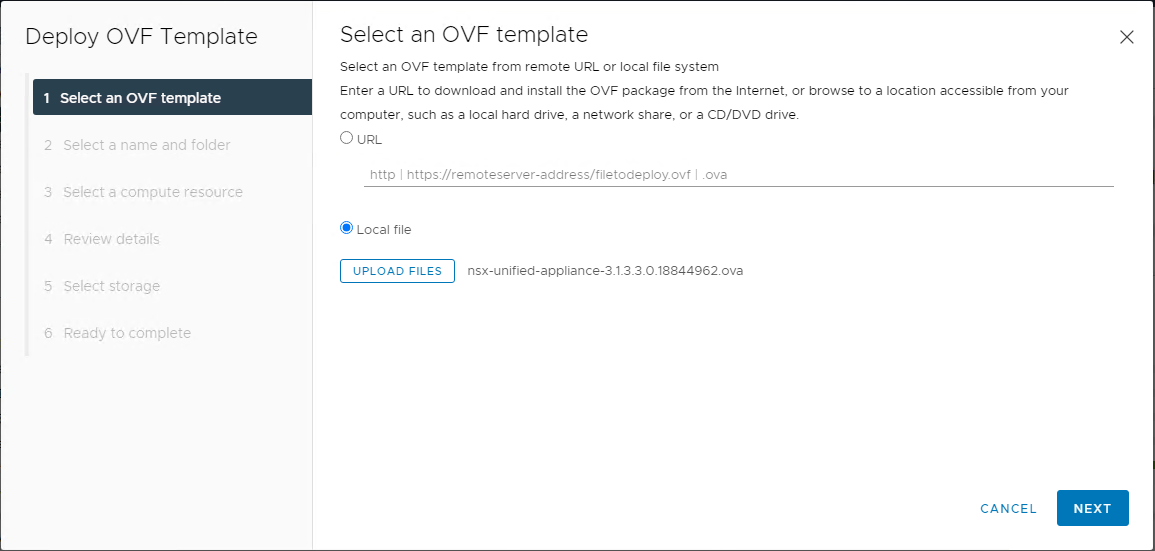

- Install the NSX Manager.

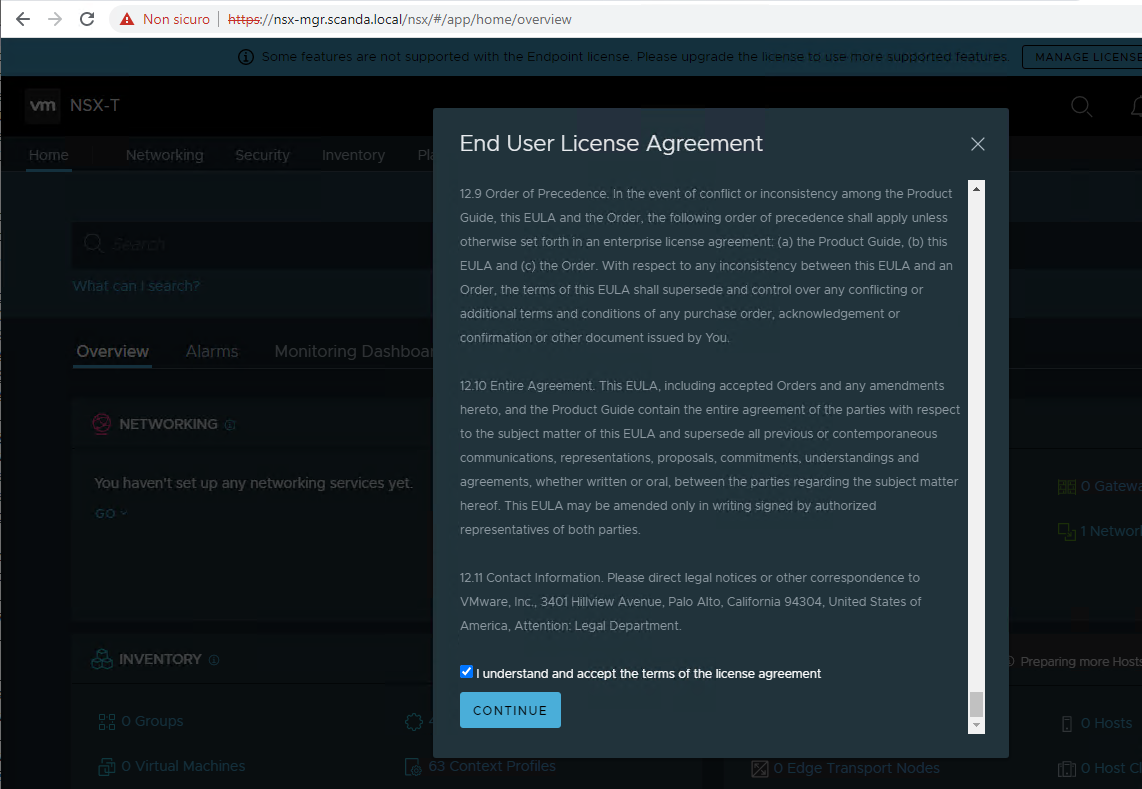

- Log in to the newly created NSX Manager.

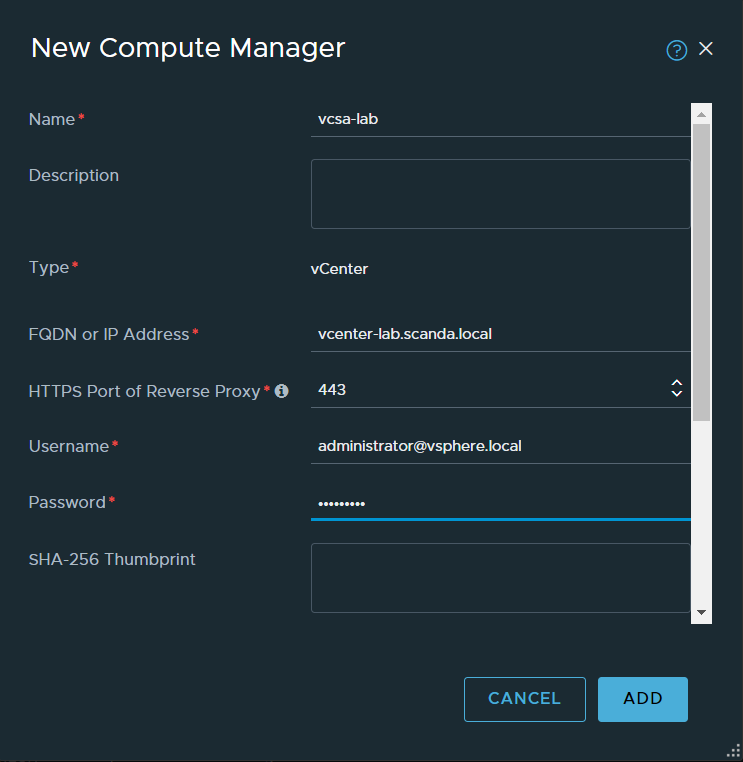

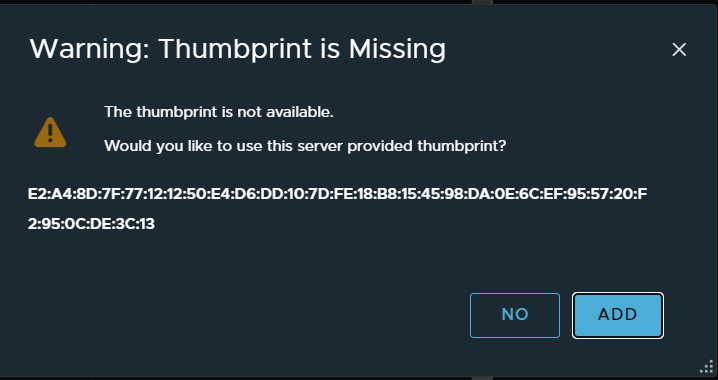

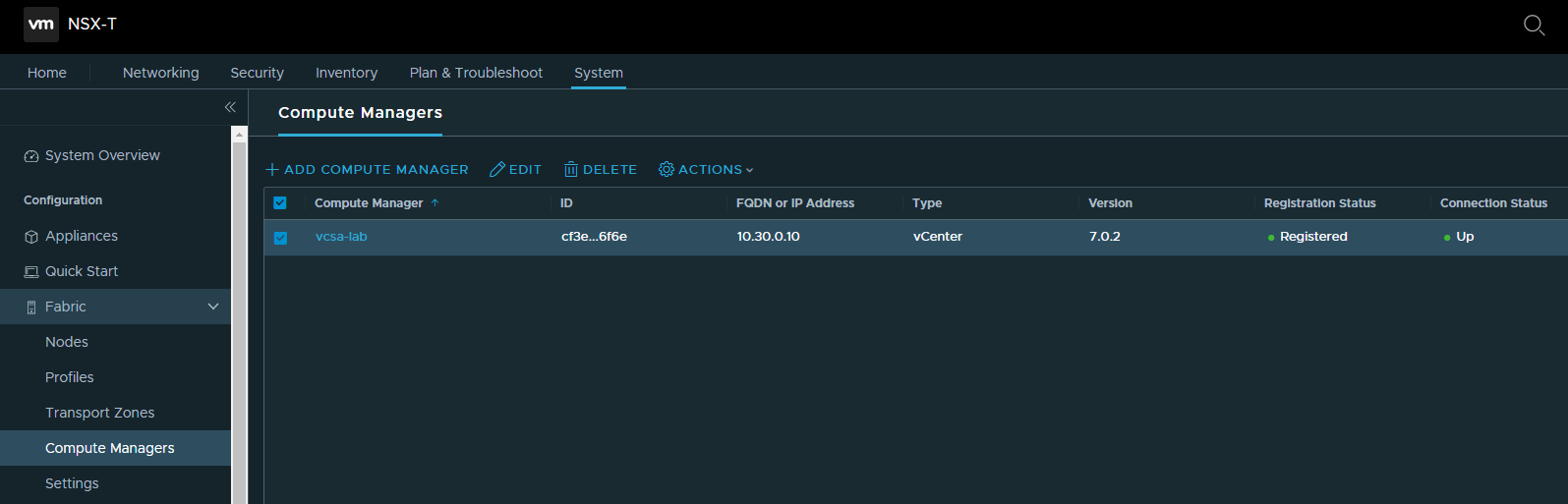

- Configure a compute manager.

- Deploy additional NSX Manager nodes to form a cluster.

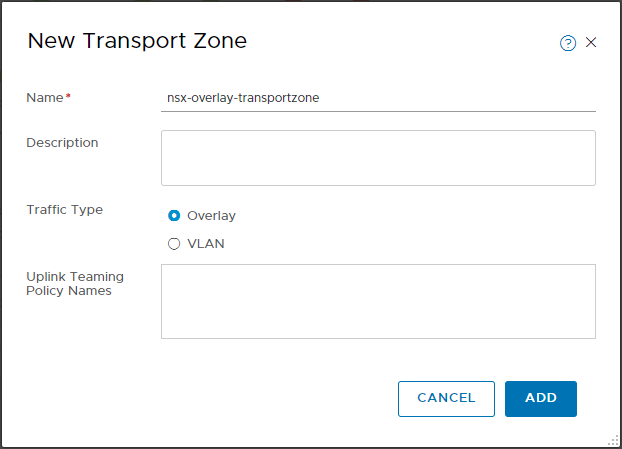

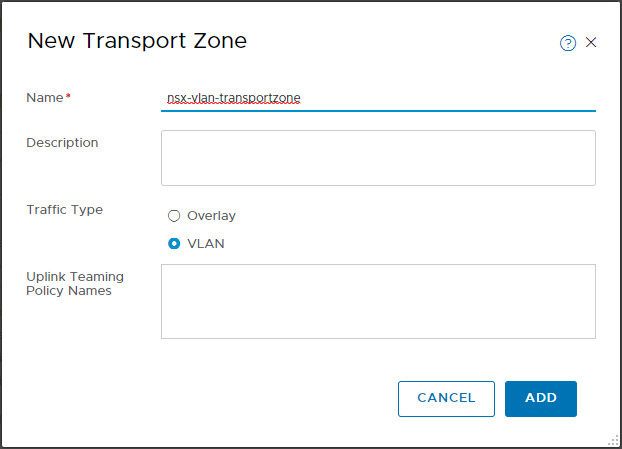

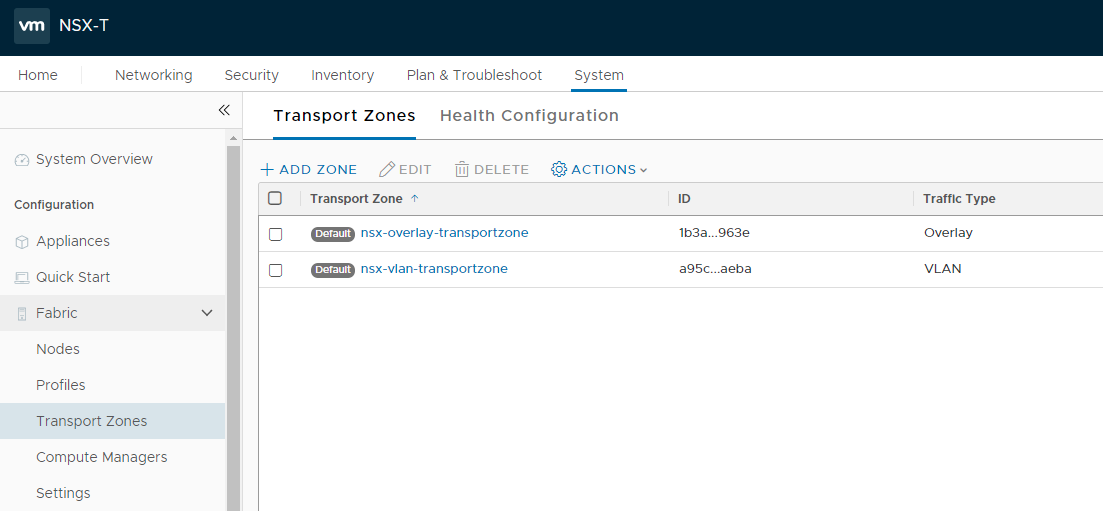

- Create transport zones.

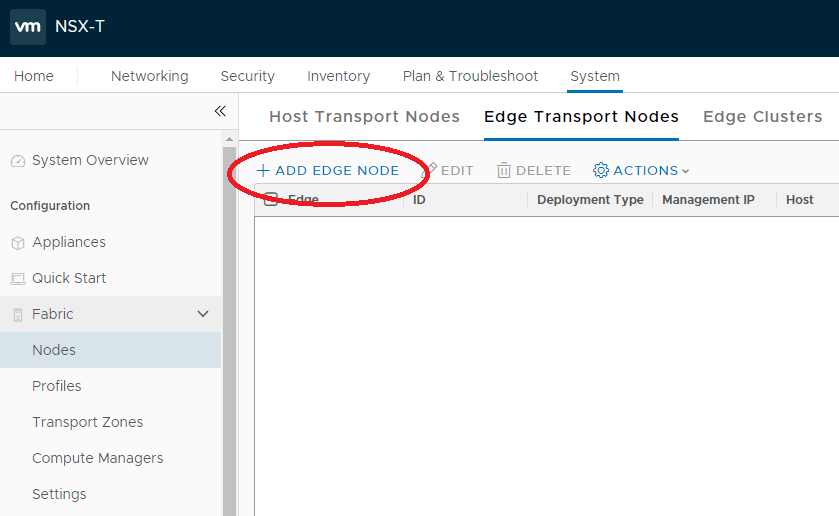

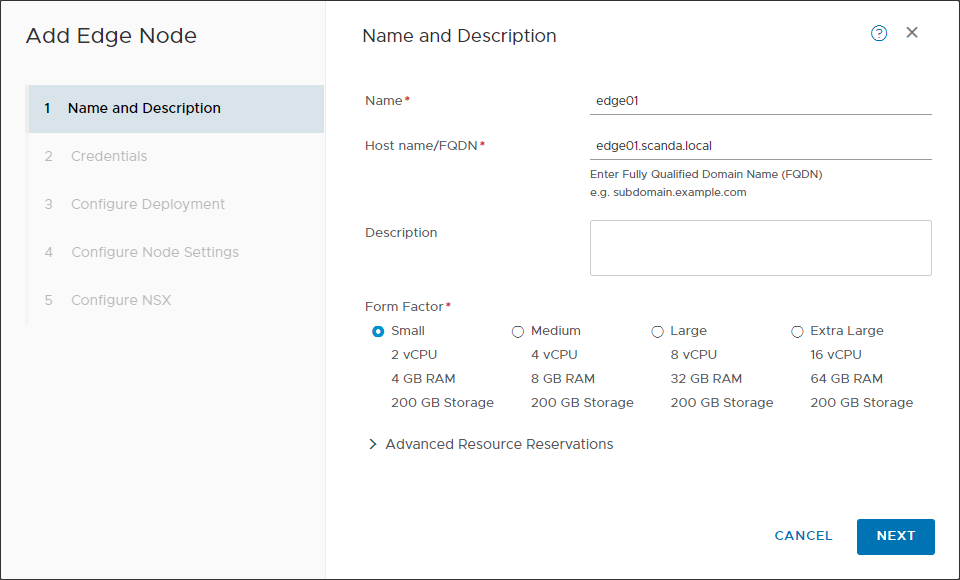

- Review the NSX Edge installation requirements.

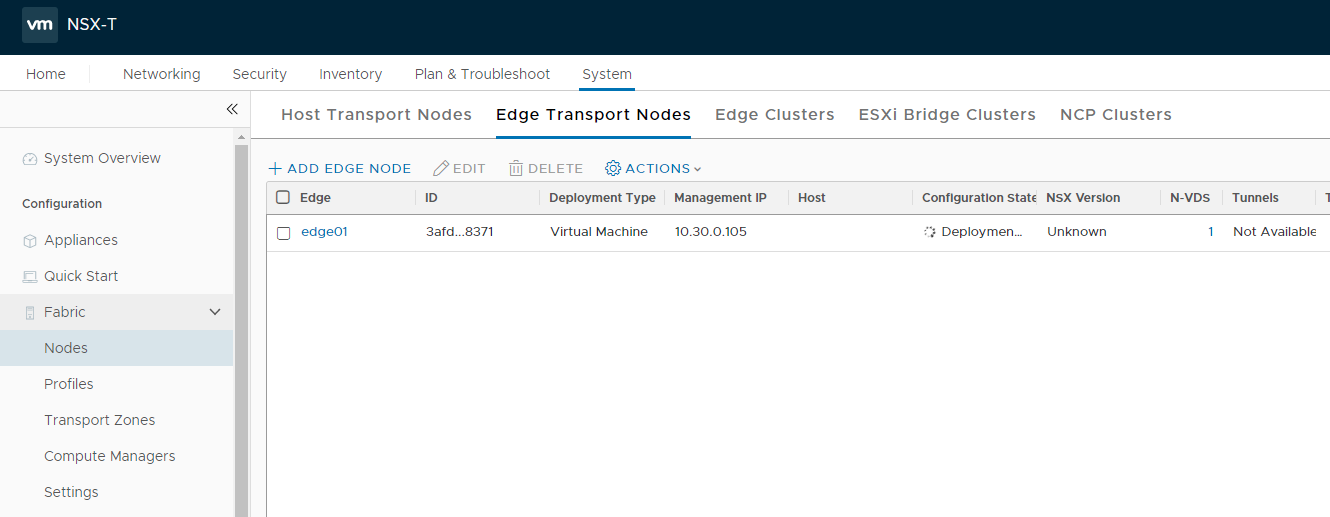

- Install NSX Edges.

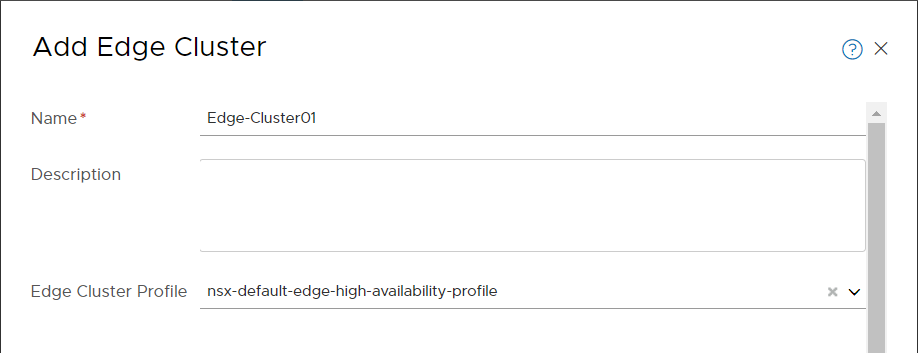

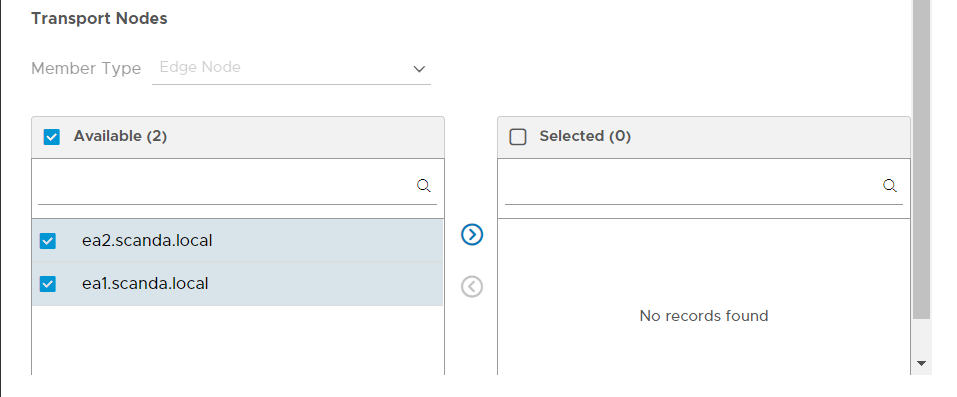

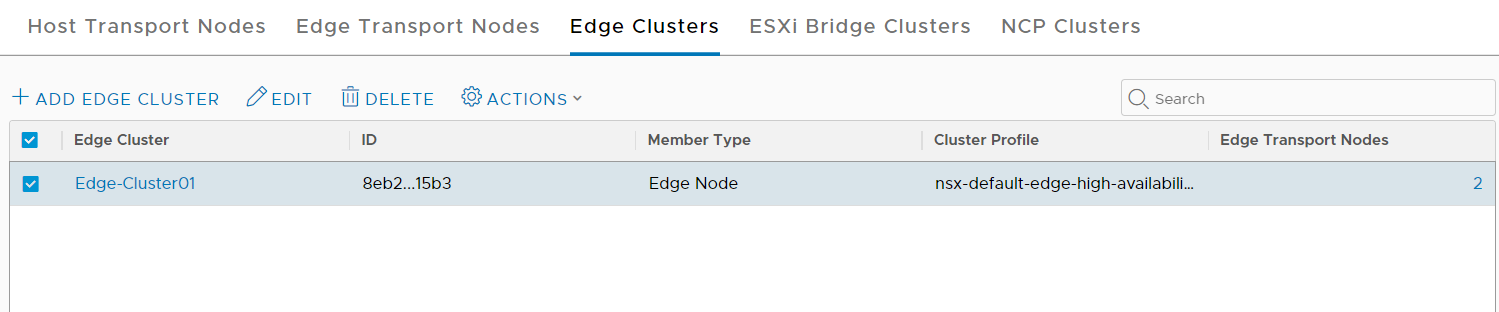

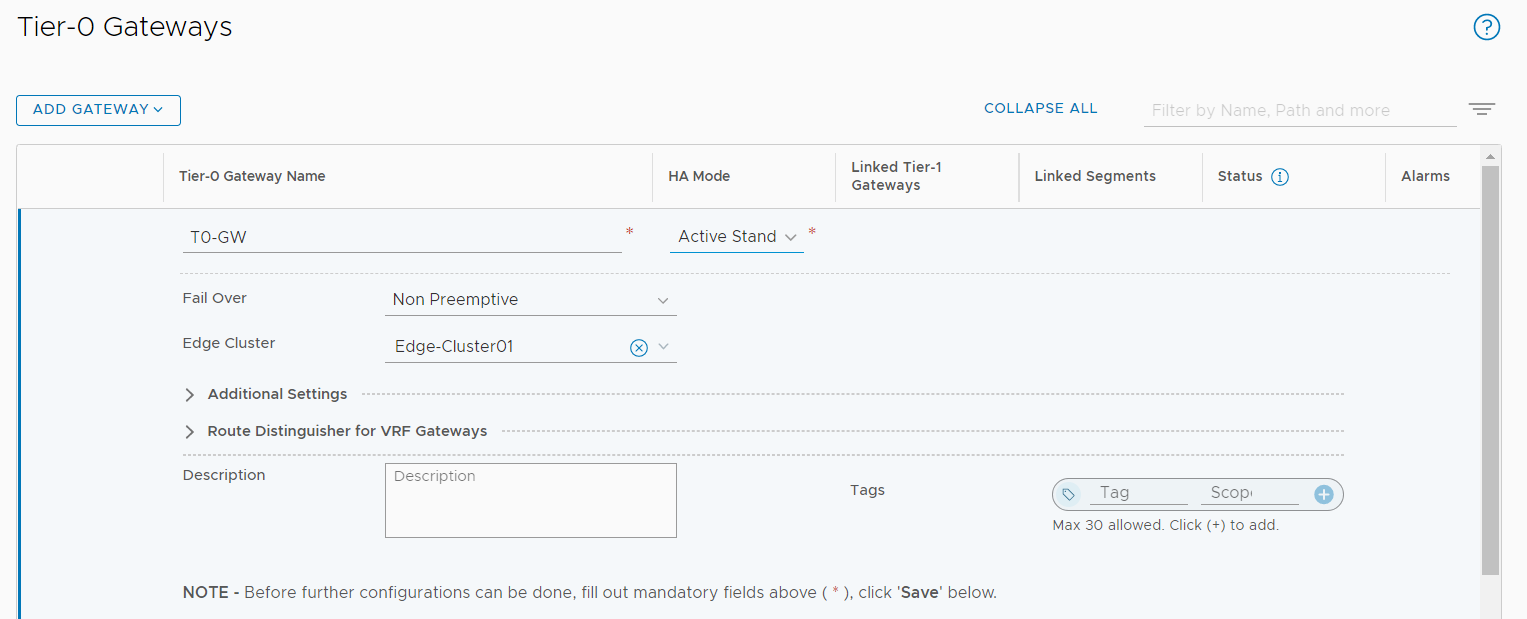

- Create an NSX Edge cluster.

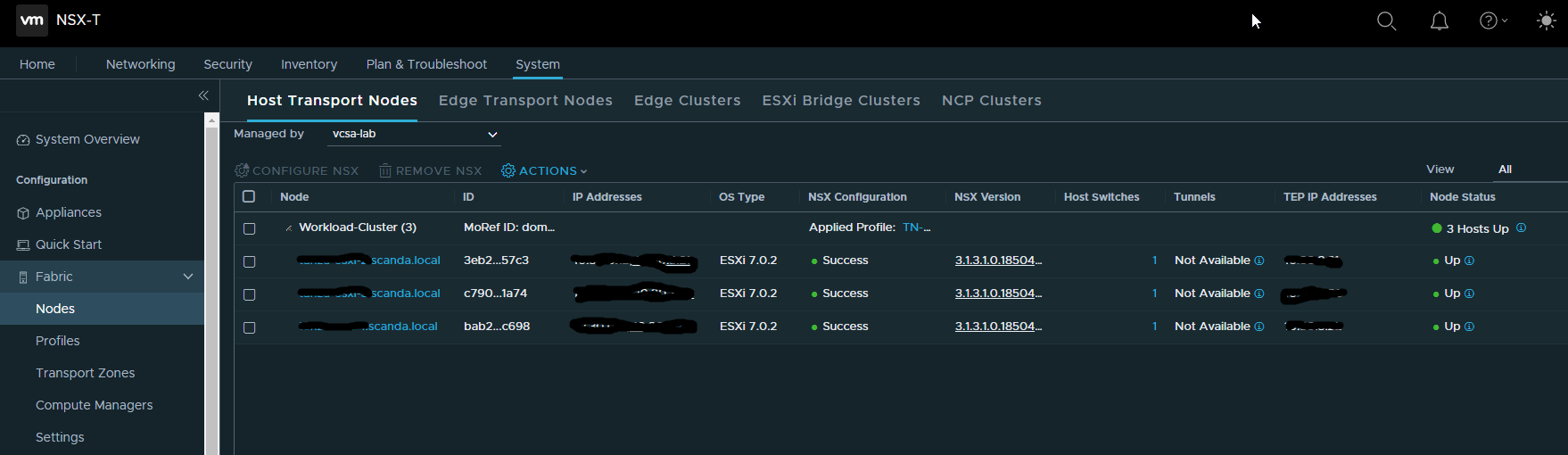

- Create host transport nodes.

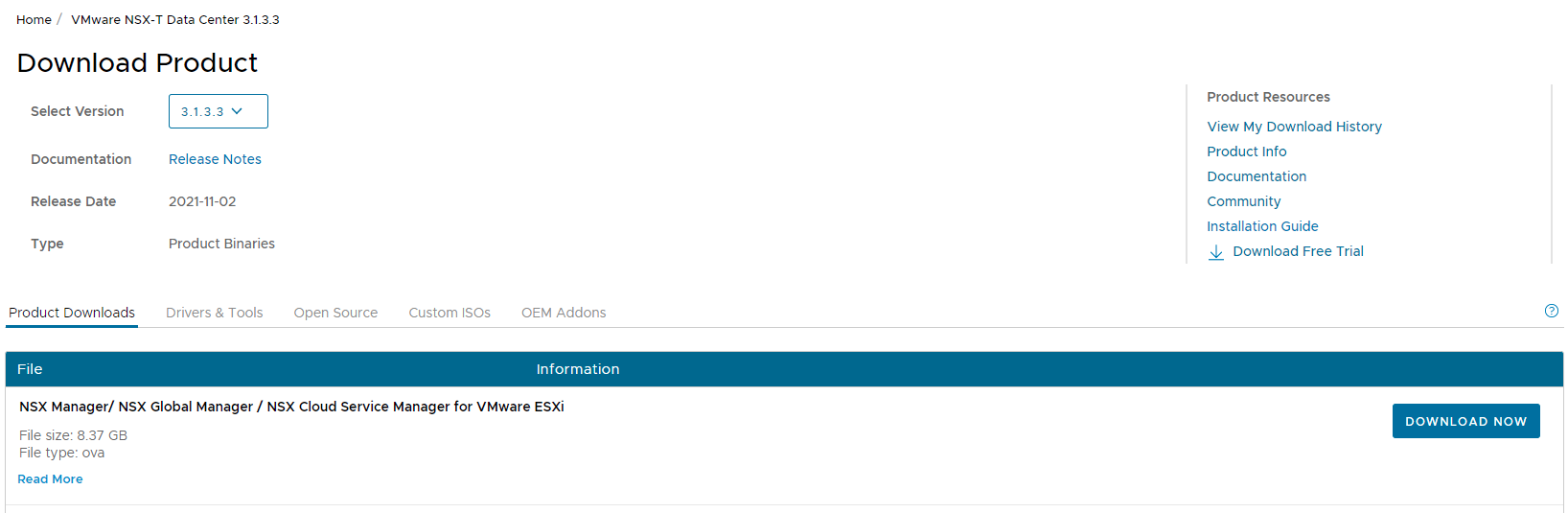

Questo l’articolo va ad approfondire il primo punto, in successione pubblicherò gli articoli di tutti gli altri punti 🙂 La versione di NSX-T di riferimento è la 3.1.

Le informazioni riportate sono tratte da NSX-T Data Center Installation Guide, paragrafo System Requirements.

Versioni di ESXi supportate per il ruolo di Host Transport Nodes

Per maggiori dettagli consultare direttamente la Product Interoperability Matrices

Requisiti minimi di CPU e RAM per il profilo di Transport Node

| Hypervisor | CPU Cores | Memory |

| vSphere ESXi | 4 | 16GB |

Nota : i requisiti HW sono gli stessi anche per KVM su Linux

Requisiti Network

Ogni Host Transport Node deve essere dotato di NIC supportate dalla versione di ESXi installata, non si fa cenno alla velocità minima ma è buona pratica utilizzare almeno 2 NIC da 10G per questioni di performance e ridondanza.

Nota : 2 NIC sono sufficienti ma 4 possono facilitare la migrazione da VSS/VDS al nuovo NVDS. Approfondirò quest’aspetto in un prossimo articolo.

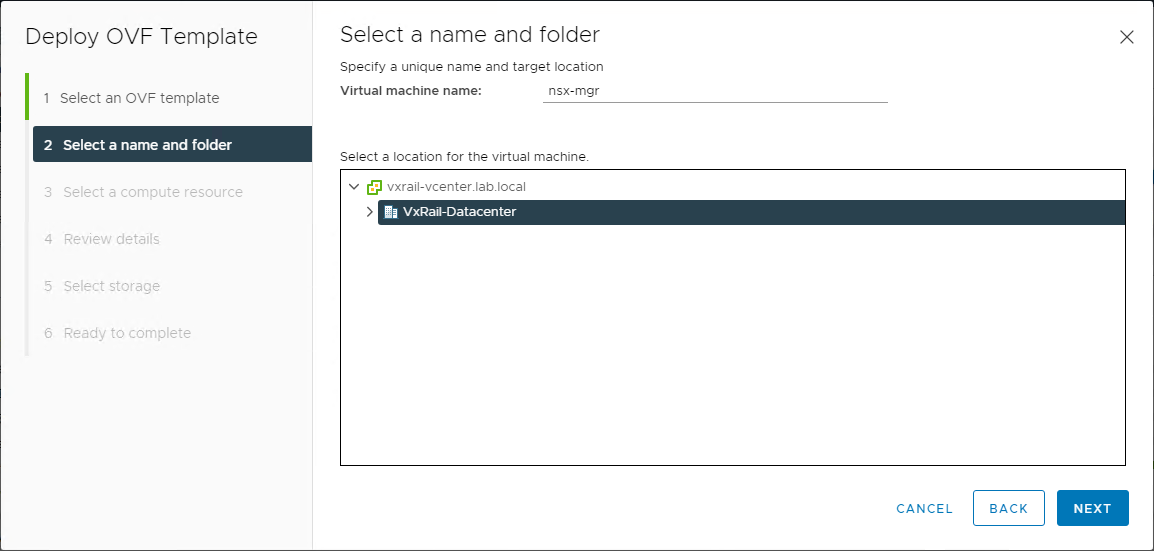

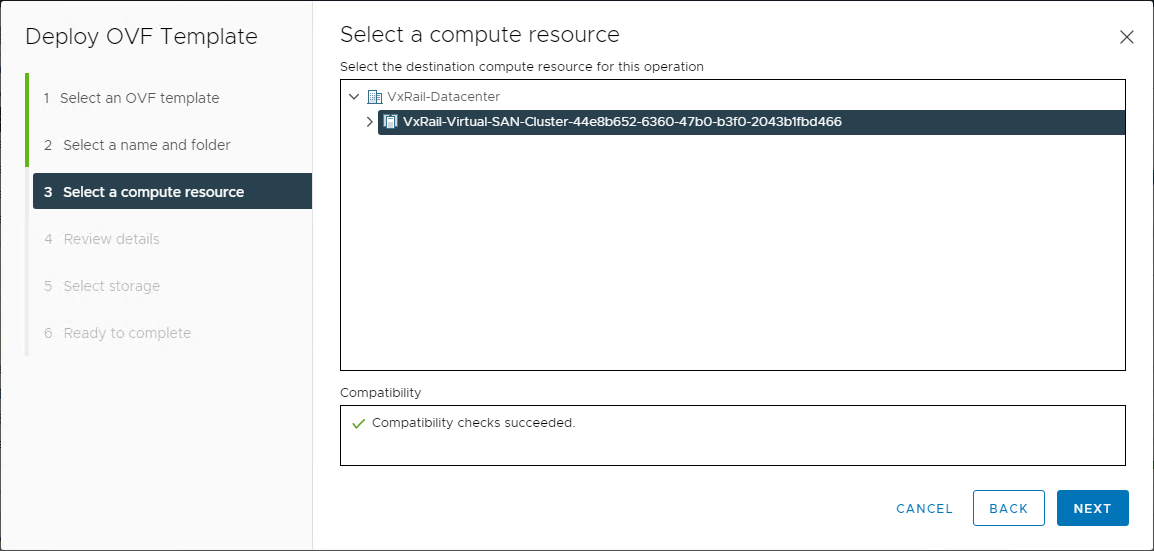

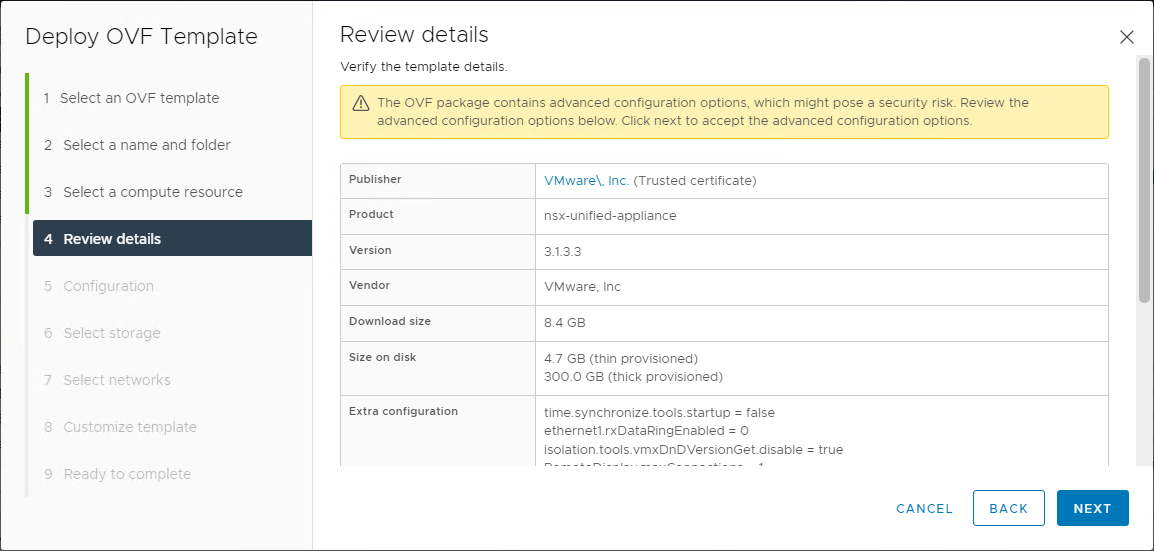

Requisiti per NSX Manager

Il Manager è il cuore di NSX, oltre a permettere la gestione di tutte le configurazioni ingloba anche il ruolo di controller, questi i requisiti per il deploy.

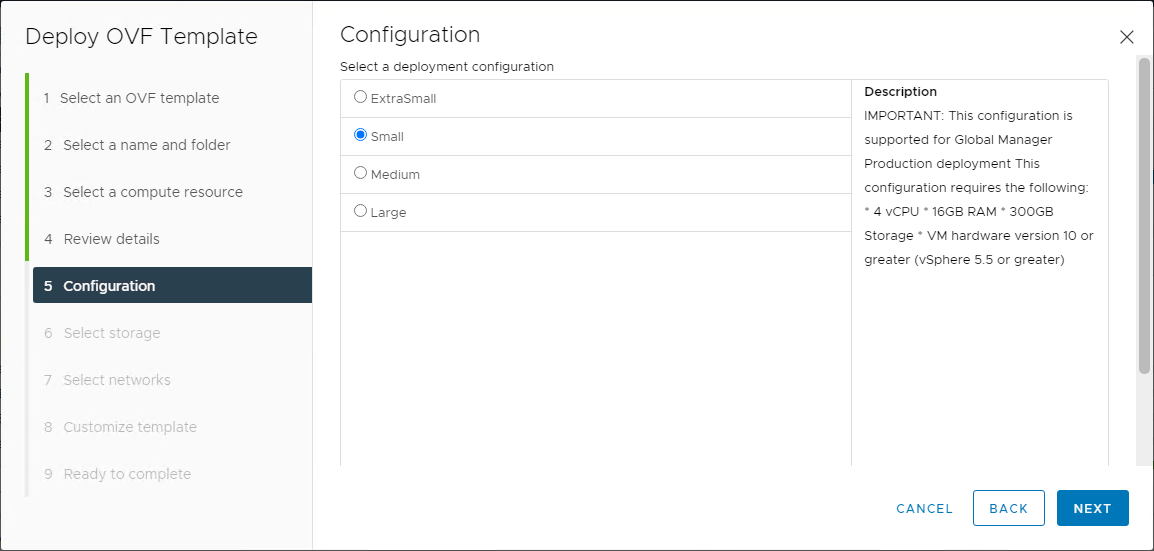

| Appliance Size | Memory | vCPU | Disk Space | Note |

| NSX Manager Extra Small | 8GB | 2 | 300GB | only for the Cloud Service Manager (da NSX-T 3.0) |

| NSX Manager Small VM | 16GB | 4 | 300GB | lab and proof-of-concept deployments (da NSX-T 2.5.1) |

| NSX Manager Medium VM | 24GB | 6 | 300GB | typical production environments - max 64 hypervisor |

| NSX Manager Large VM | 48GB | 12 | 300GB | large-scale deployments - more than 64 hypervisor |

Requisiti latenza di rete

Latenza massima tra i Managers di un cluster : 10ms

Latenza massima tra i Managers e i Transport Nodes : 150ms

Dati forse scontati ma spesso sottovalutati, soprattutto su installazioni distribuite geograficamente.

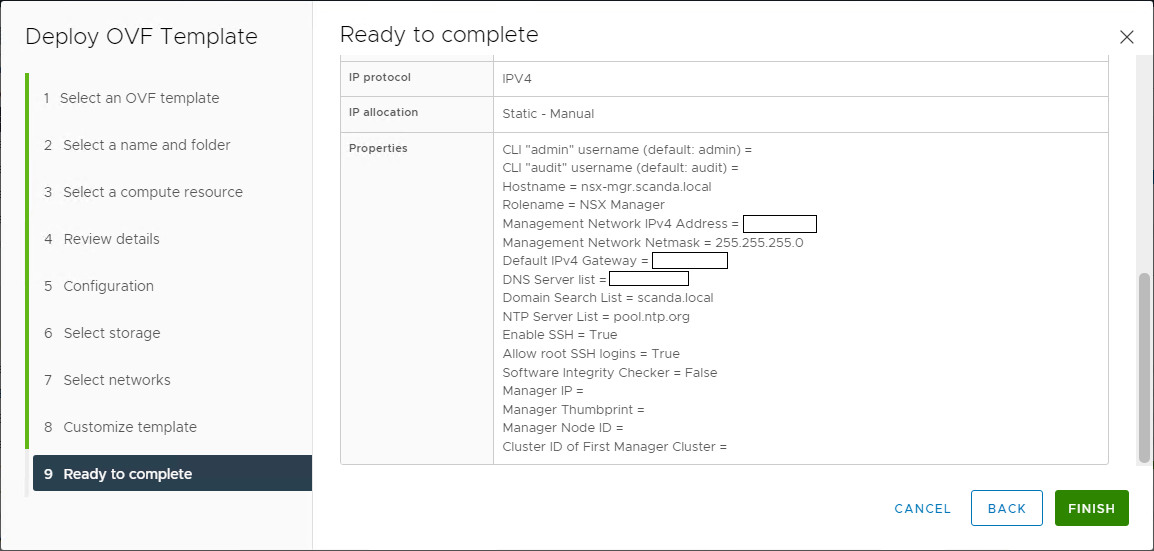

Prerequisiti di indirizzamento e configurazioni DNS

Un’installazione di NSX comprende un cluster di 3 NSX Manager e un cluster Edge con almeno 2 nodi. Questo per ambienti di produzione, per PoC o demo si può tralasciare l’alta affidabilita delle componenti.

Vanno previsti indirizzi IP per ogni oggetto e relativi FQDN sulle zone DNS di pertinenza.

Nota : oltre ai record A è importante prevedere anche delle zone di reverse lookup, la mancanza di questi record può introdurre problemi di raggiungibilità e comunicazione tra le varie componenti.

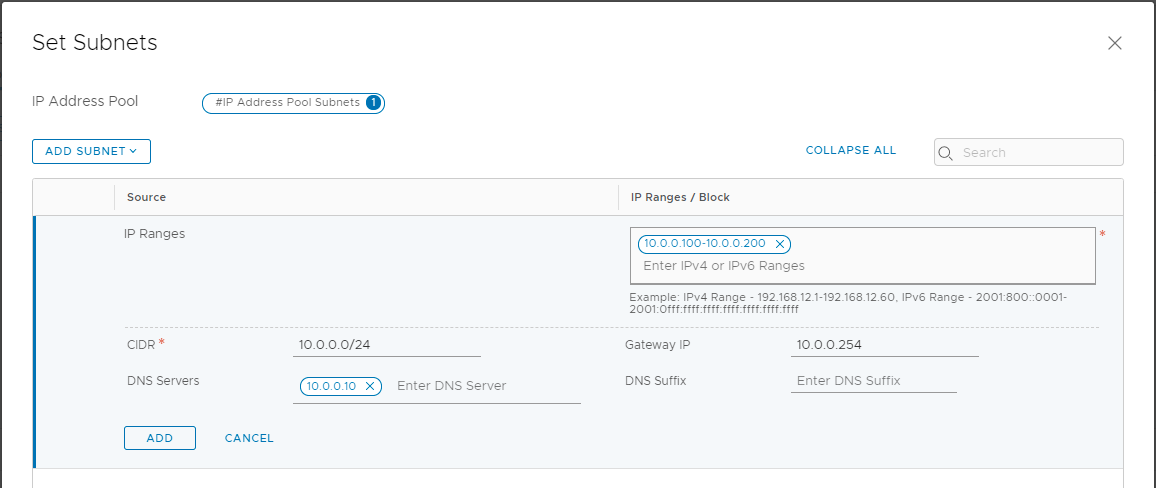

Se è presente anche l’overlay GENEVE va allocata una subnet (IP pool) per i TEP da assegnare ai Transport Nodes. Anche su questo tema avremo modo di fare un approfondimento 🙂

Dimensionamento Totale

Ed in fine tiriamo le somme! Quante risorse vanno allocate per una tipica installazione NSX-T in produzione?

| vCPU | Memory | Storage |

| NSX Manager Medium | 6 | 24GB | 300GB |

| Total x 3 Manager | 18 | 72GB | 900GB |

| | | |

| NSX Edge Medium | 4 | 8GB | 200GB |

| Total x 2 Edge | 8 | 16GB | 400GB |

| | | |

| Total resources | 26 | 88GB | 1.3 TB |

Le risorse richieste da NSX-T non sono trascurabili, su piccole infrastrutture possono avere un forte impatto. Su ambienti di una certa entità NSX Manager viene installato su un apposito cluster di Management assieme ad altri oggetti quali vRealize Log Insight e vRealize Network Insight.

Conoscere i requisiti di NSX-T e fare un corretto dimensionamento è di certo il primo punto da cui partire per una corretta installazione.

Concludo l’articolo lasciandovi un piccolo compito, verificate se la vostra infrastruttura ha le risorse per installare NSX! Non le avete? Allora progettate un nuovo cluster di Management 🙂