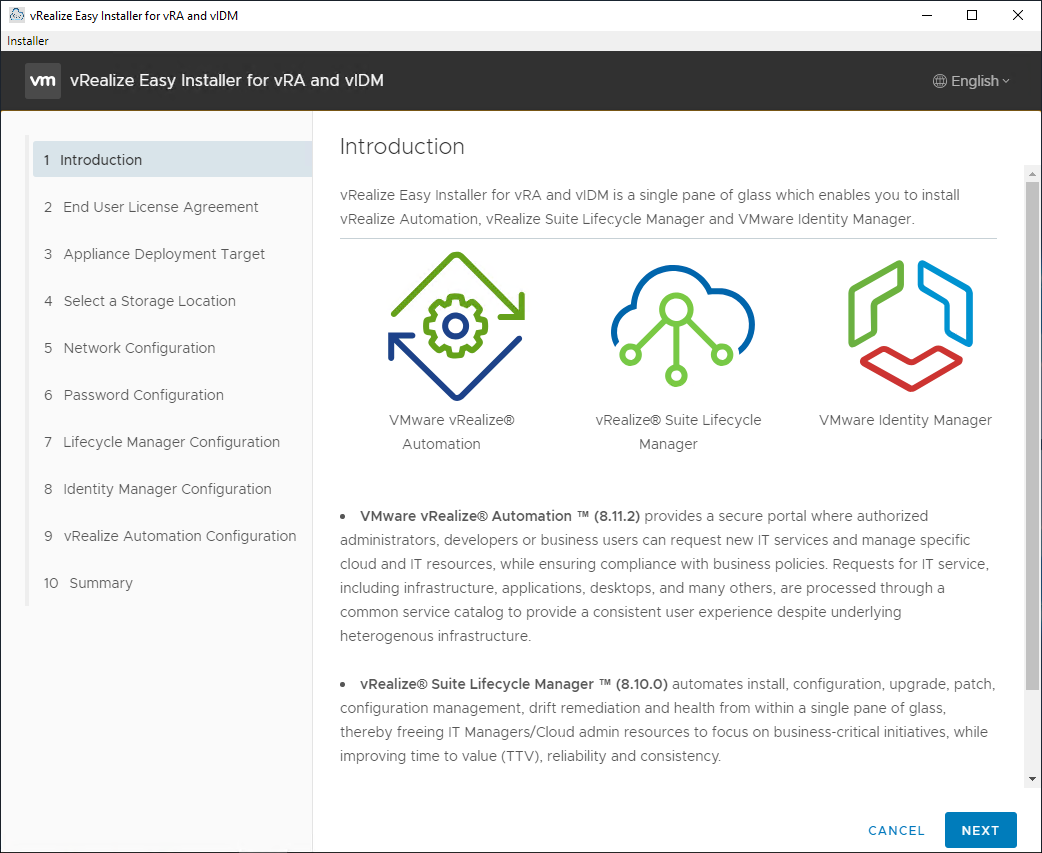

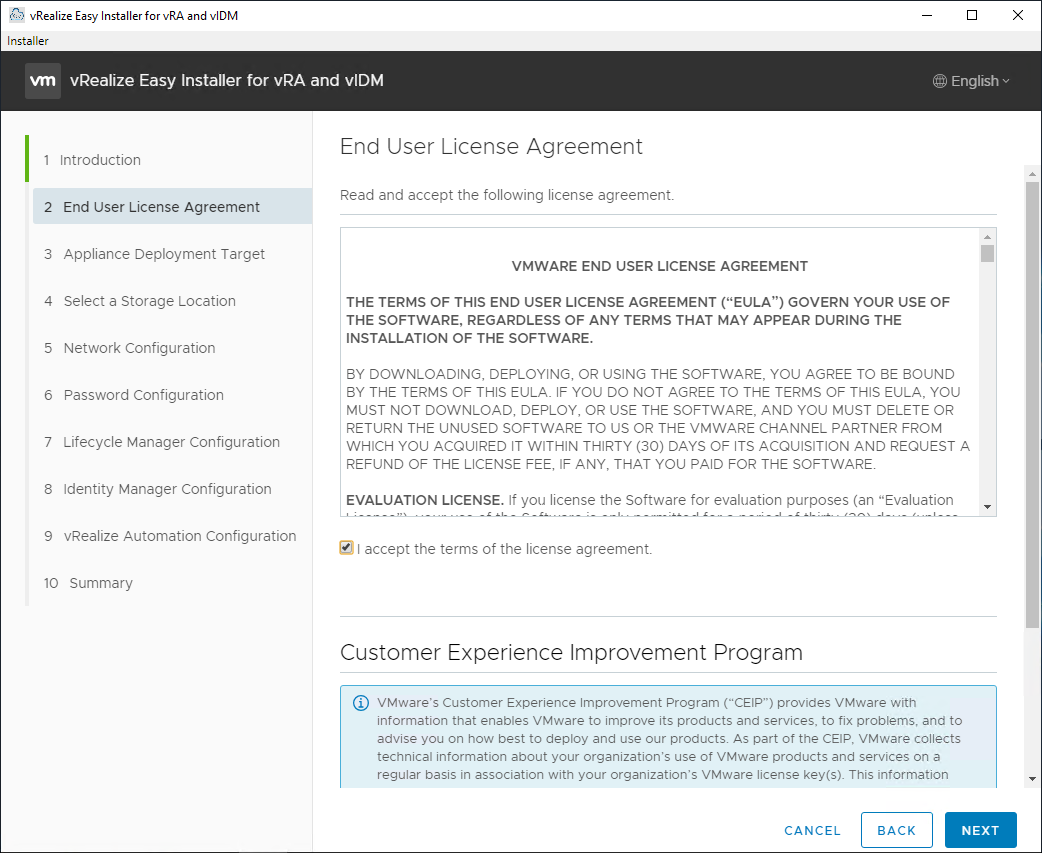

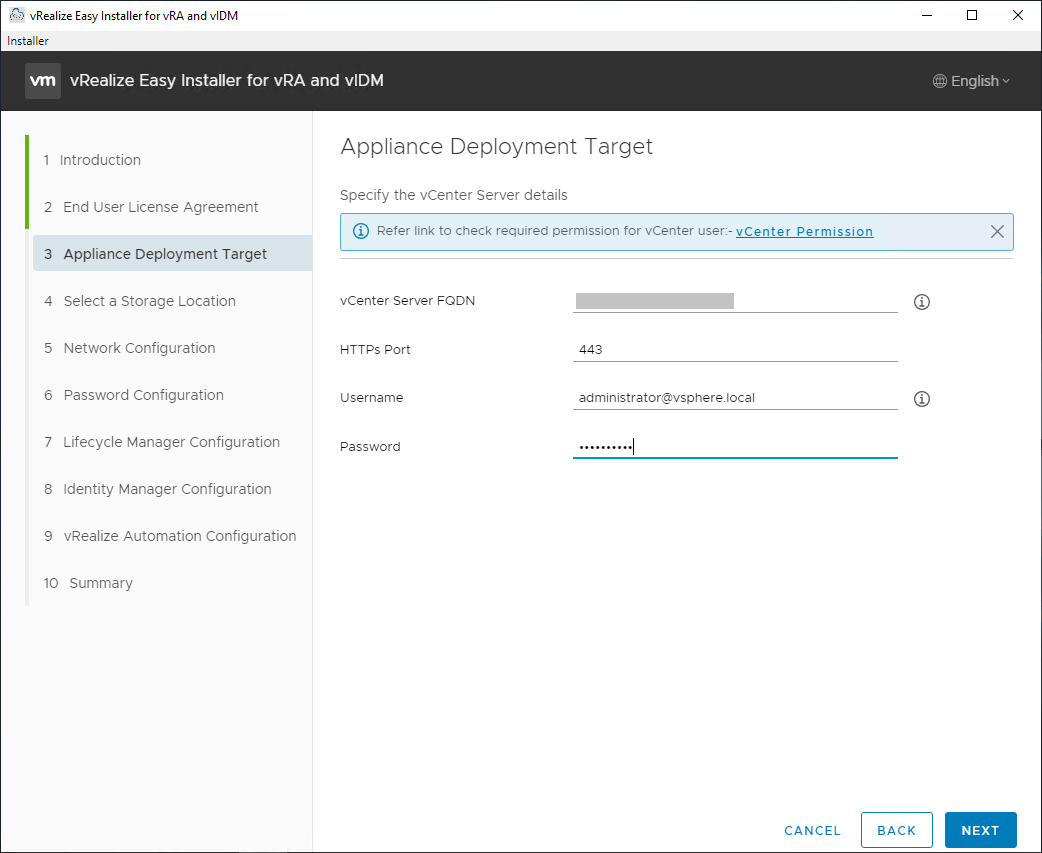

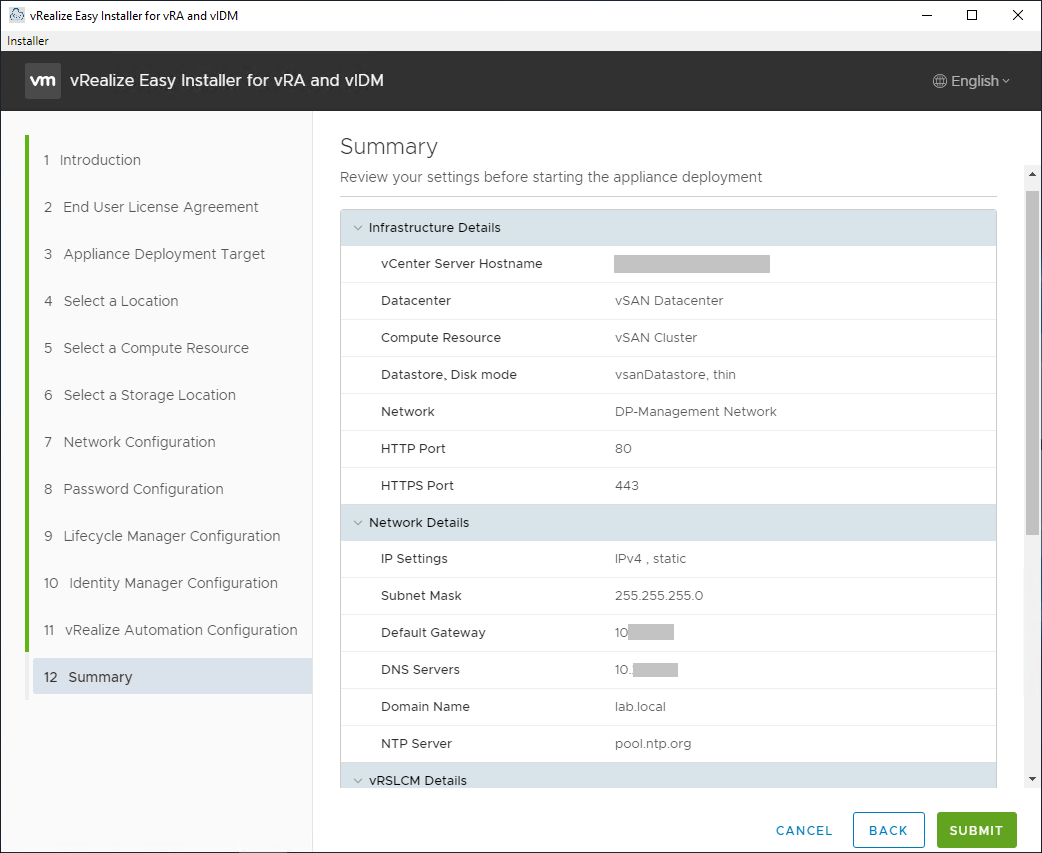

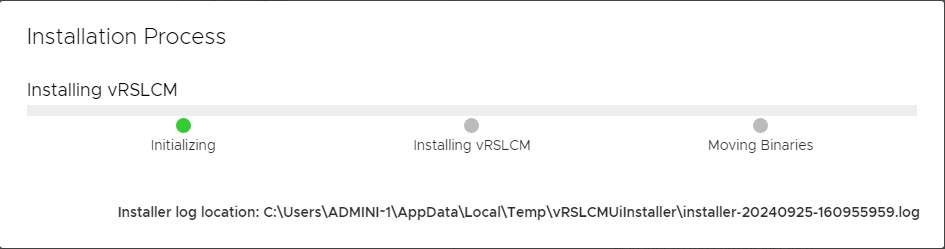

E adesso viene il bello 🙂 Come avete visto l’installazione con Easy Installer non è complicata, l’upgrade richiede delle attenzioni in più.

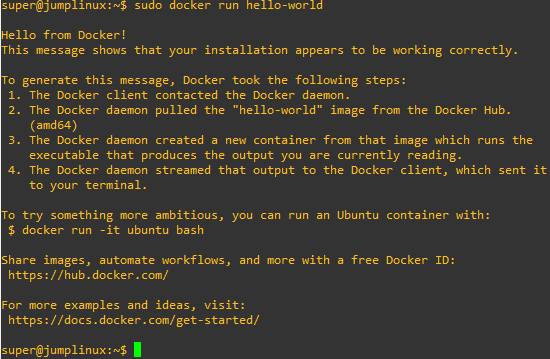

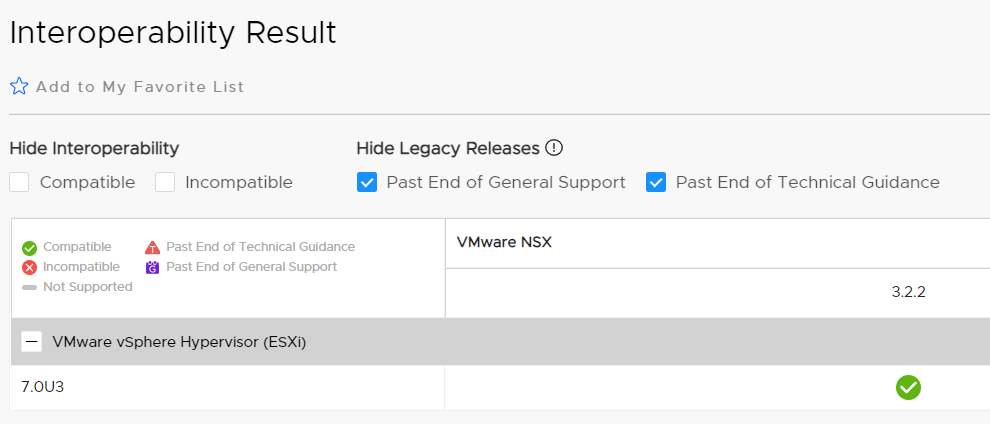

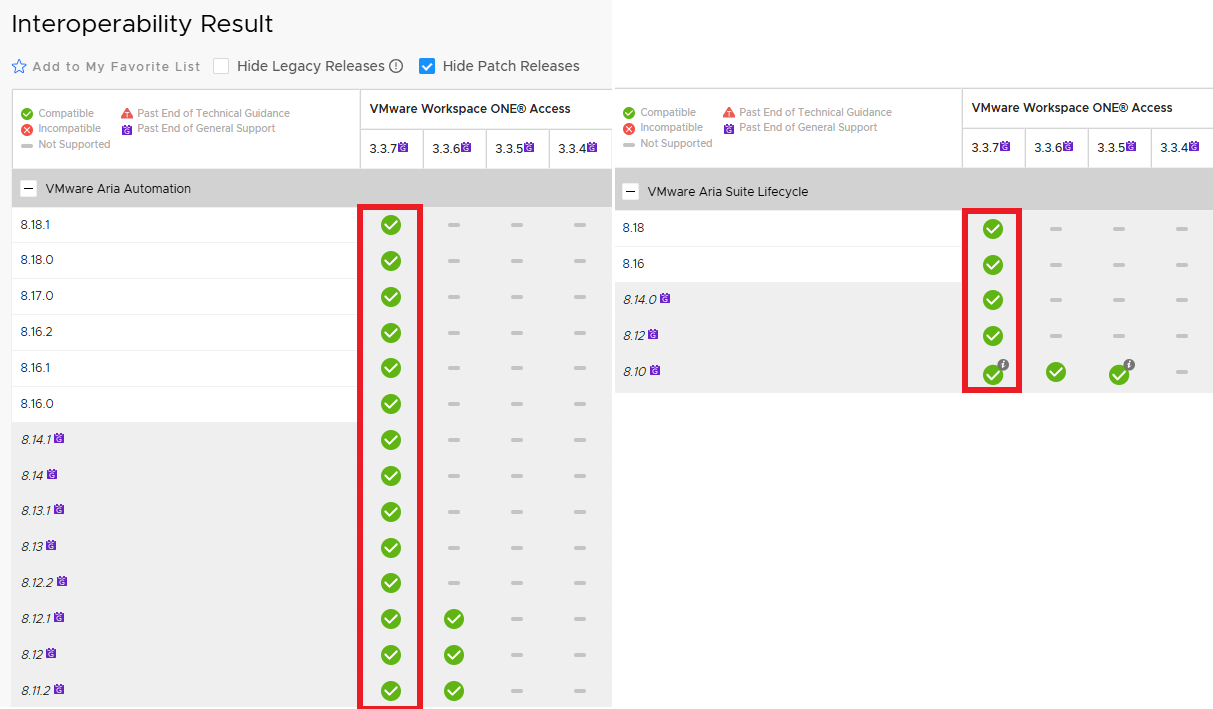

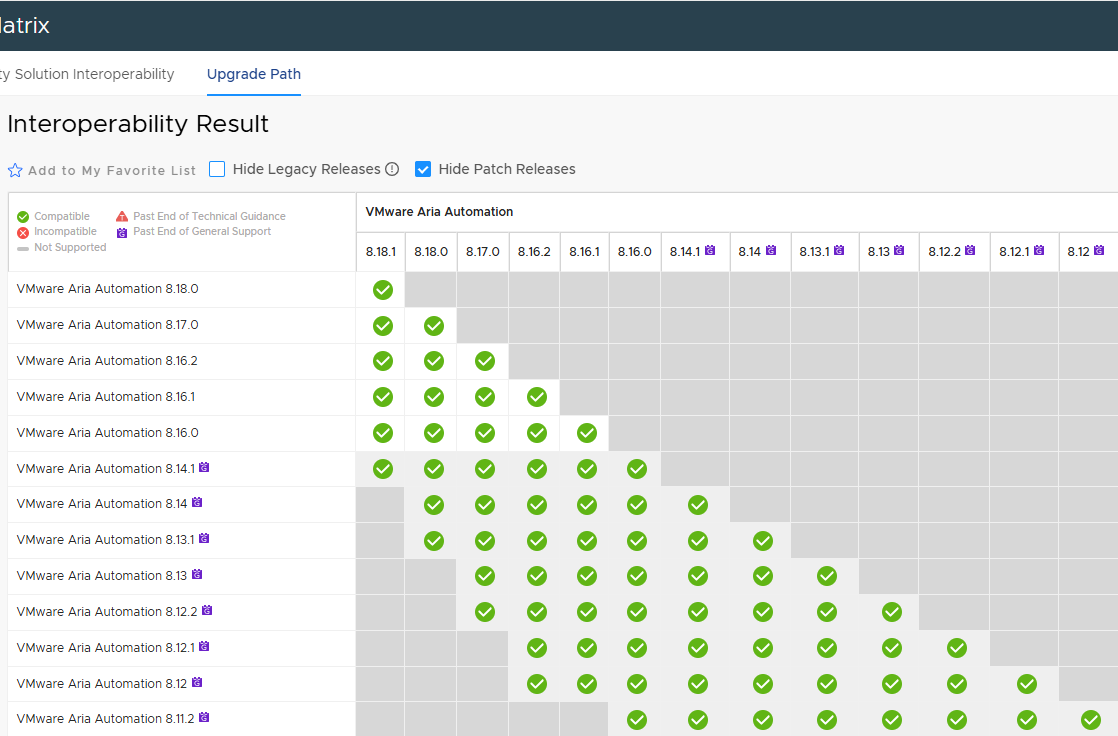

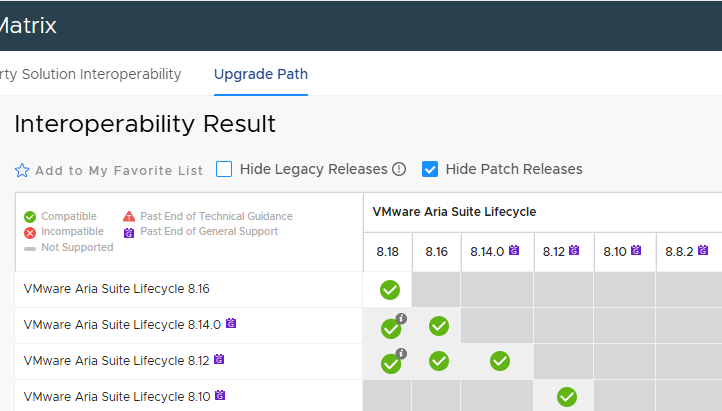

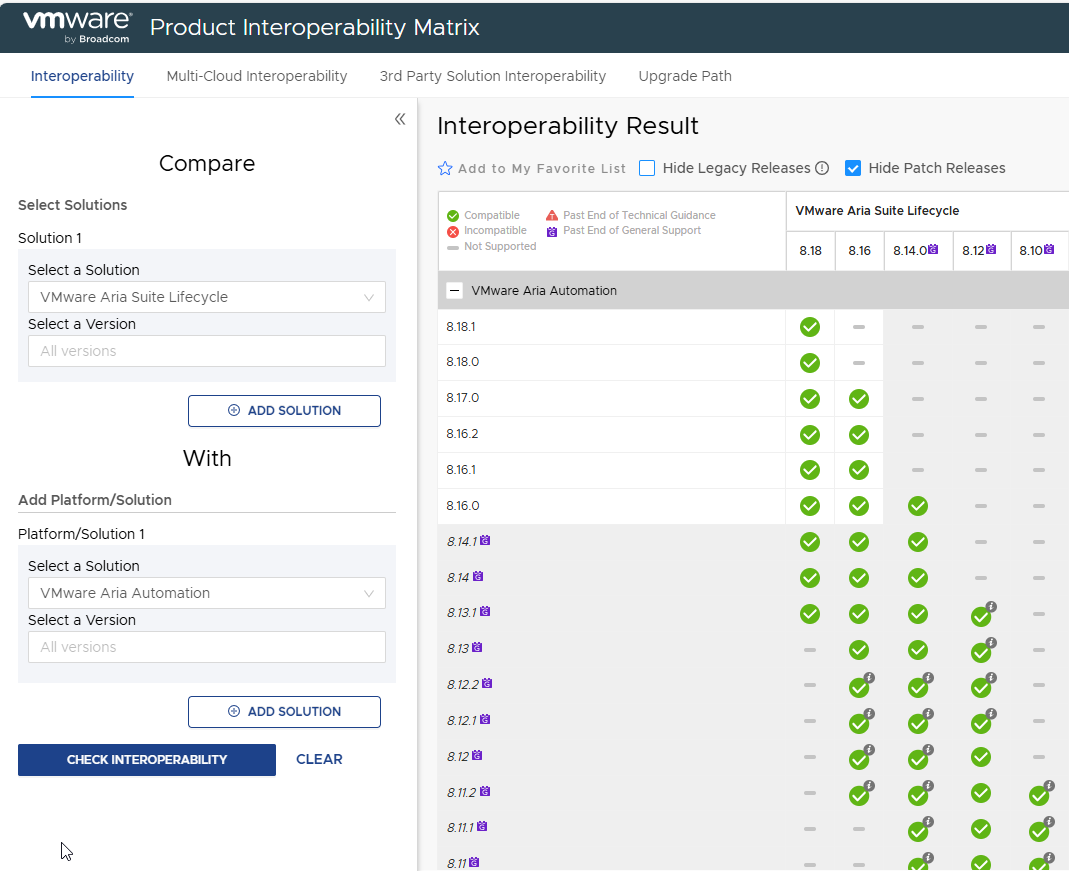

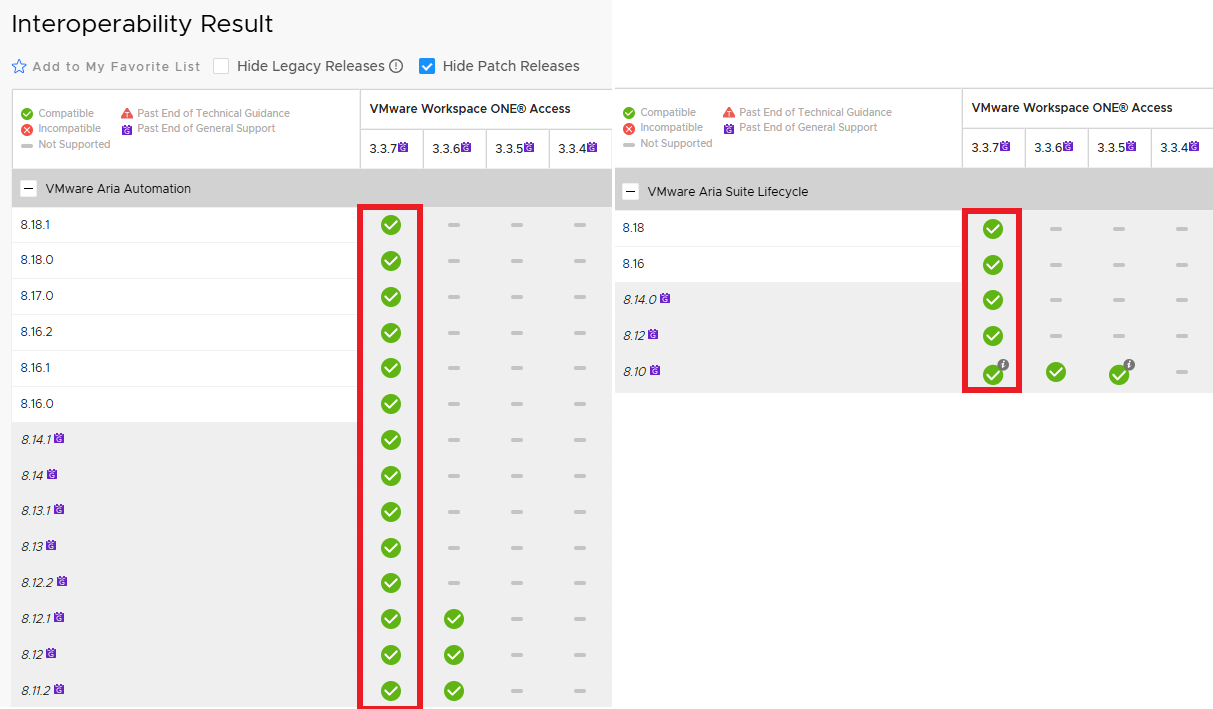

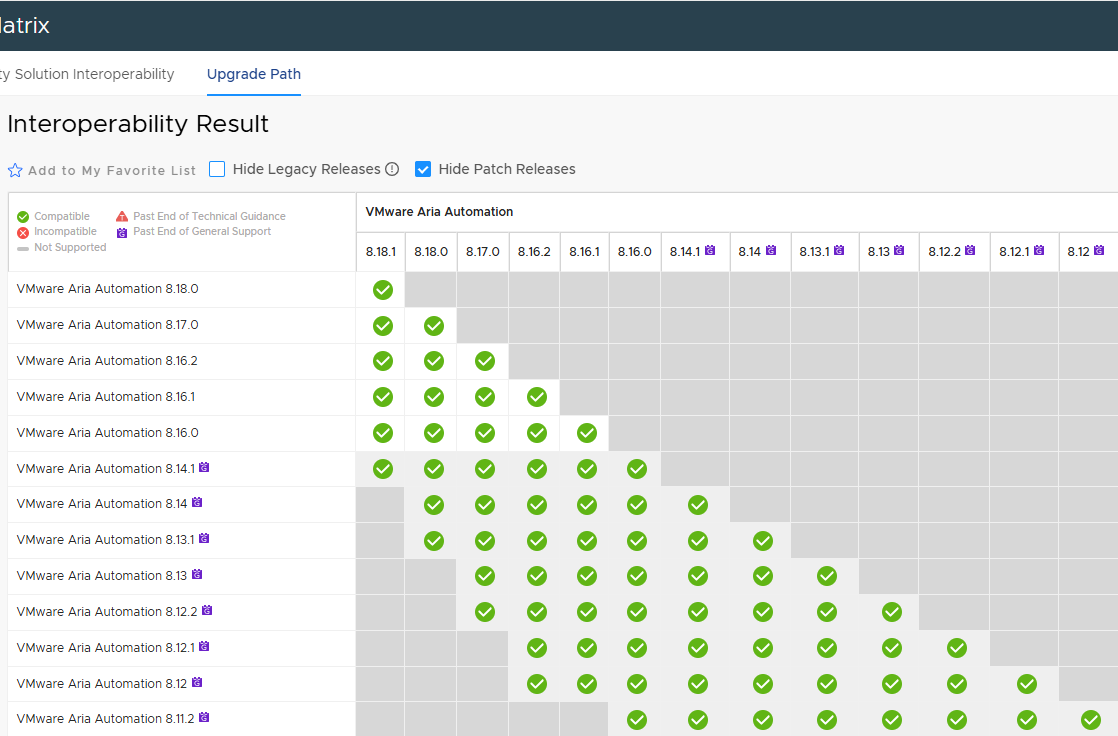

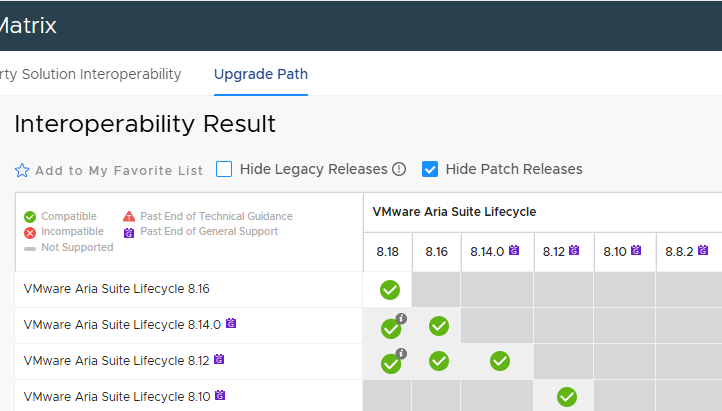

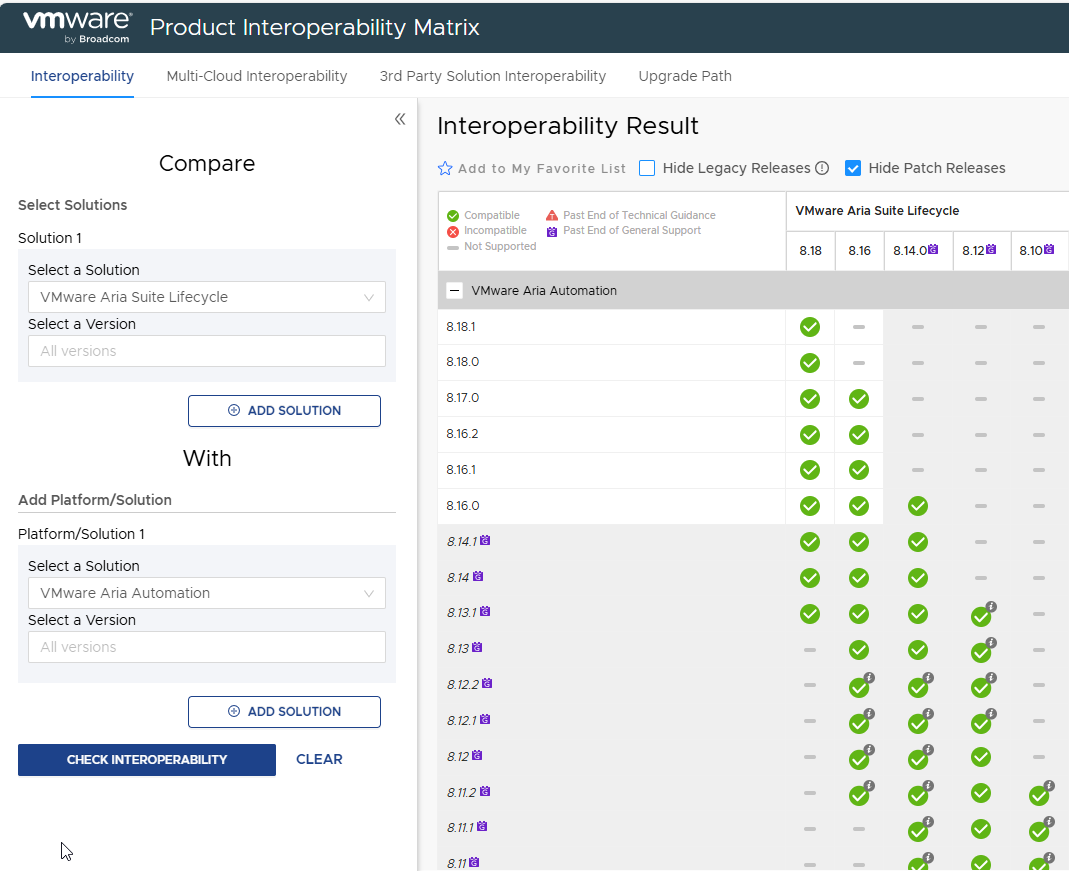

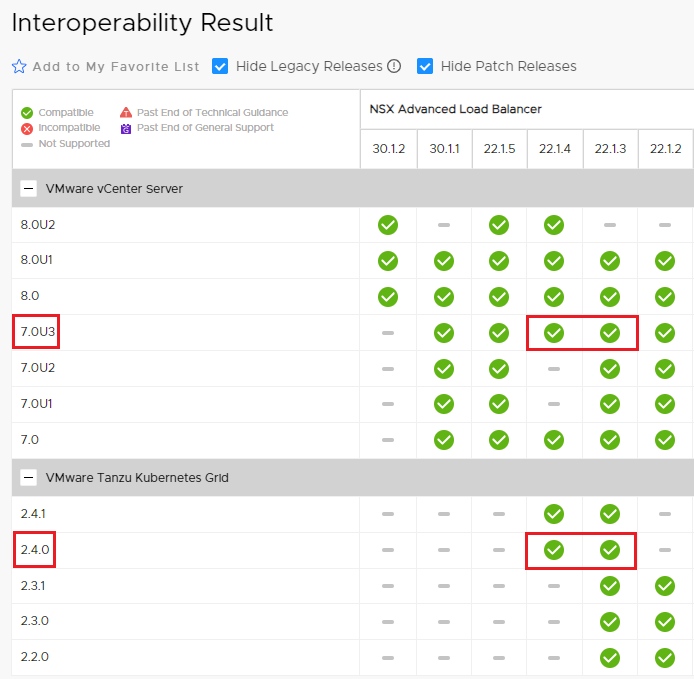

Per prima cosa bisogna verificare i path di upgrade dei prodotti coinvolti e la relativa matrice di compatibilità. Durante tutto il processo di upgrade dobbiamo garantire piena interoperabilità tra i Lifecycle manager, Workspace ONE e Aria Automation.

Per Workspace ONE (per semplicità IDM) la cosa è semplice, l’attuale versione è in matrice con Lifecycle manager e Automation.

La cosa si complica un pò con LCM e Automation.

Ricordiamoci che le varie versioni devono essere compatibili tra loro!

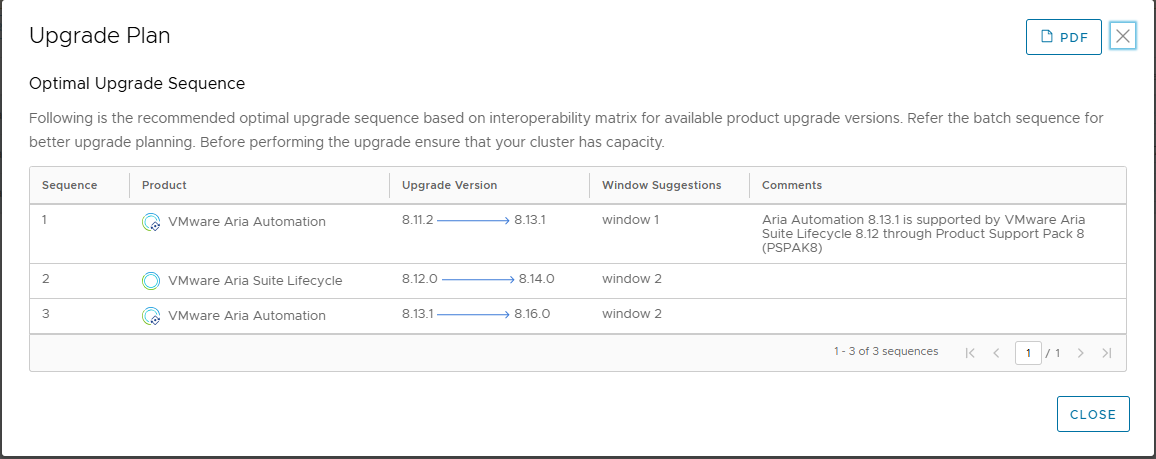

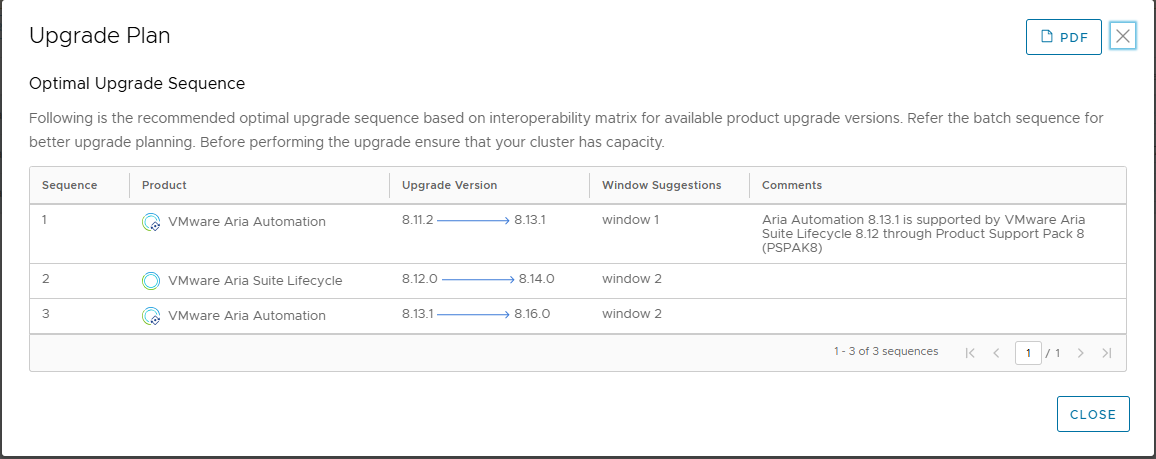

Incrociando il tutto, e verificando i vari passaggi in laboratorio, ho ottenuto il seguente upgrade path

| Upgrade order | Product | Source Release | Destination Release |

| 1 | LCM | 8.10 | 8.12 |

| 2 | Automation | 8.11.2 | 8.13.1 |

| 3 | LCM | 8.12 | 8.14 |

| 4 | Automation | 8.13.1 | 8.16 |

| 5 | LCM | 8.14 | 8.16 |

| 6 | LCM | 8.16 | 8.18 |

| 7 | Automation | 8.16 | 8.18 |

L’upgrade path risultante non è semplice, in alcuni passaggi ho dovuto risolvere alcuni problemi bloccanti. Come sempre vale la pena tenere aggiornata l’infrastruttura periodicamente, dover fare così tanti salti in poco tempo diventa molto più rischioso.

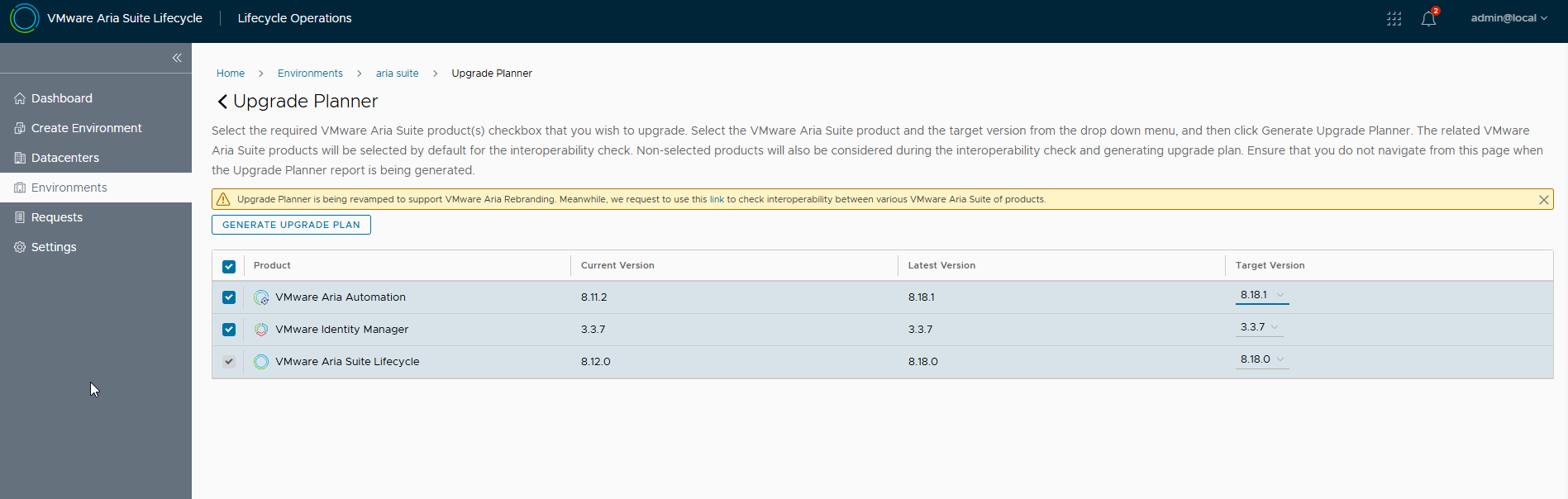

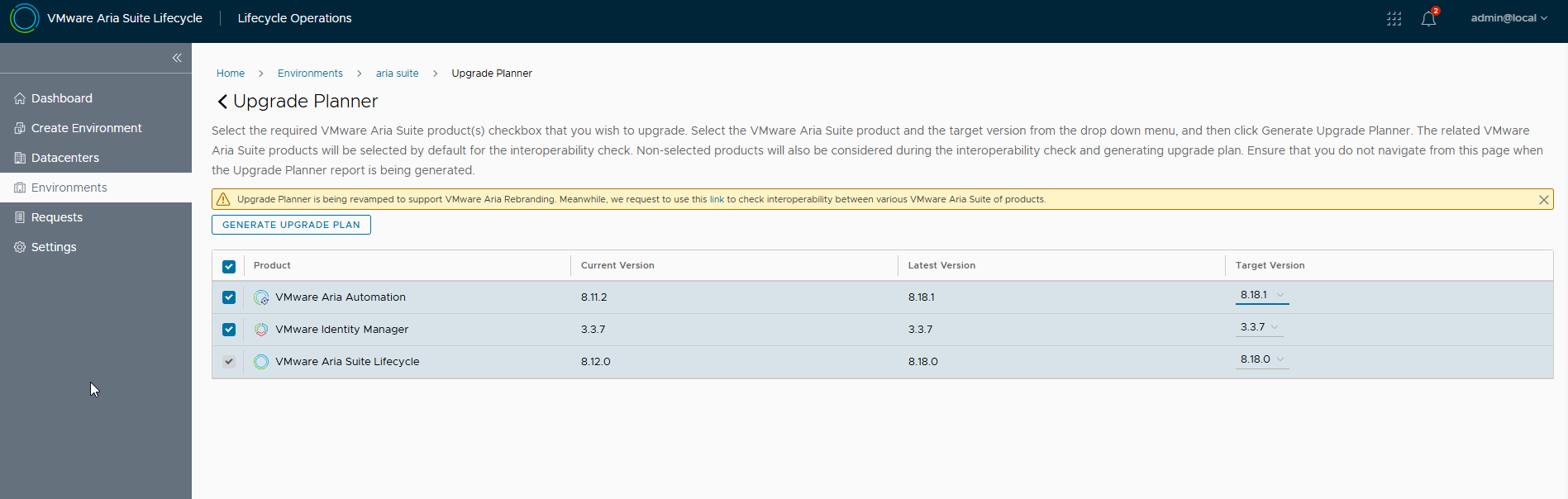

Lifecycle manager mette a disposizione il tool Upgrade Planner all’interno dell’environment che ospita Aria Automation, purtroppo la versione 8.10 (installata con Easy Installer) mi ha dato vari errori e non era utilizzabile 🙁

Solo dopo l’upgrade alla 8.12 ha iniziato a funzionare, ma ha è tornato a non funzionare correttamente dopo alcune release. Il mio consiglio è di utilizzare gli upgrade path e le matrici di compatibilità del sito.

Vediamo comunque un immagine del tool funzionante, riflette il path upgrade corretto 🙂

Dall’environment selezionare UPGRADE PLANNER, successivamente si può specificare la release di arrivo, selezionare i flag dei prodotti ed eseguire GENERATE UPGRADE PLAN

Ecco il risultato

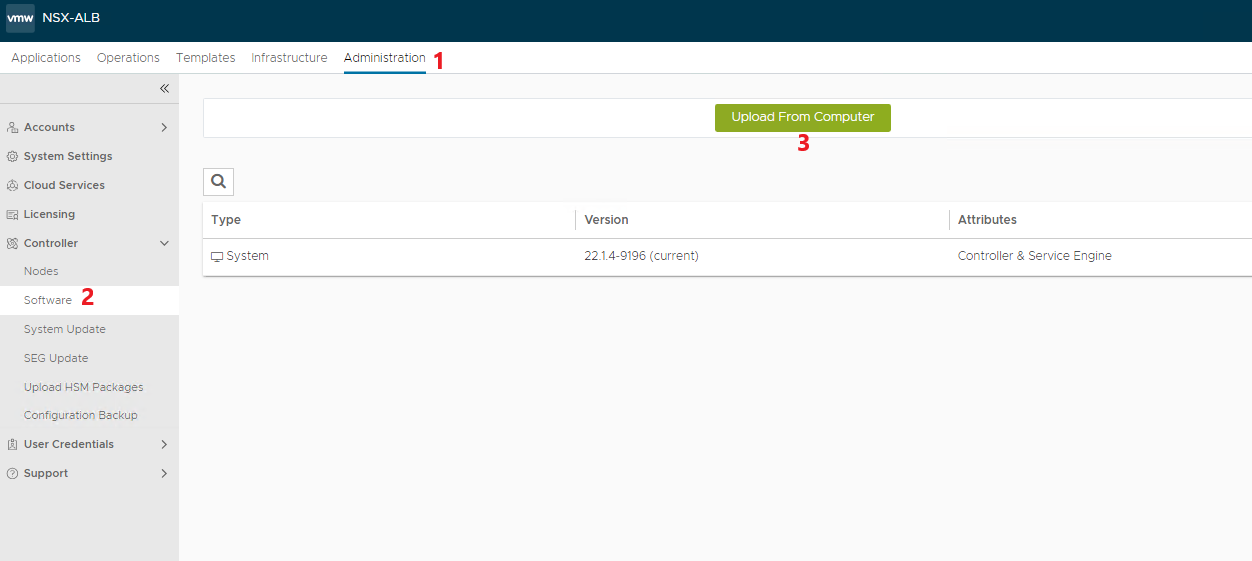

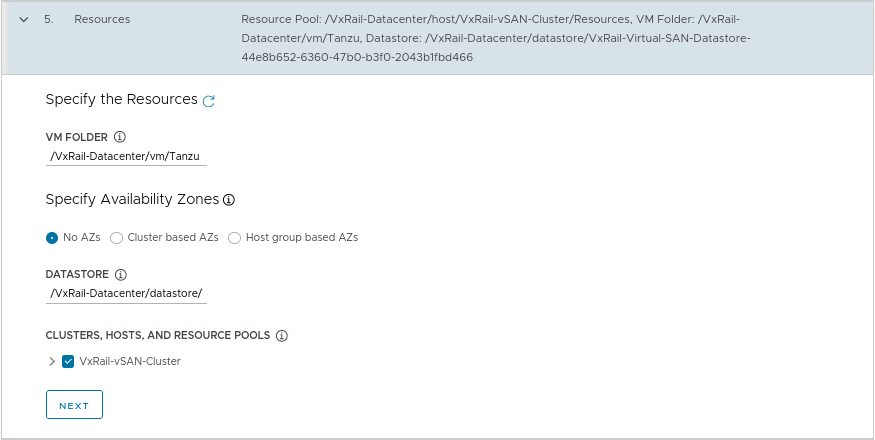

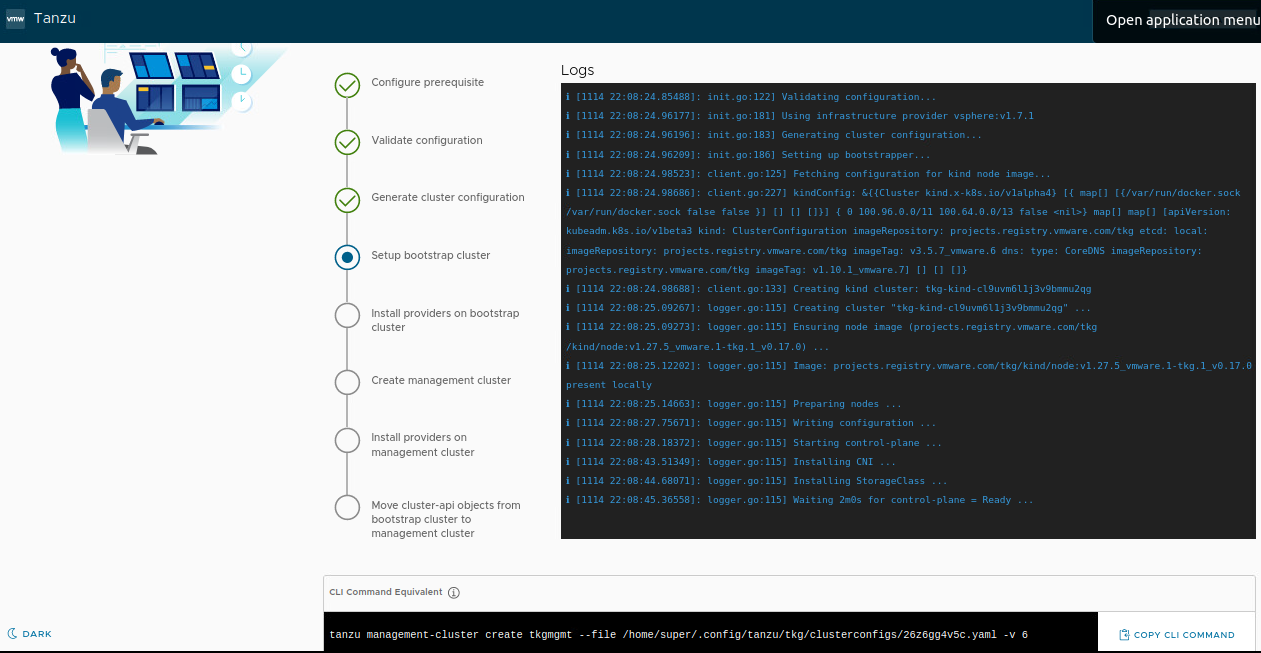

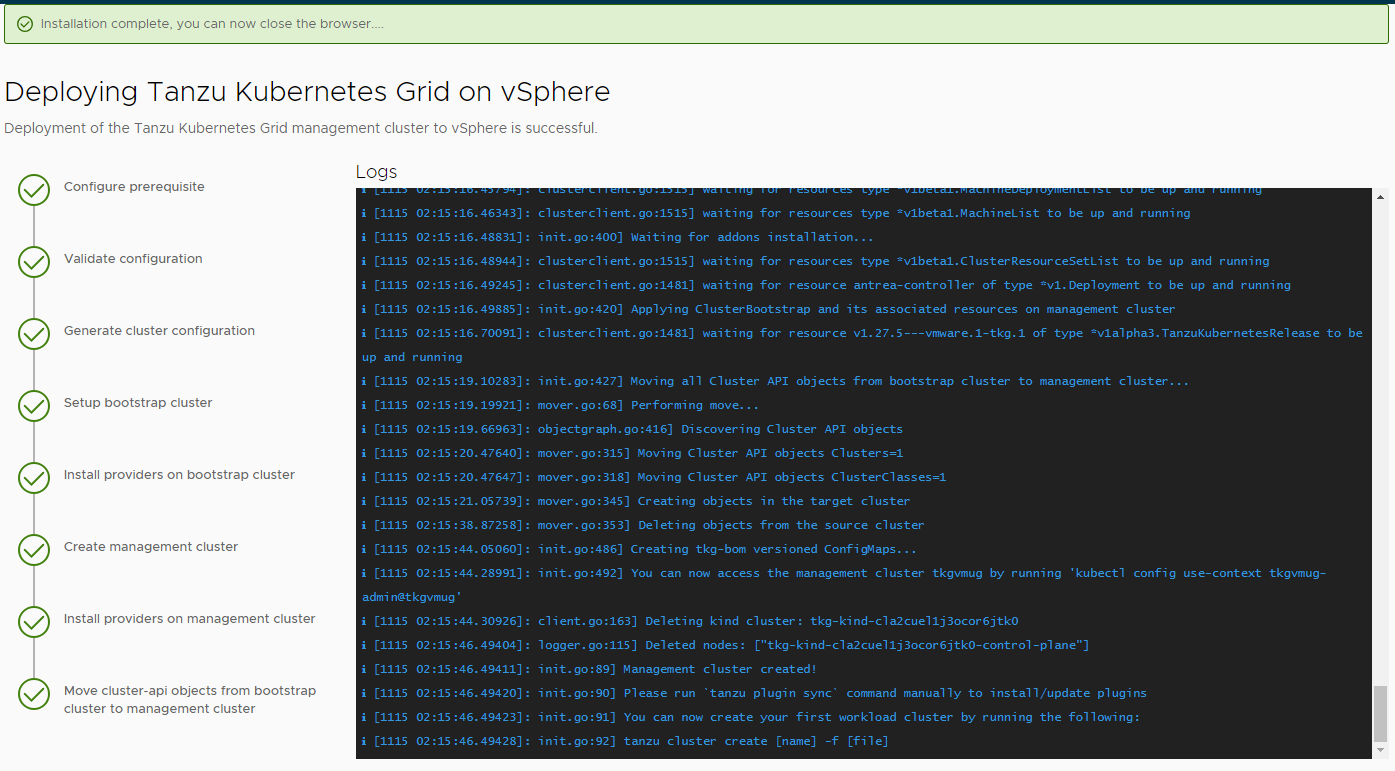

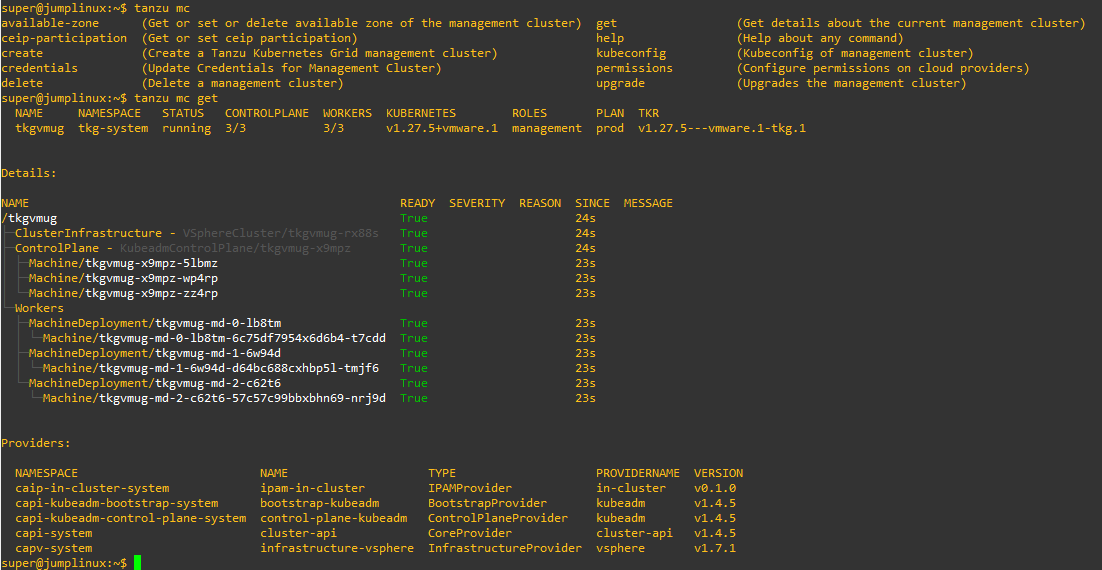

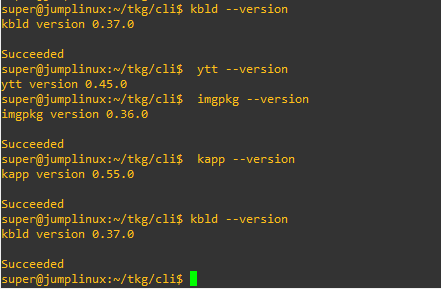

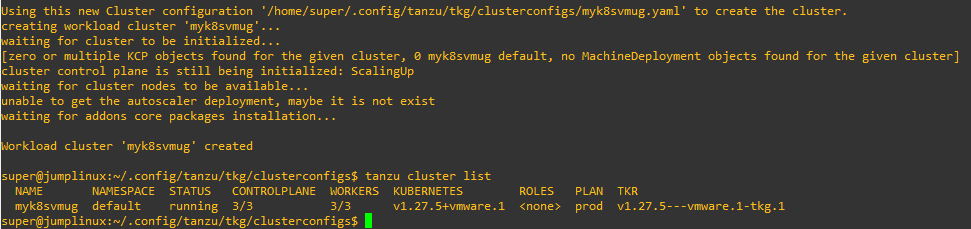

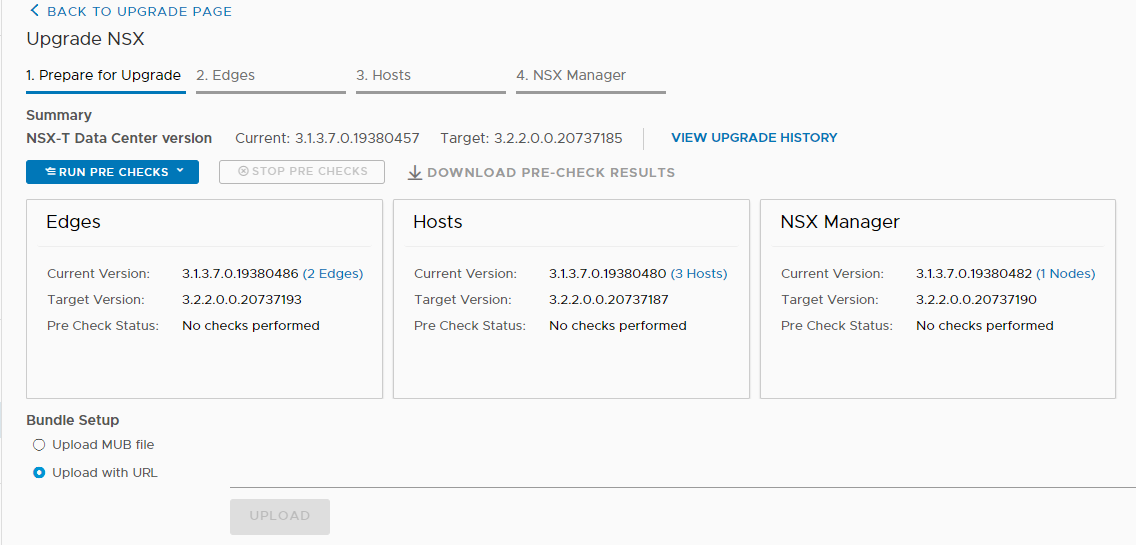

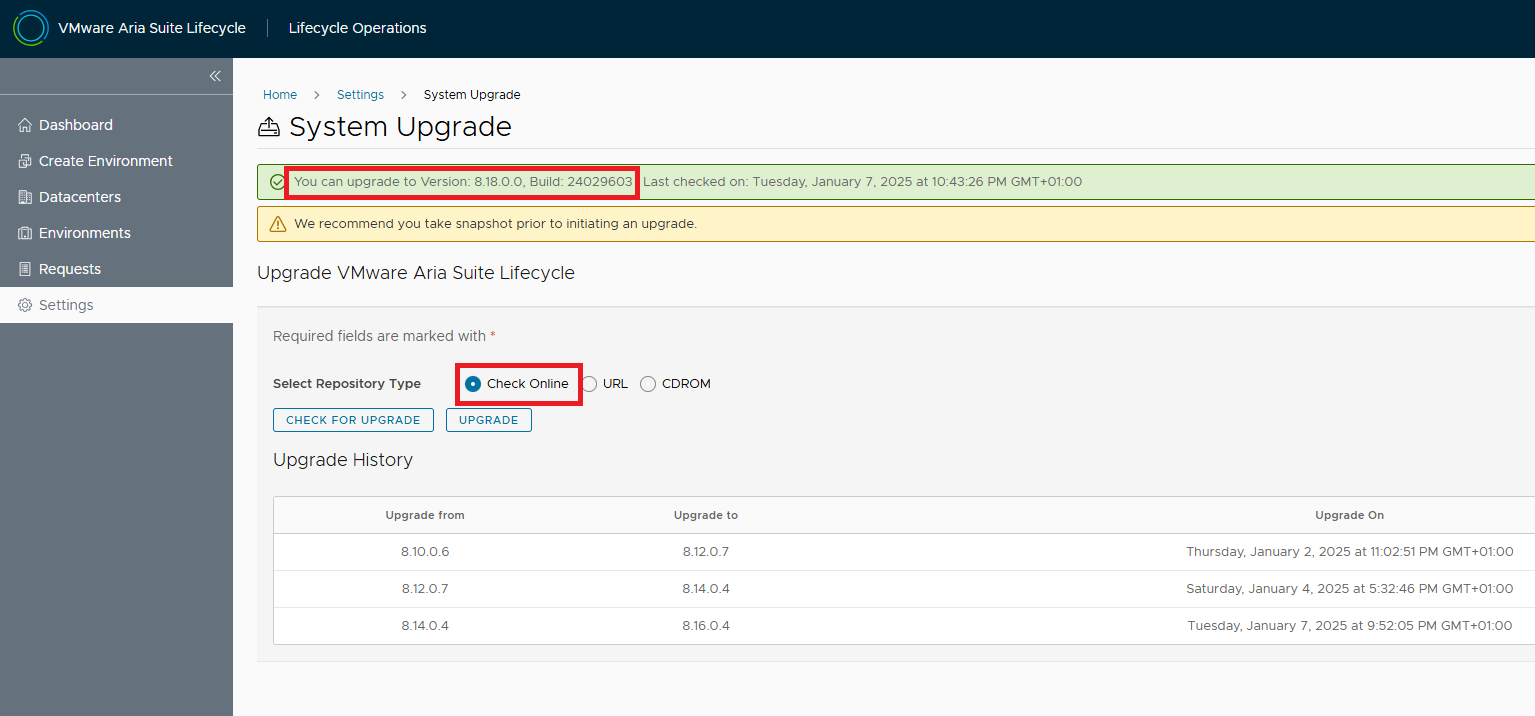

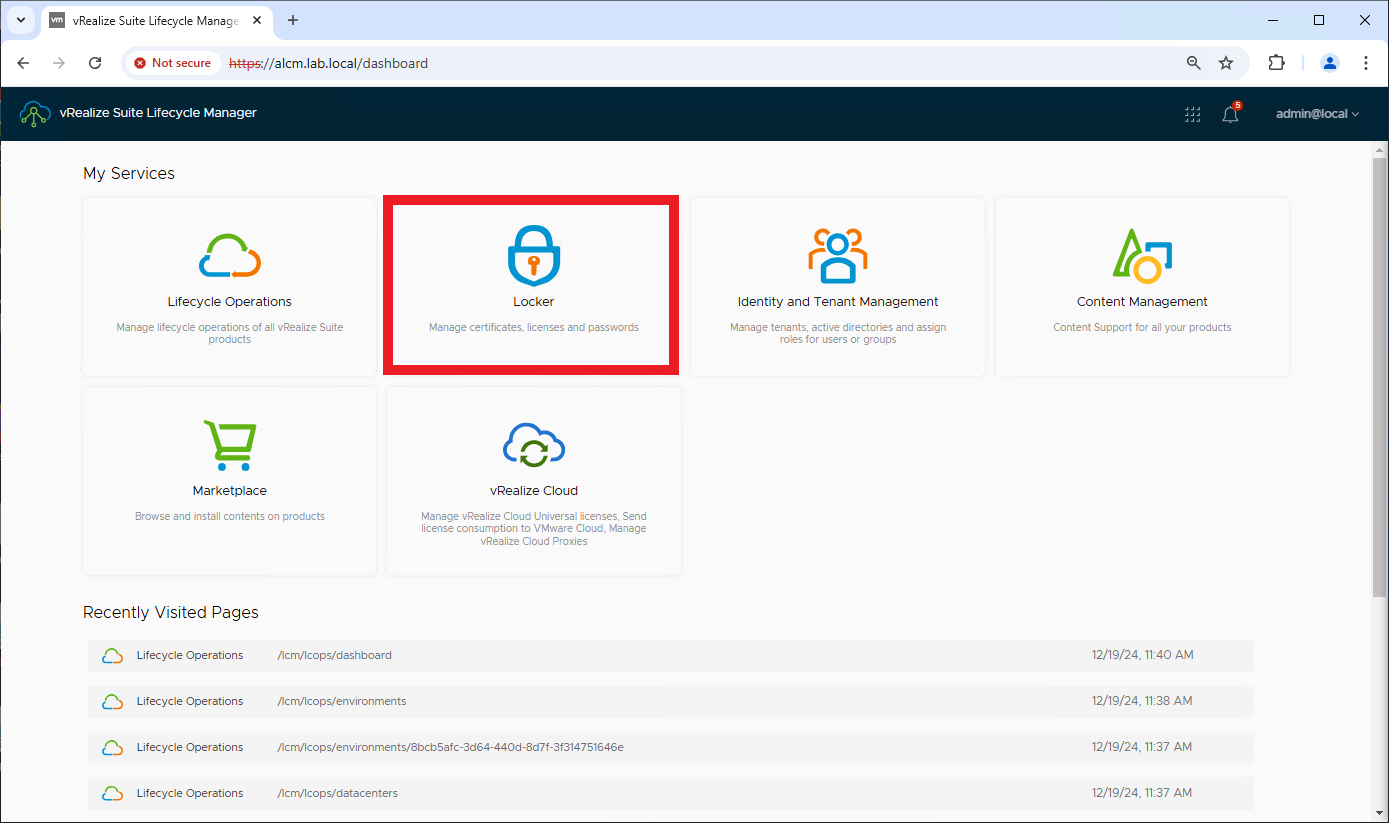

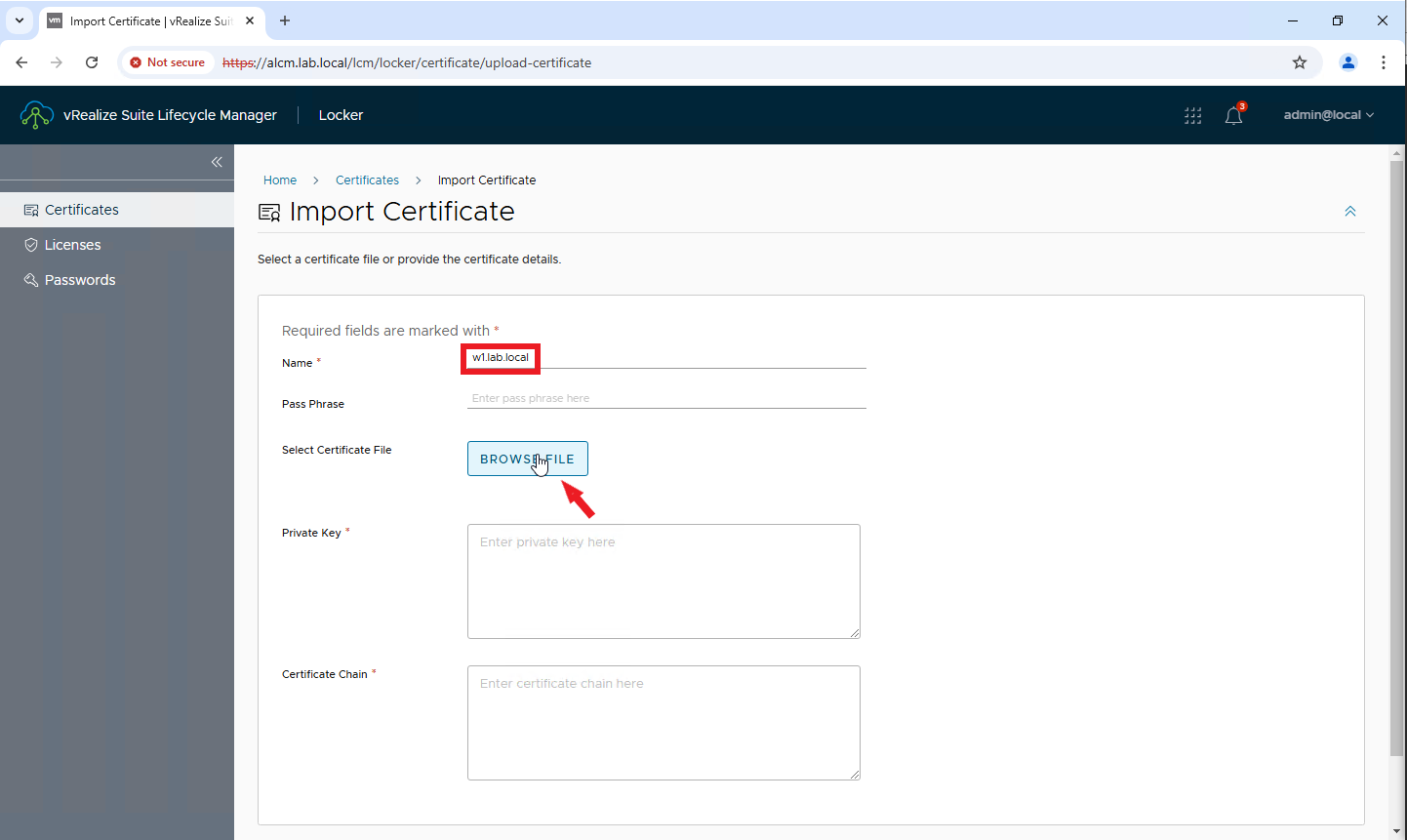

una volta definito l’upgrade path si può iniziare l’aggiornamento. Partiamo dal Lifecycle manager (LCM). La procedura è la stessa per tutte le release.

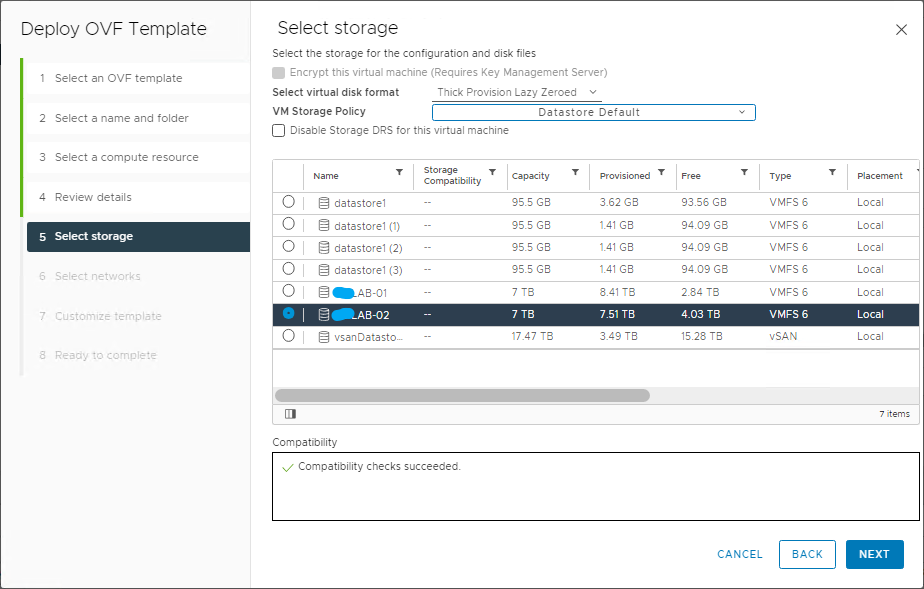

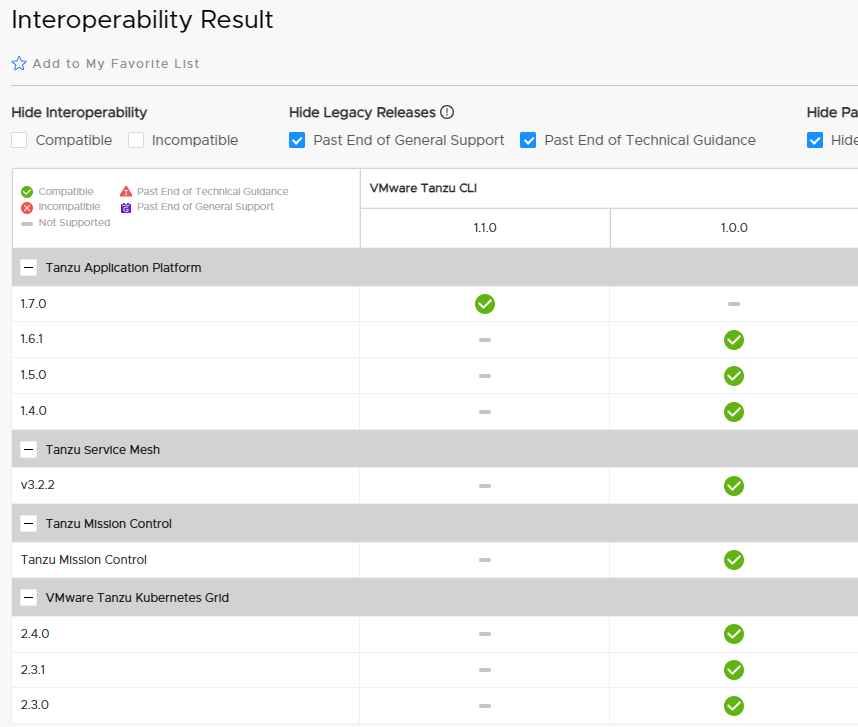

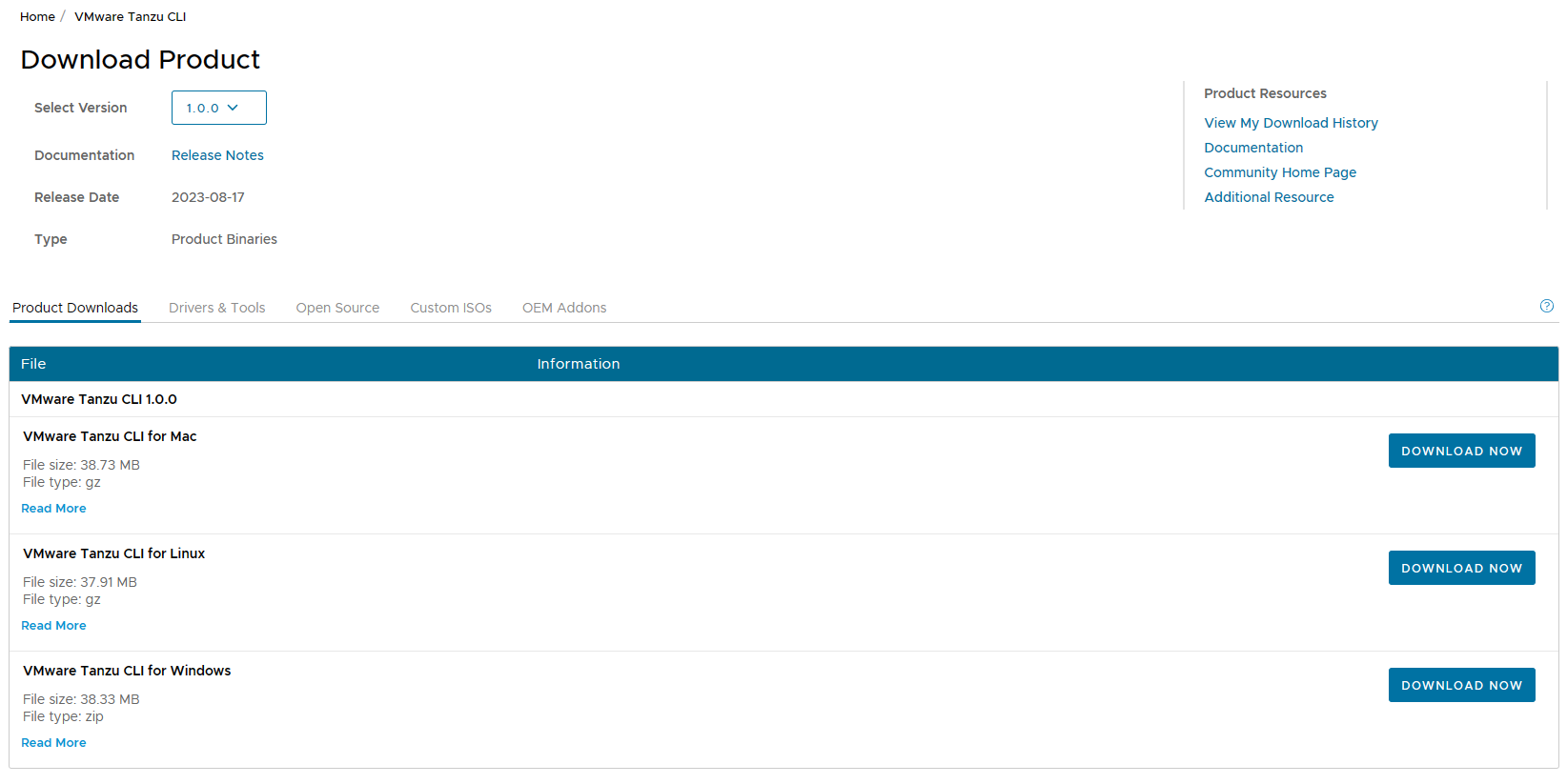

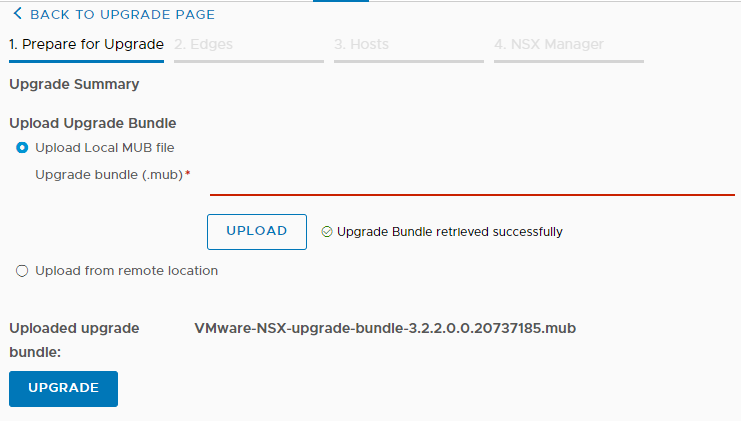

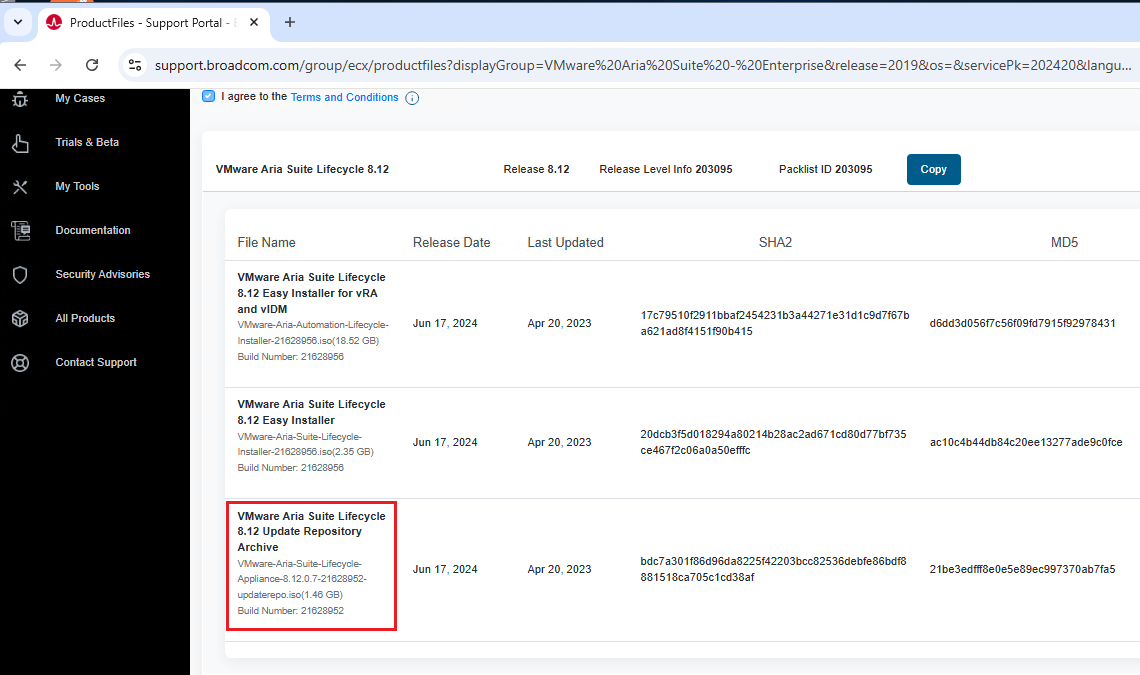

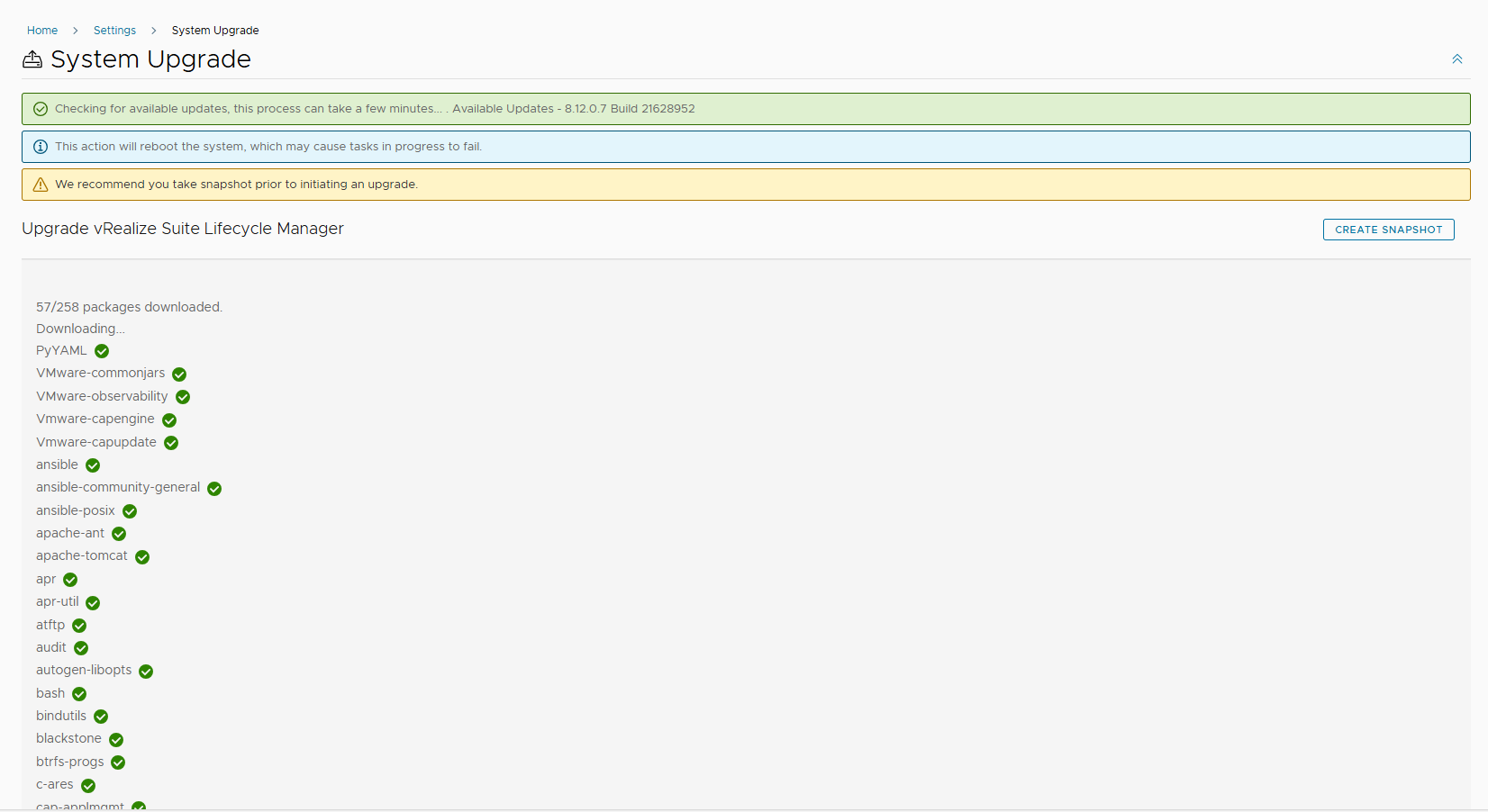

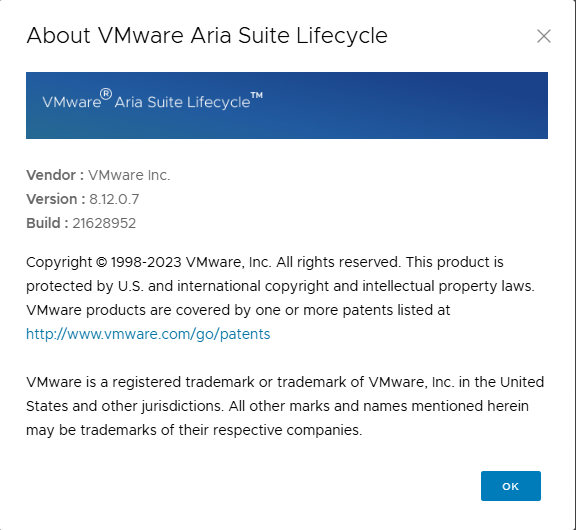

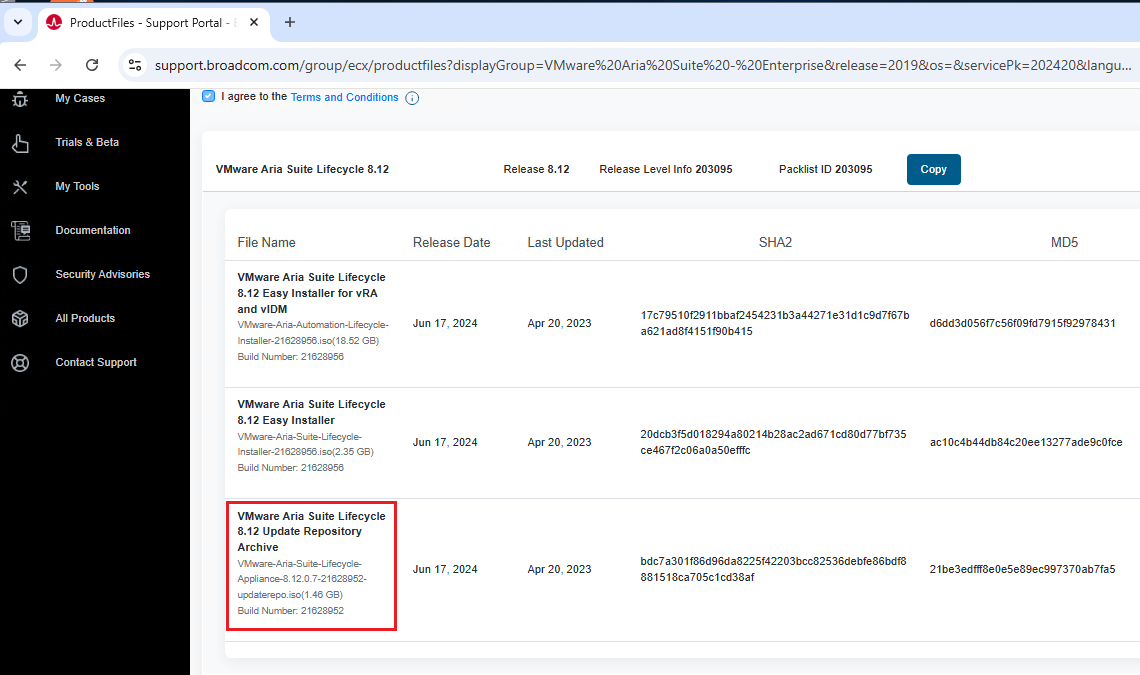

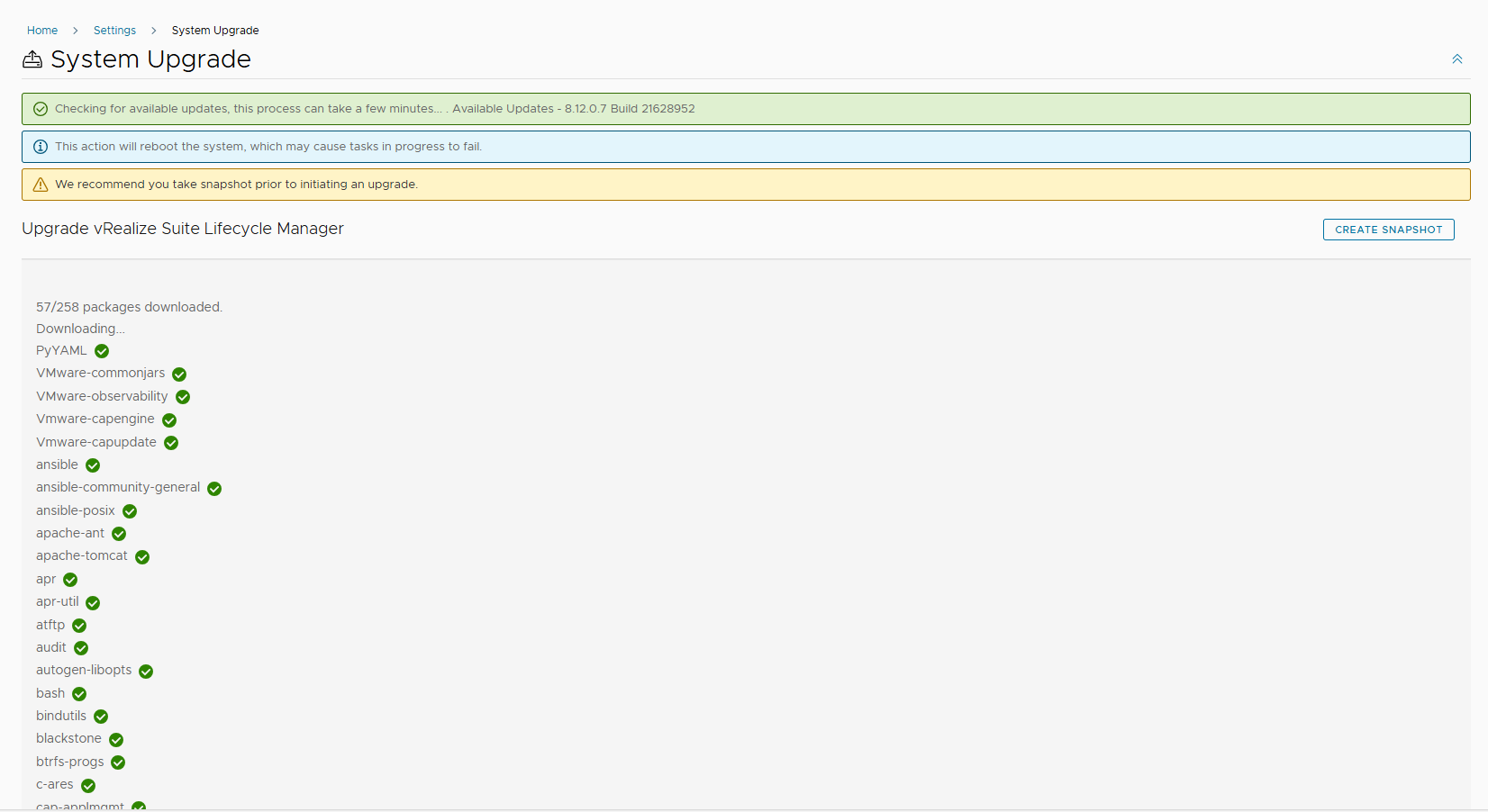

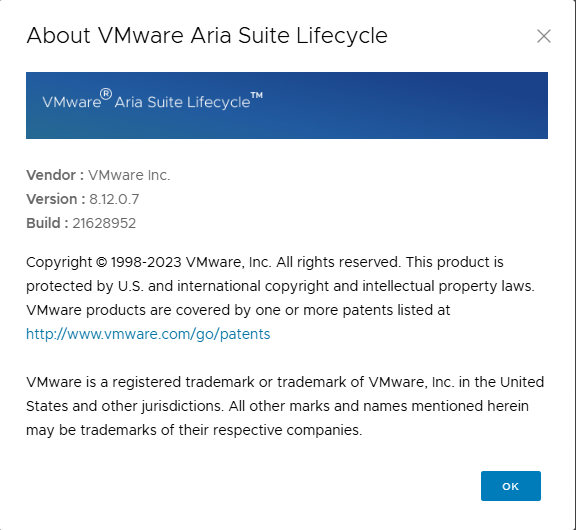

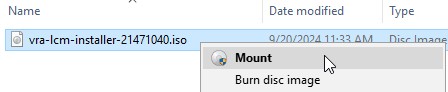

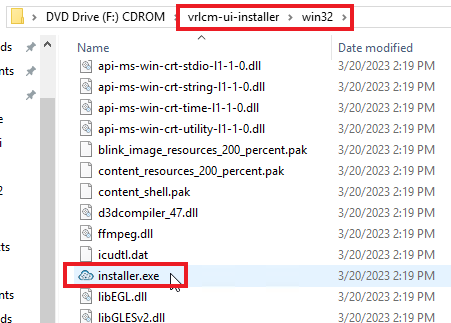

Per prima cosa dobbiamo scaricare la ISO per l’upgrade dal sito broadcom, il nome del file è VMware-Aria-Suite-Lifecycle-Appliance-8.12.0.7-21628952-updaterepo.iso

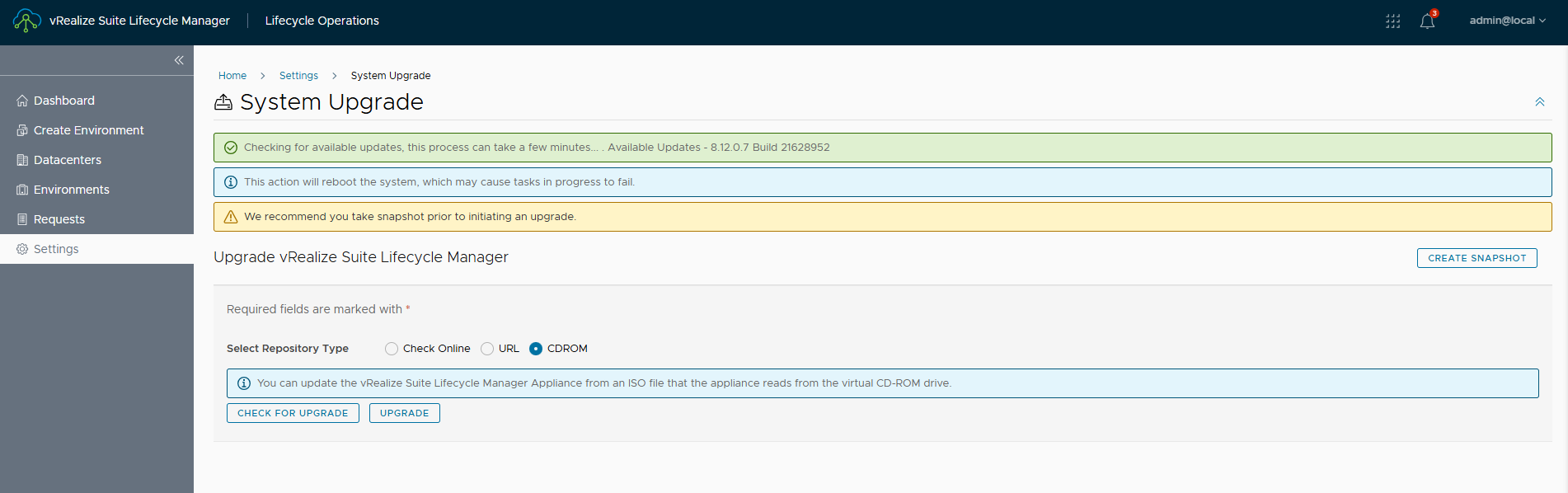

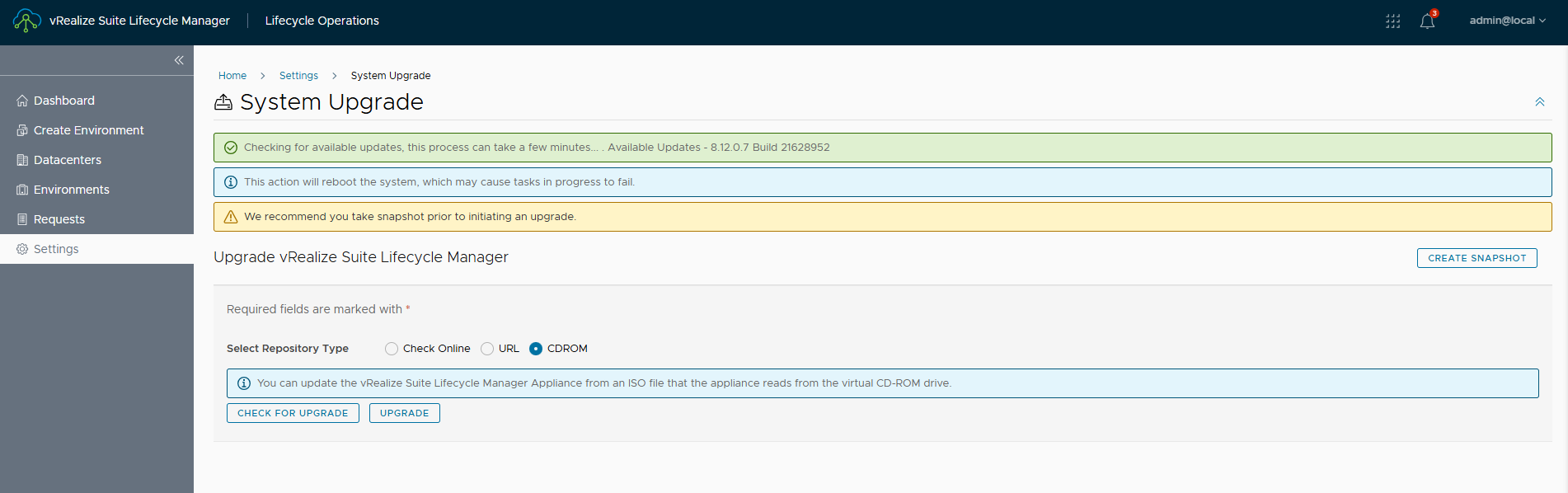

La ISO va caricata su un datastore del cluster dove risiede LCM e collegata all’appliance. Successivamente, da LCM, andare su Settings e System Upgrade. Selezionare come repository CDROM e poi CHECK FOR UPGRADE.

Se la ISO è stata collegata correttamente verrà rilevata la release per l’upgrade.

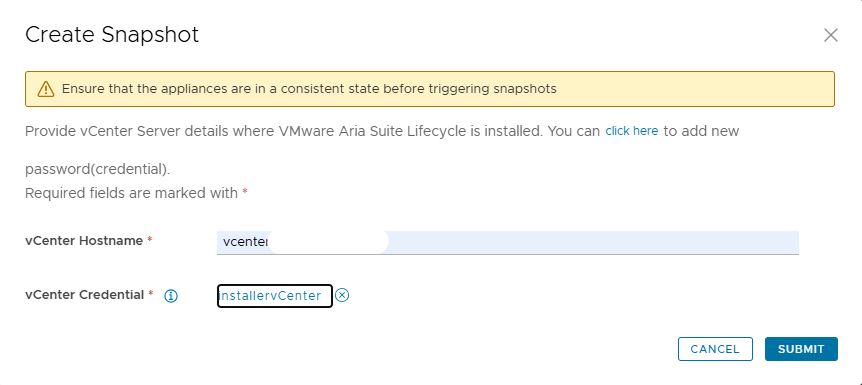

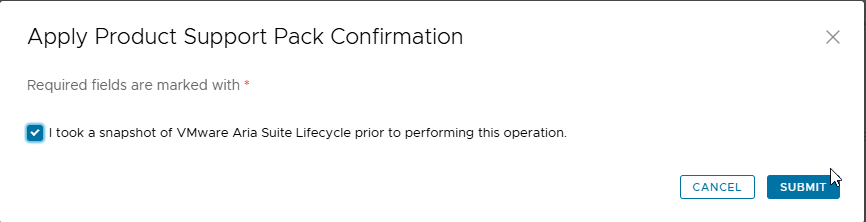

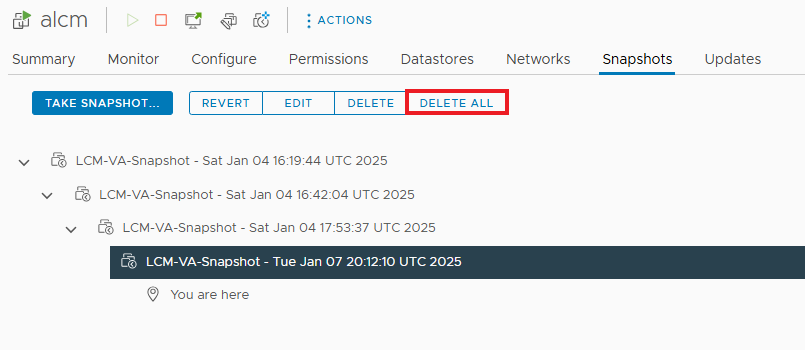

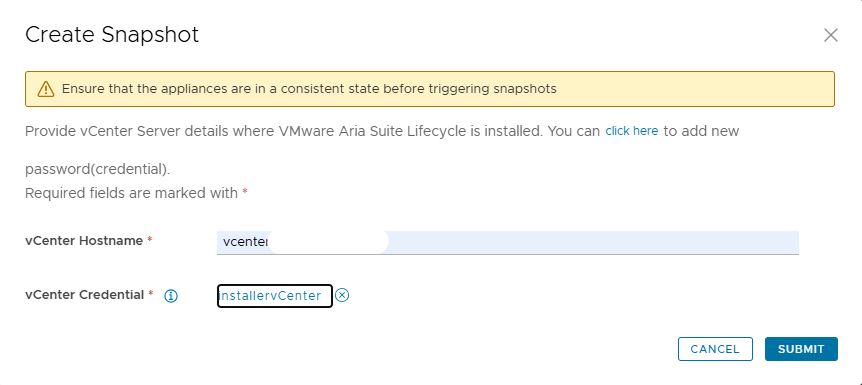

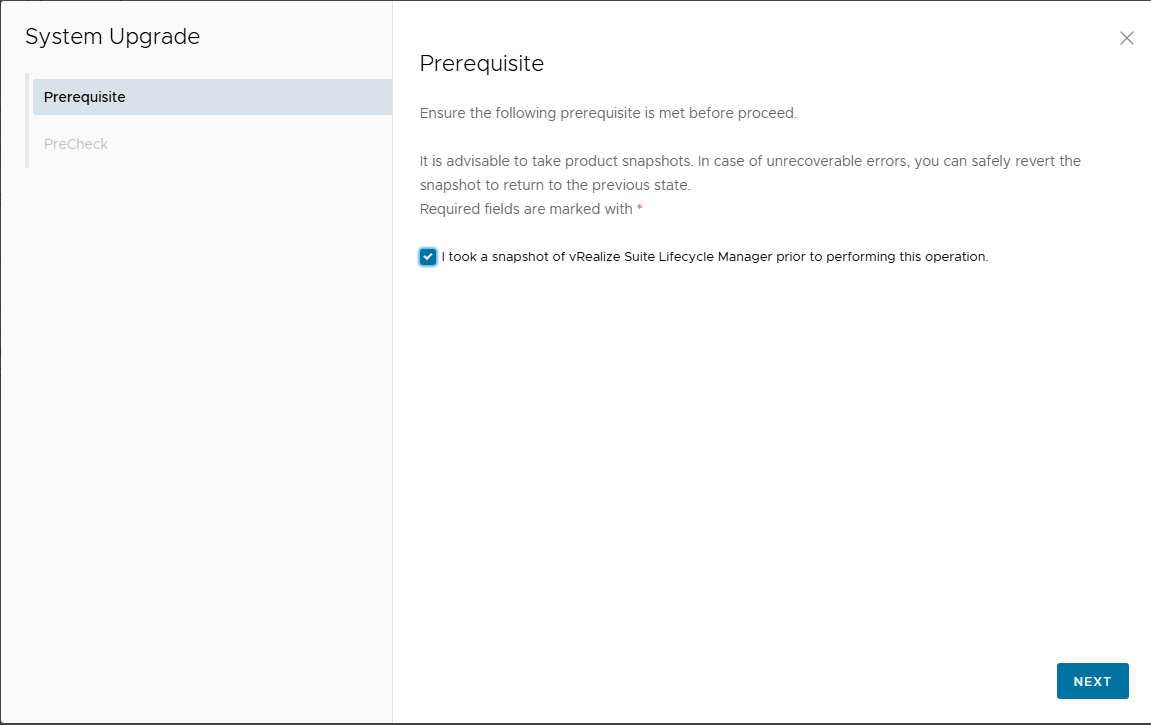

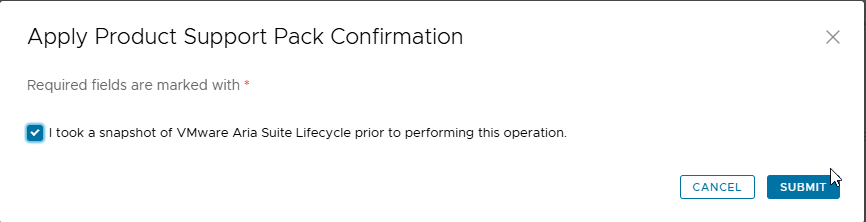

NOTA: prima di avviare l’upgrade è necessario prendere uno snapshot di LCM, se qualcosa va storto possiamo sempre tornare indietro.

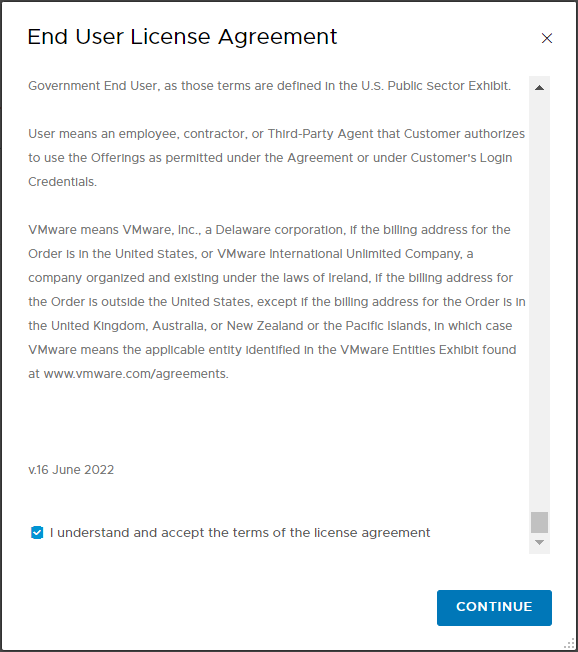

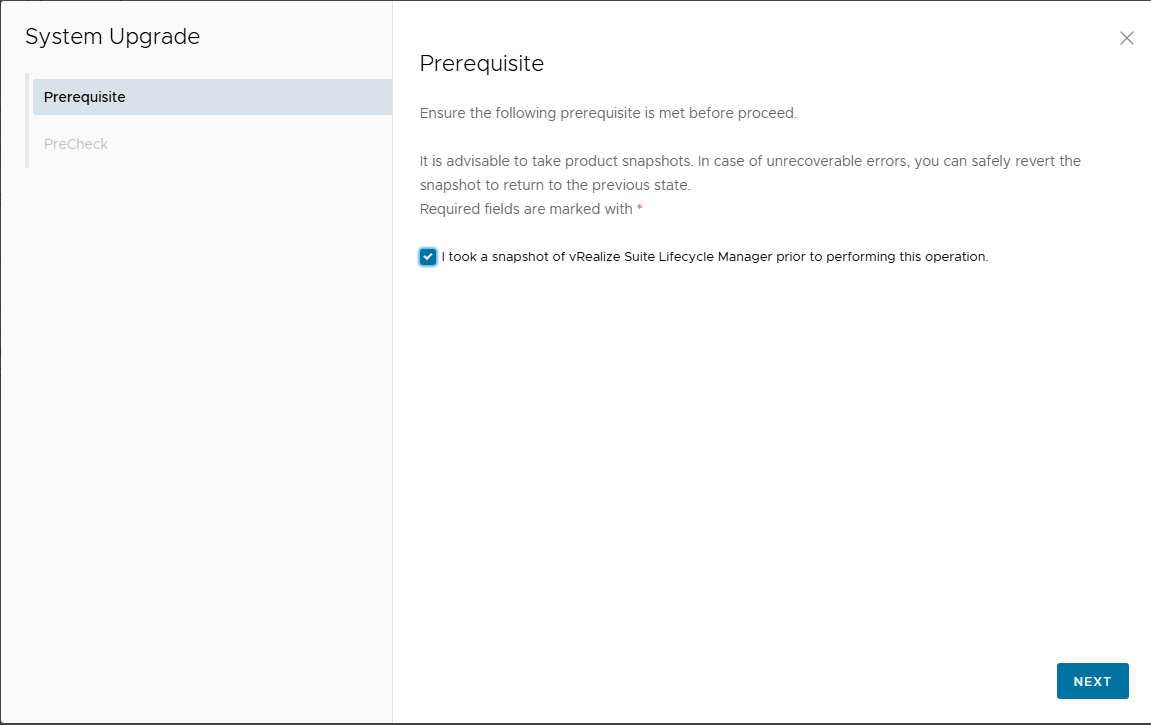

Proseguiamo con l’upgrade, per proseguire abilitare il flag relativo allo snapshot.

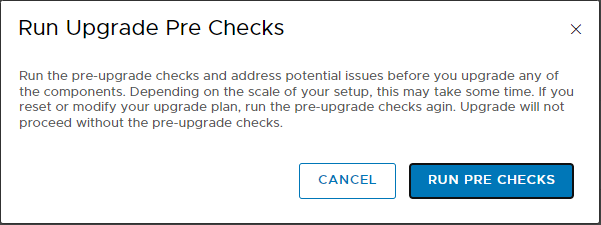

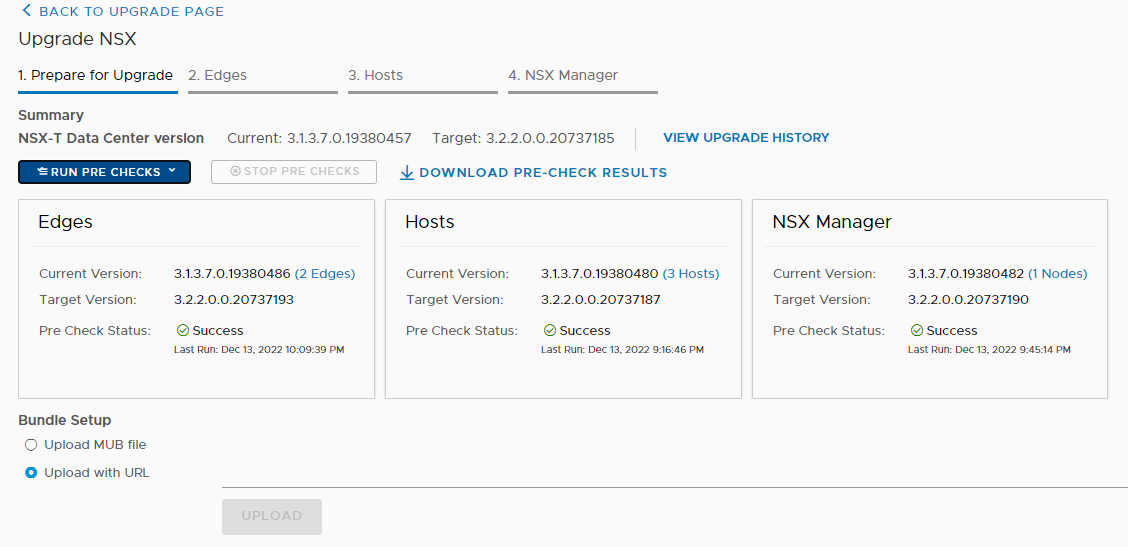

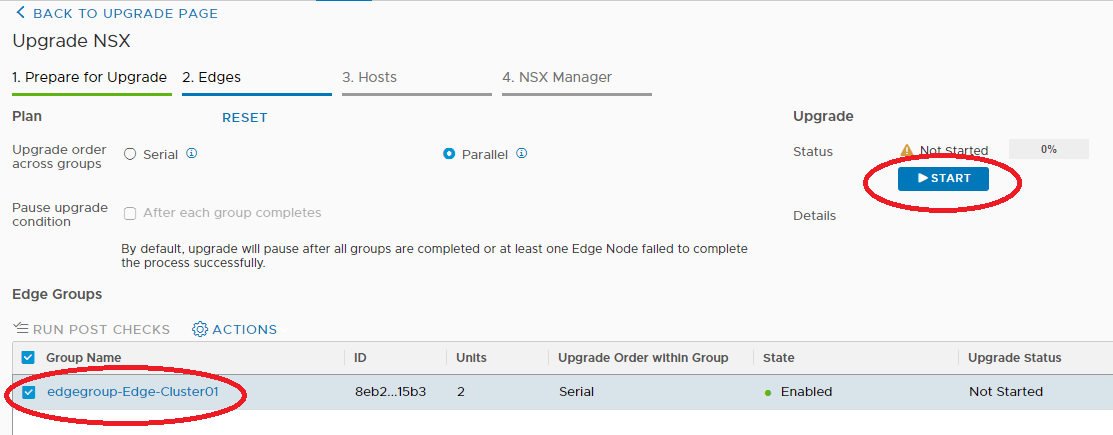

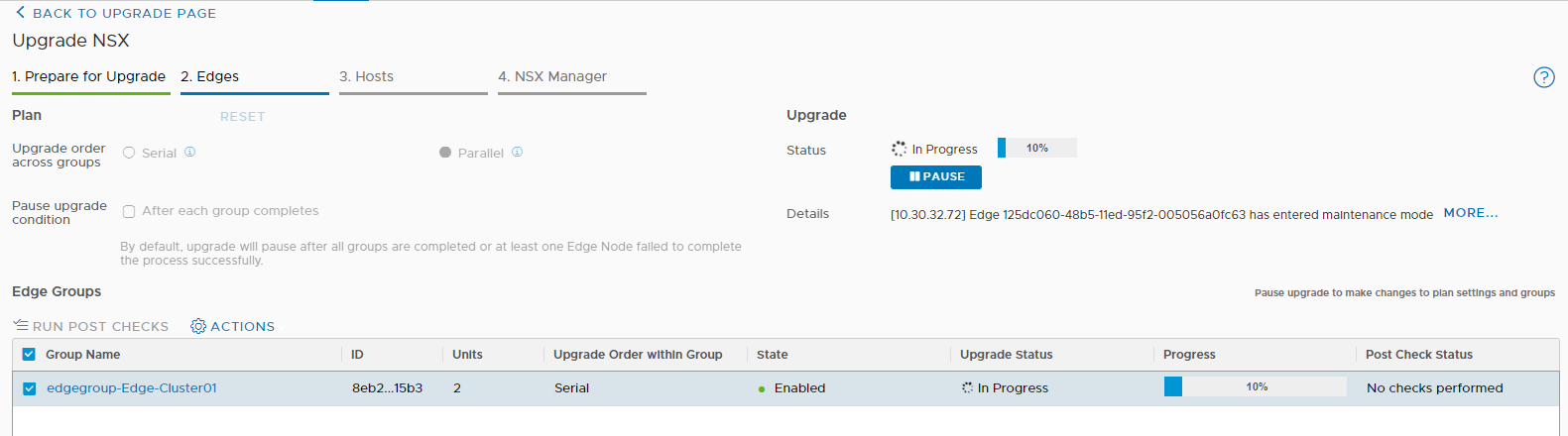

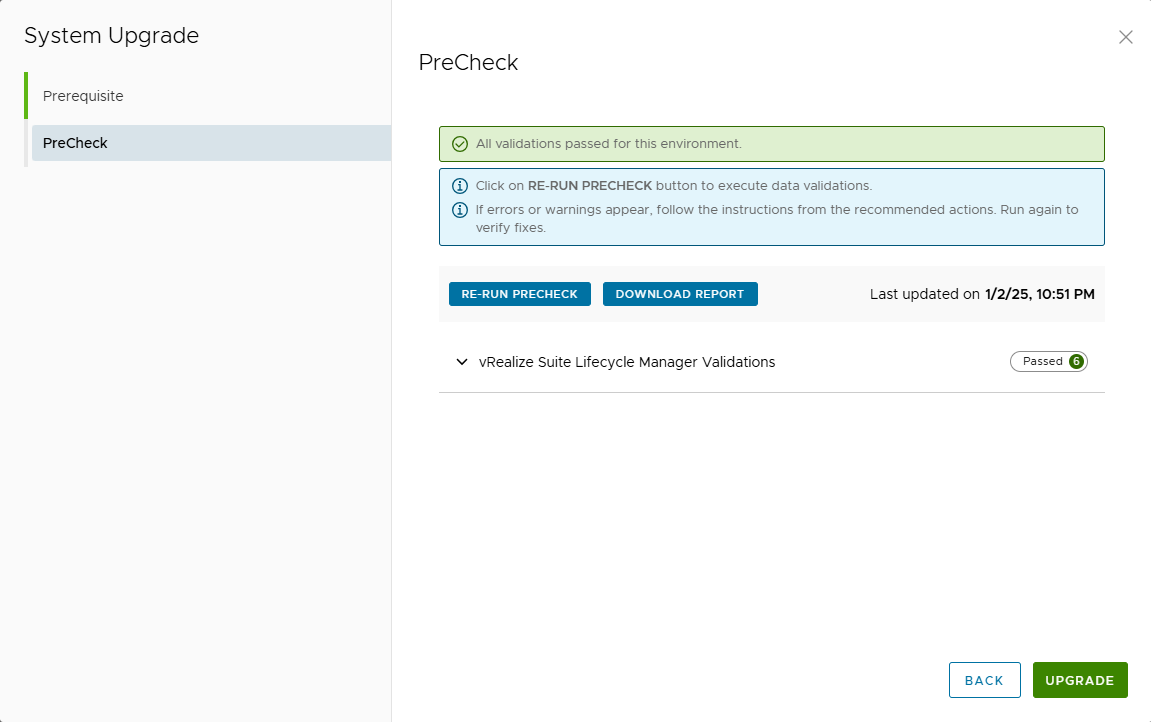

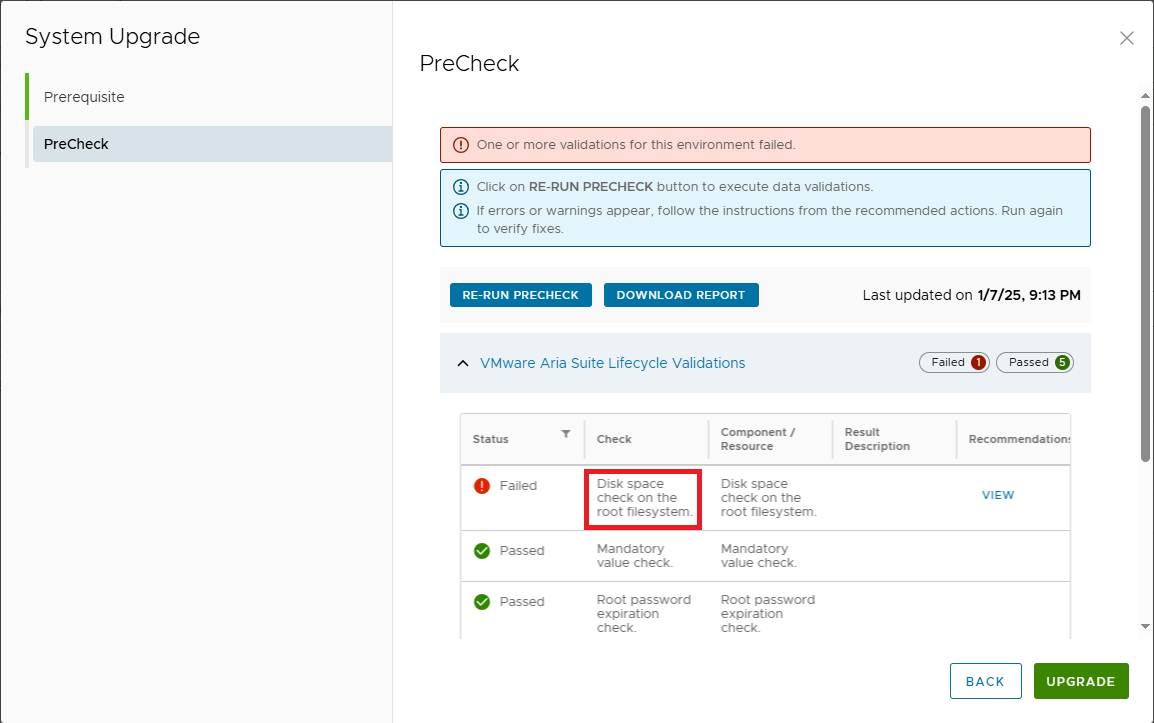

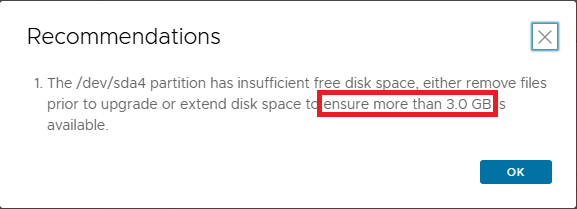

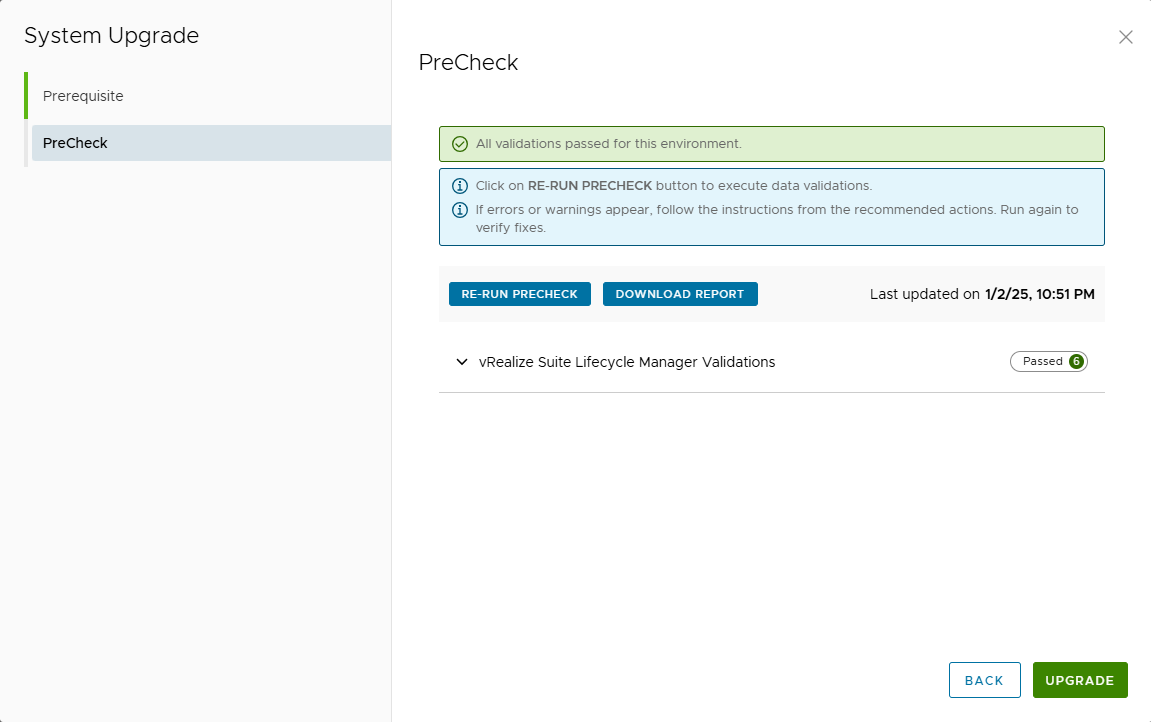

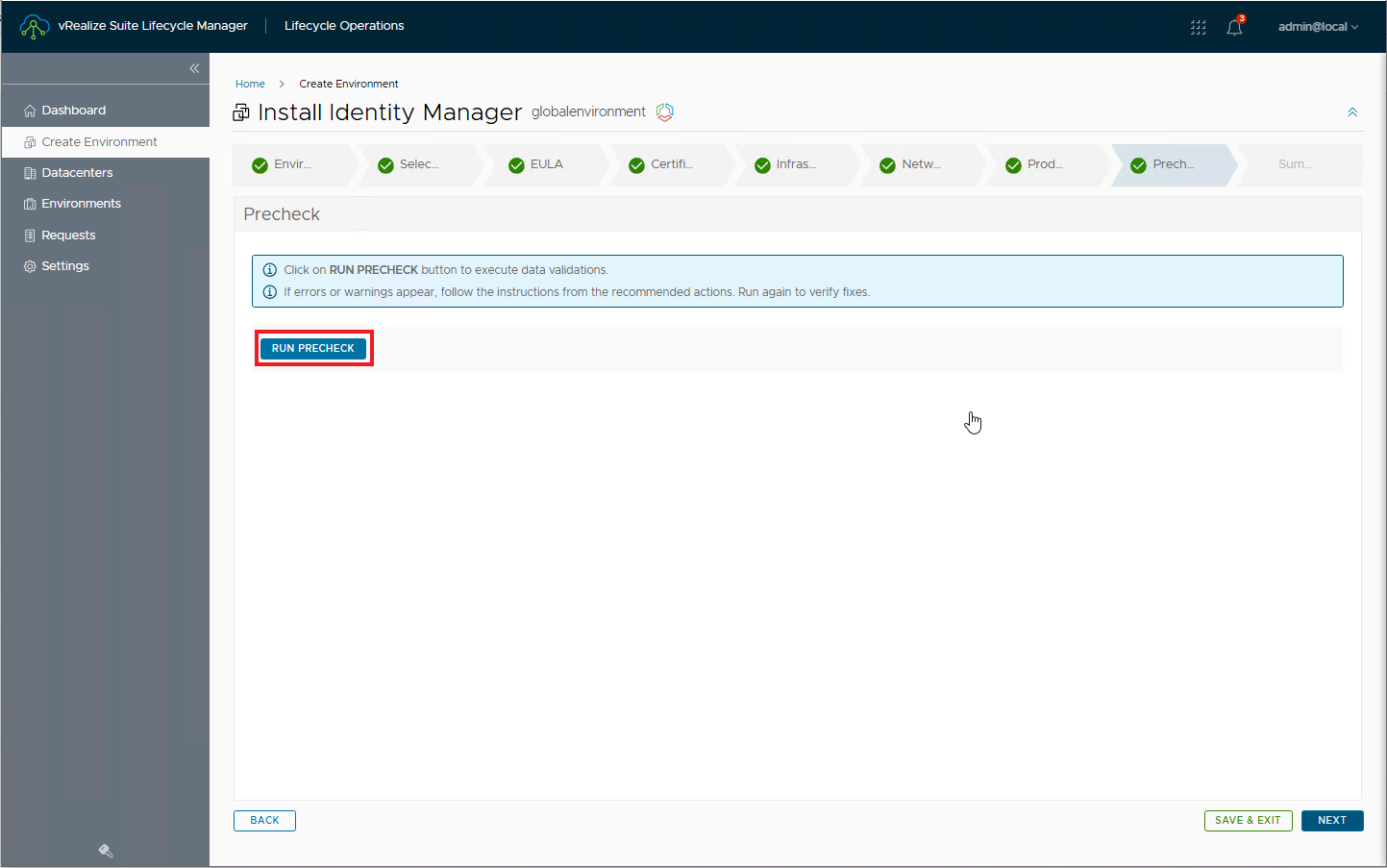

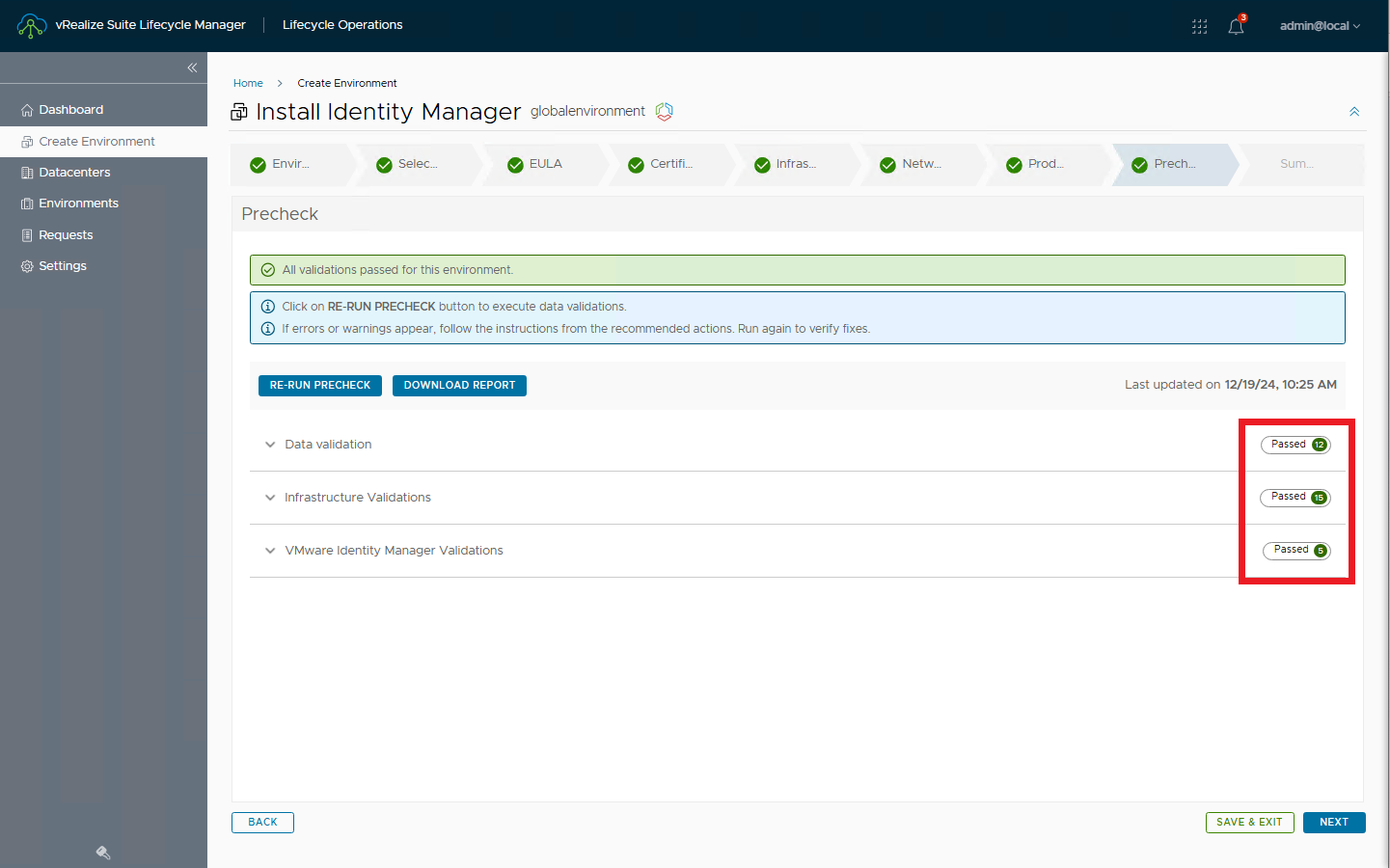

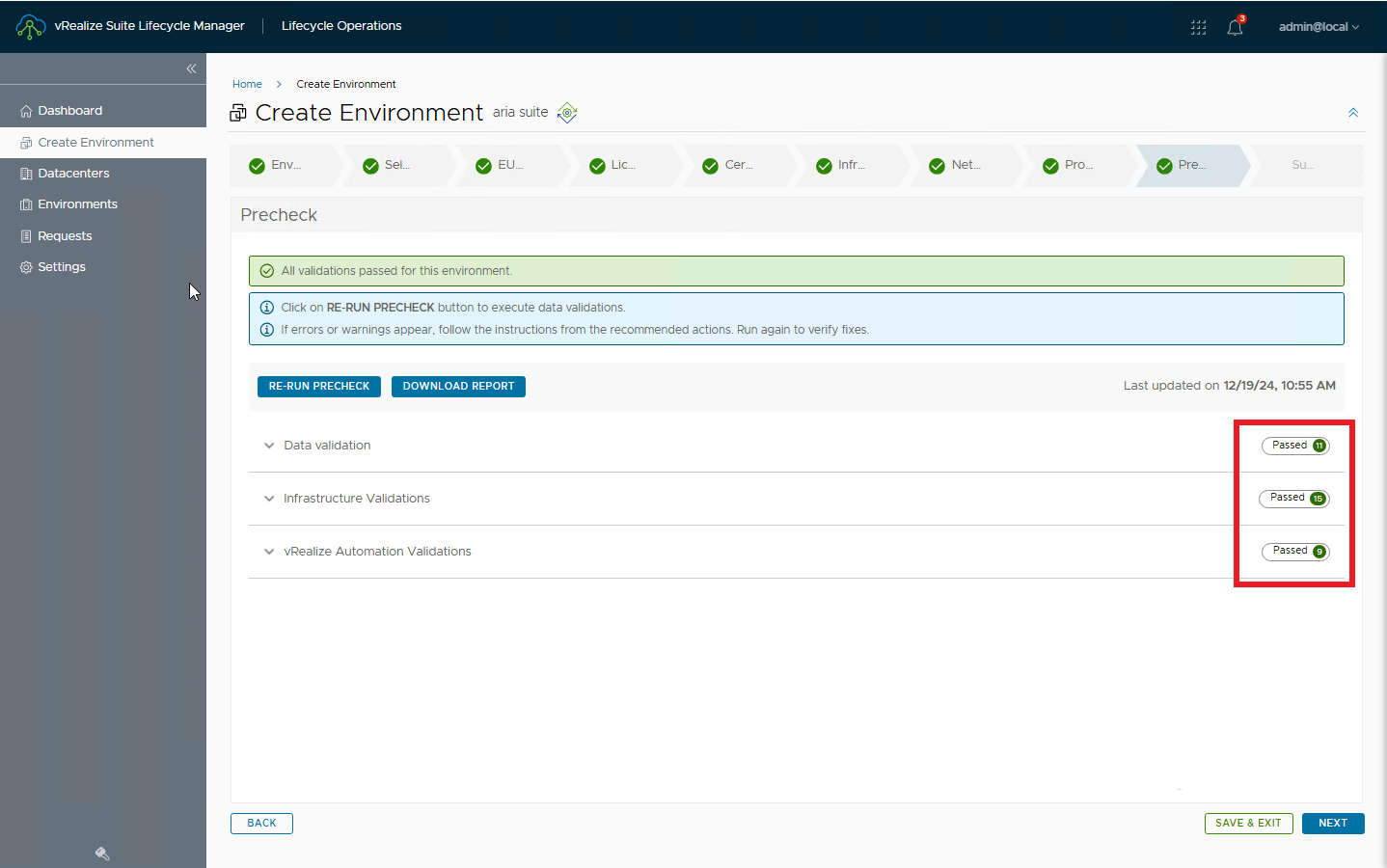

Eseguiamo i precheck e verifichiamo che tutto sia a posto

Confermiamo con UPGRADE

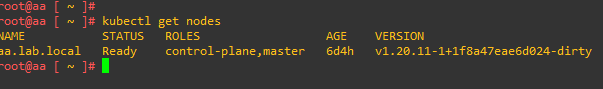

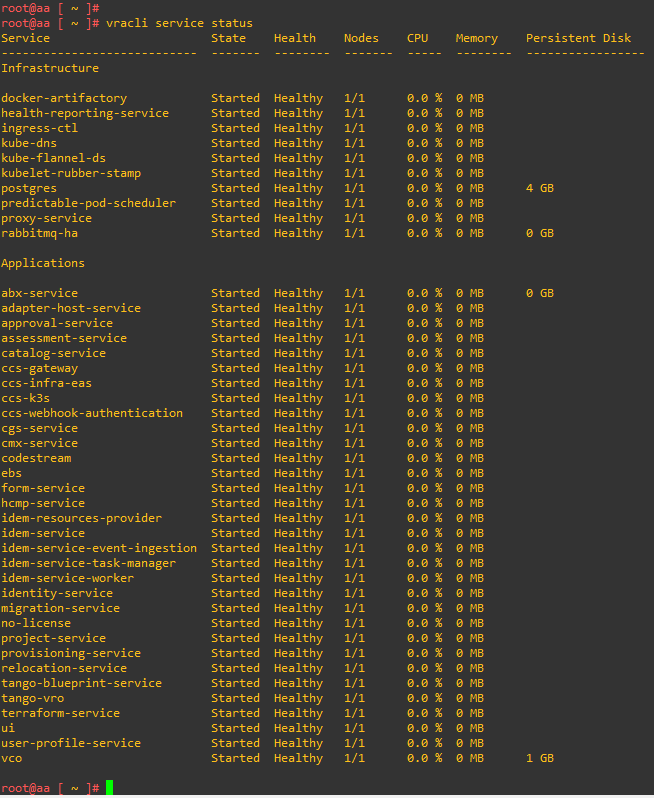

LCM eseguirà l’aggiornamento e si riavvierà, attendere che i servizi tornino attivi.

Al completamento sarà possibile verificare la nuova release

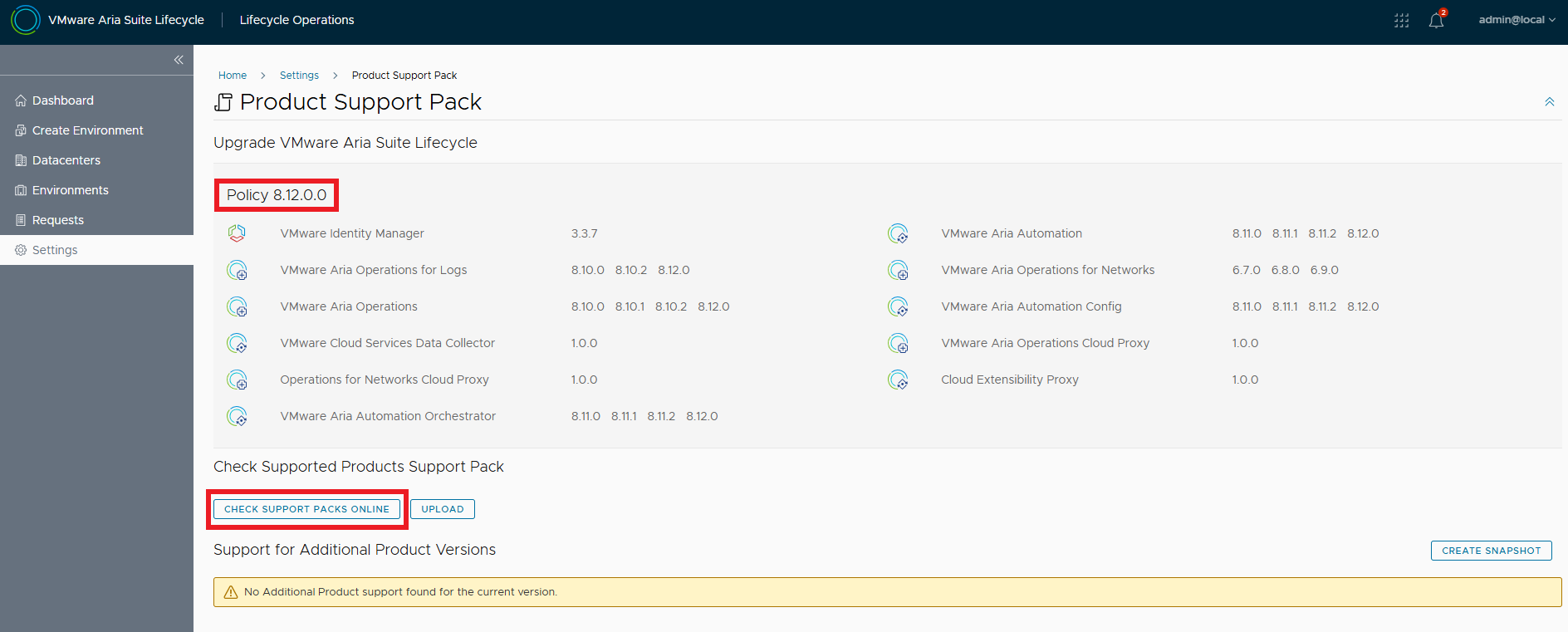

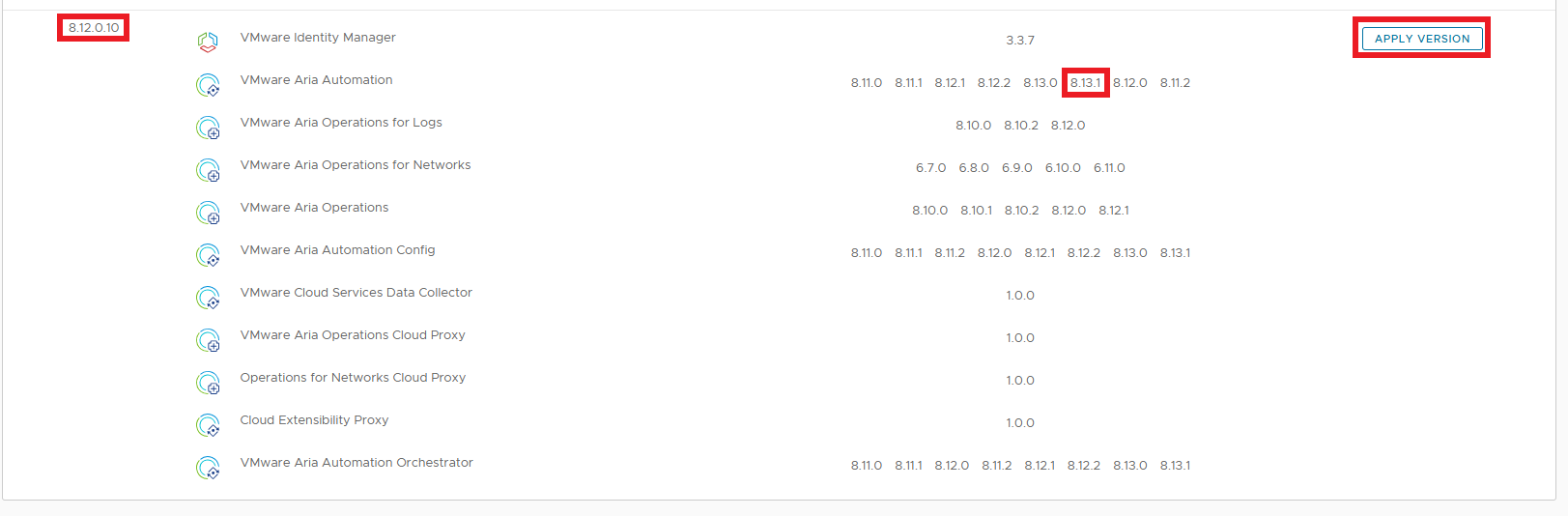

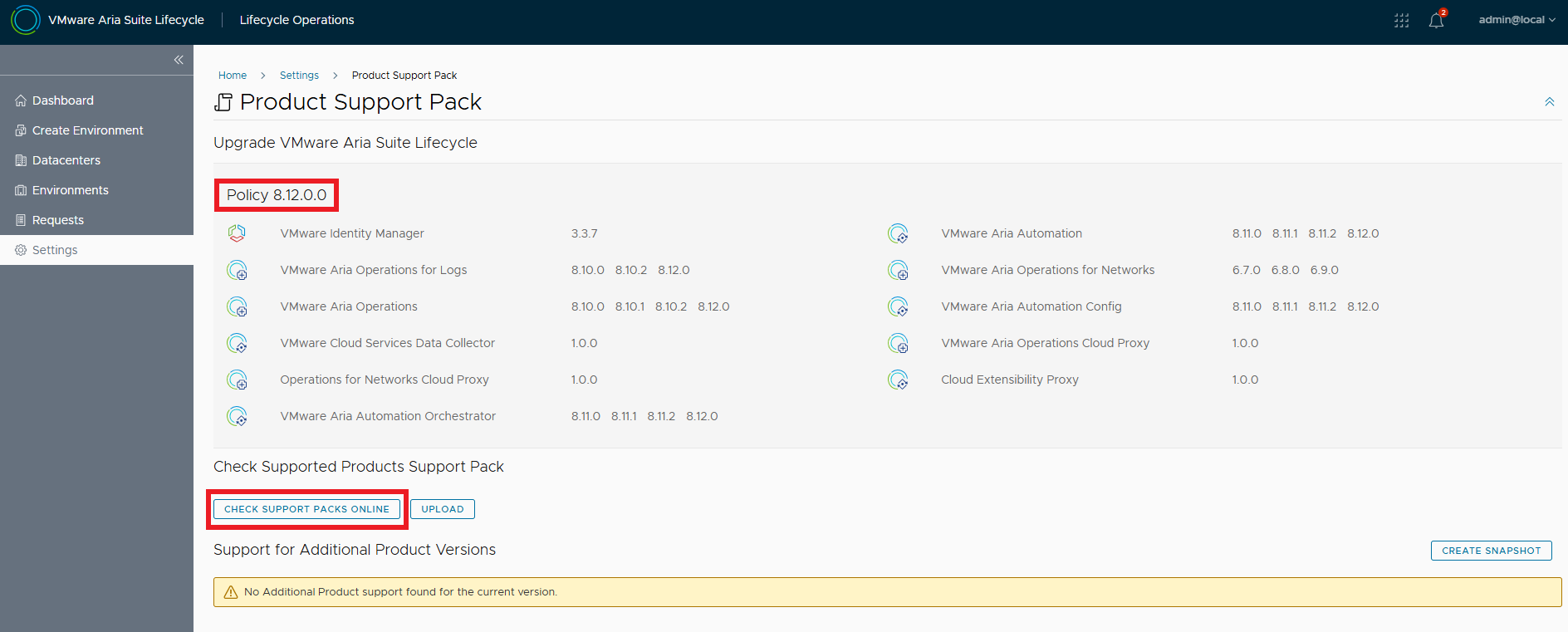

Completato l’upgrade installiamo l’ultimo Product Support Pack, andiamo su Settings e poi su Product Support Pack. Il Pack attivo è quello disponibile con l’upgrade, verificare che ce ne siano di più recenti.

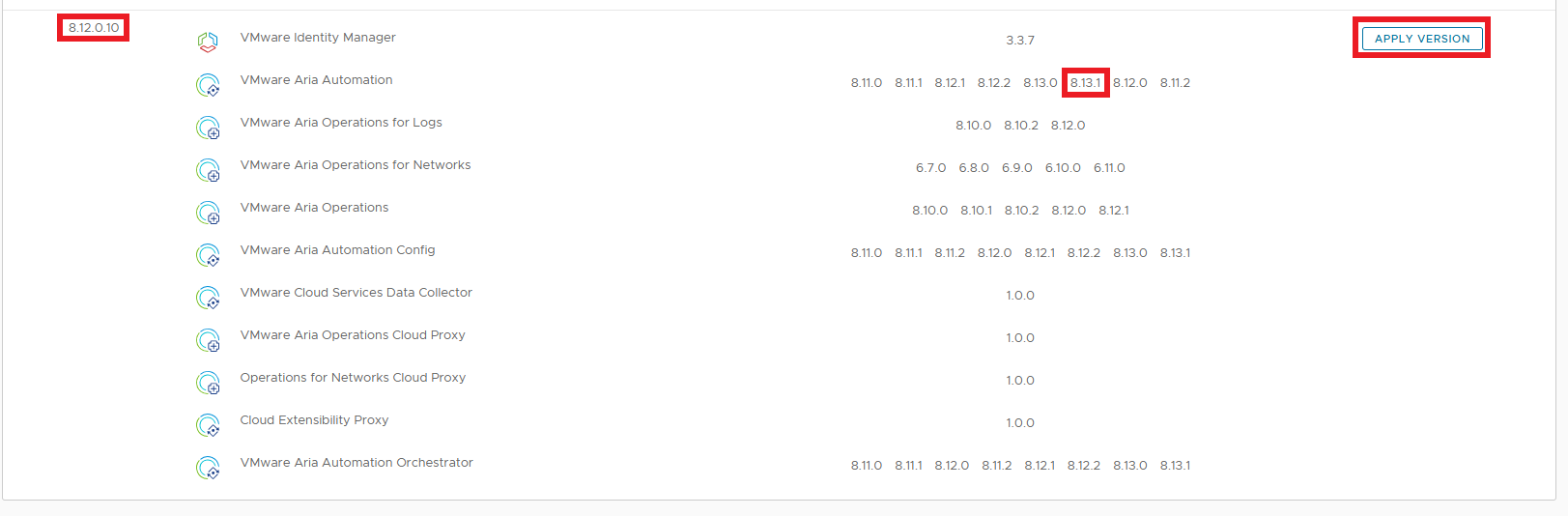

Selezionare il più recente e dare APPLY VERSION

Vediamo che l’ulitmo Support Pack supporta proprio la versione di Aria Automation che ci server per lo step di upgrade 2

LCM si deve riavviare per rendere effettive le nuove configurazioni.

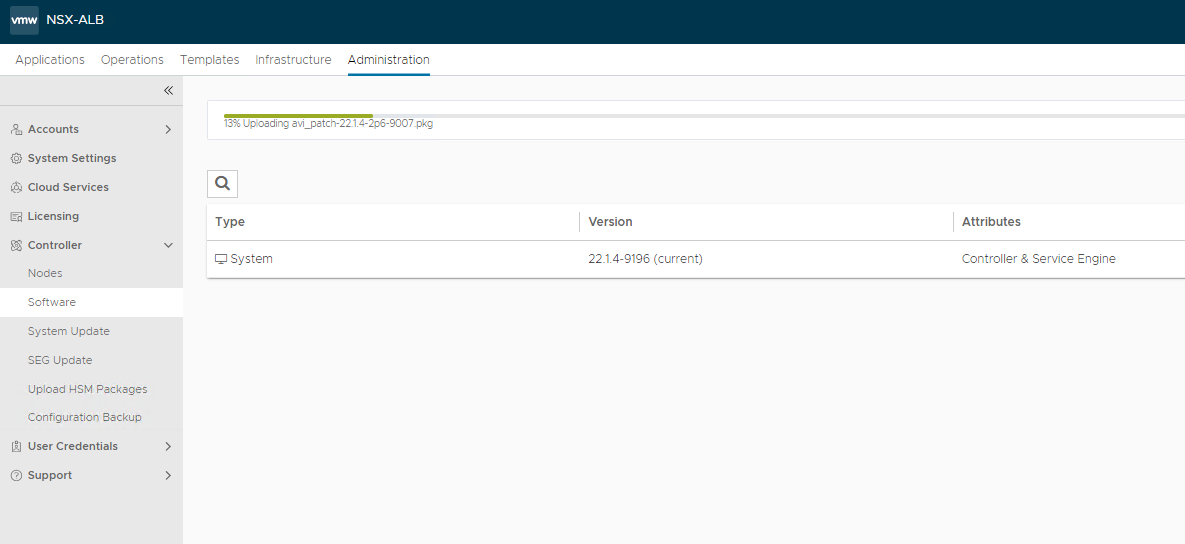

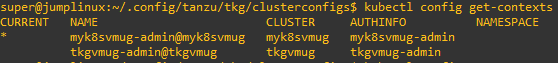

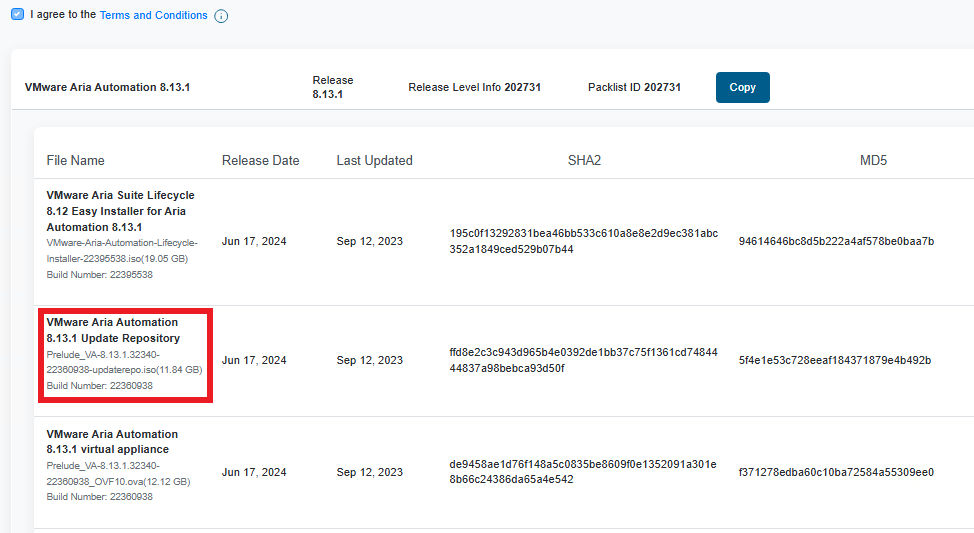

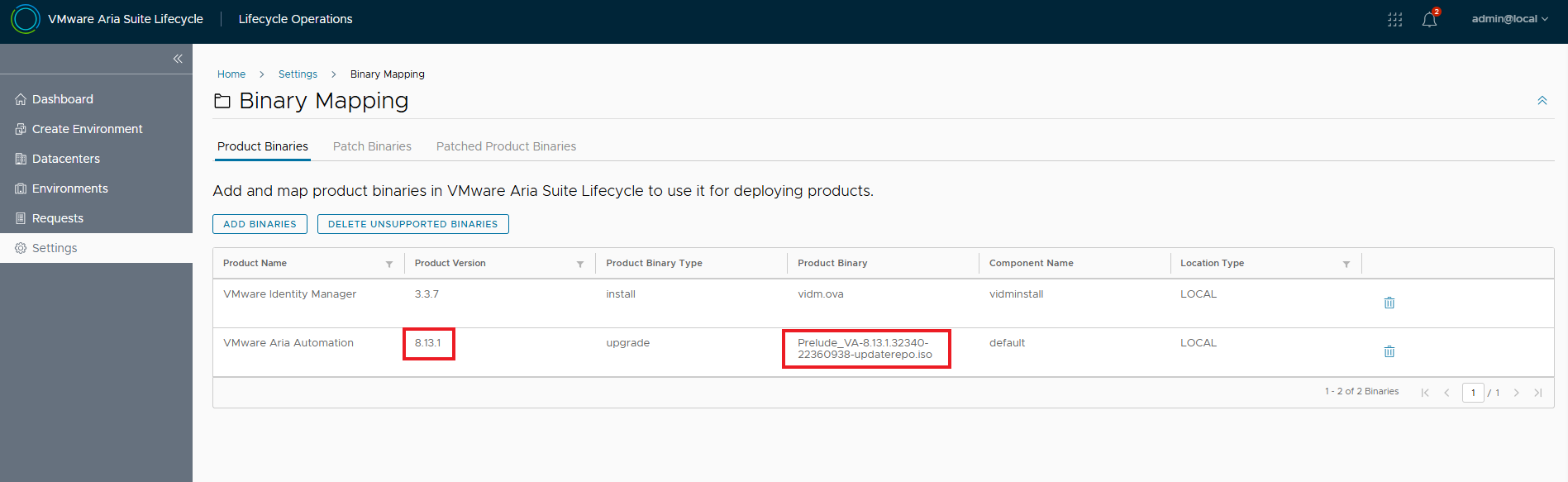

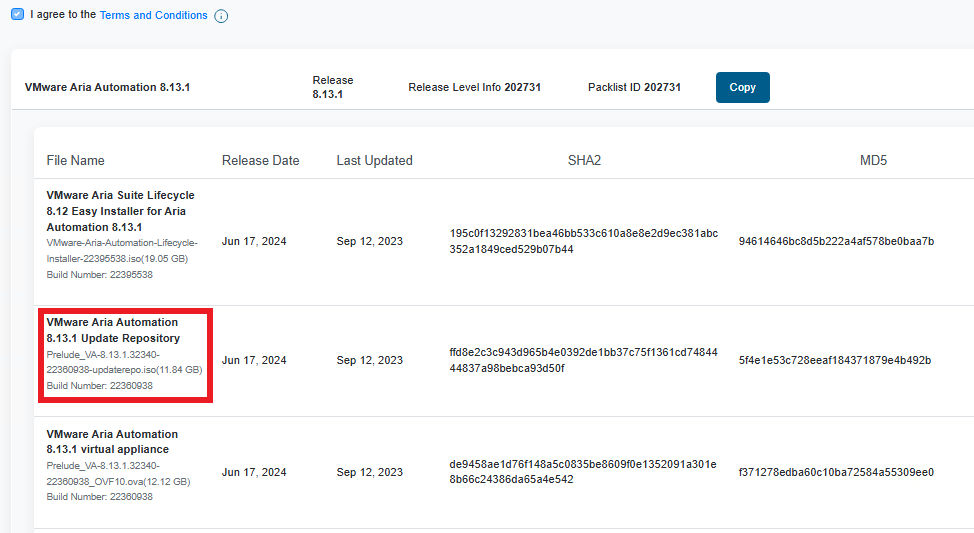

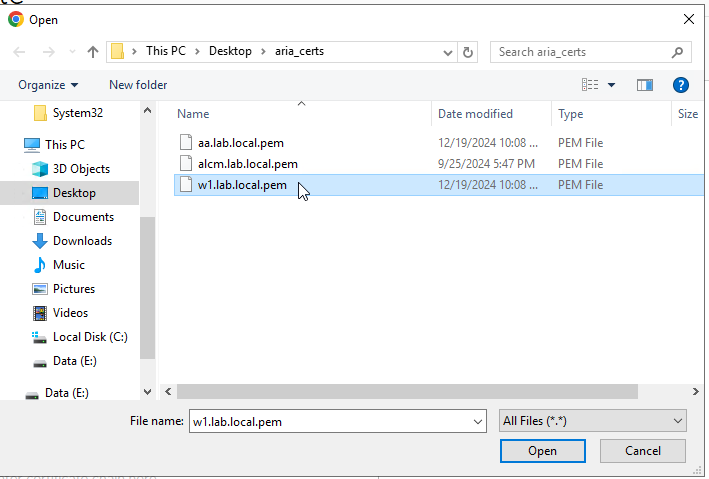

Passiamo al secondo step, scarichiamo la ISO per l’upgrade di Automation alla release 8.13.1

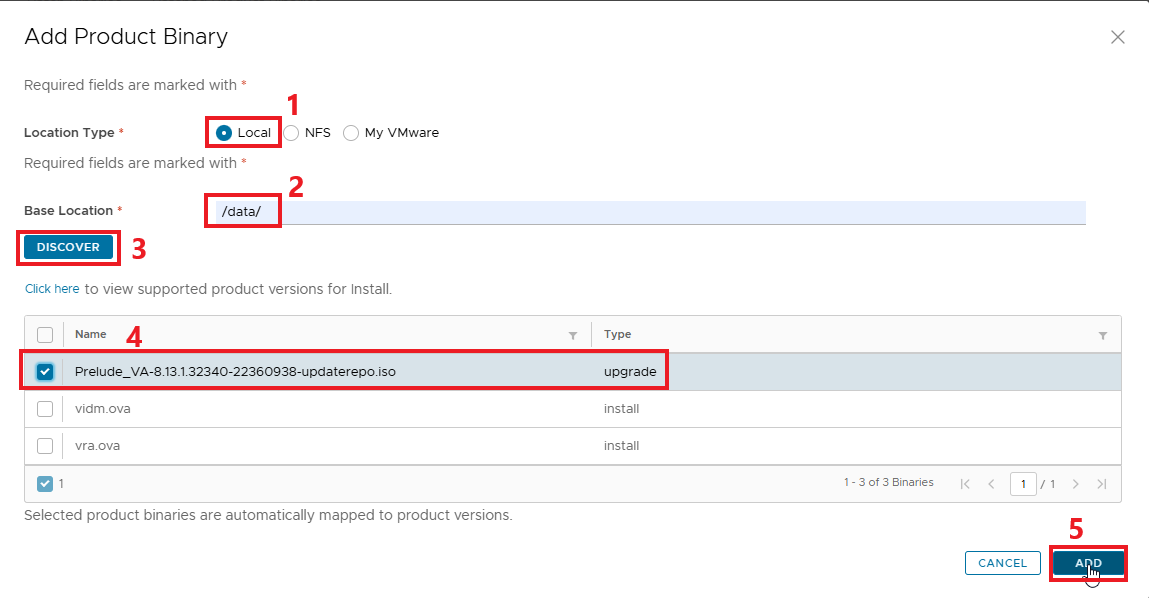

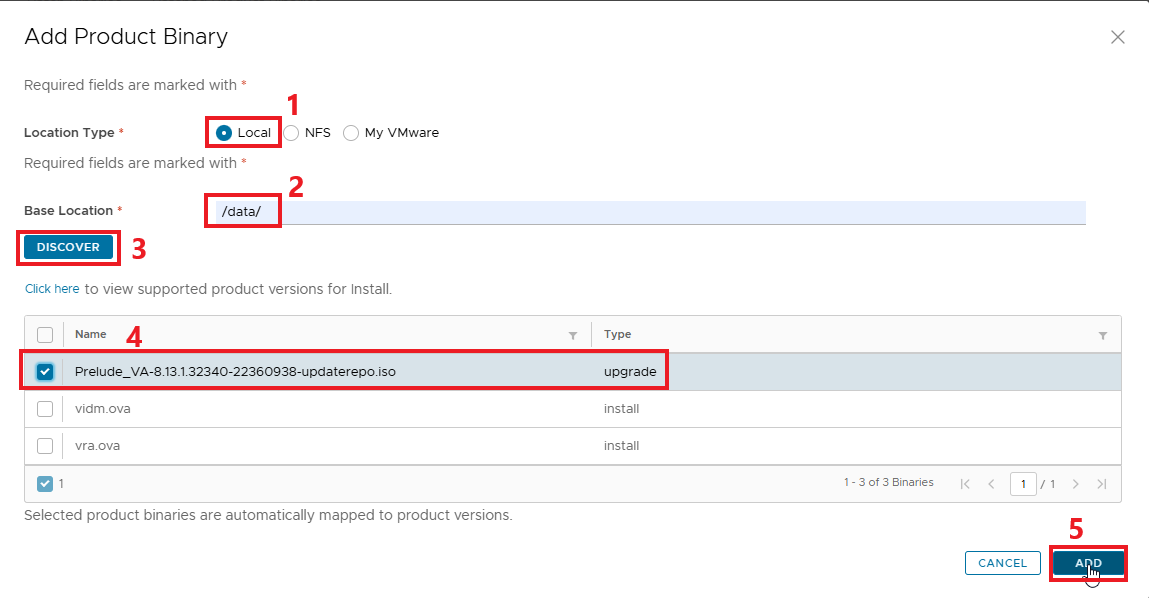

Questa volta la ISO va caricata direttamente su LCM, è possibile trasferirla via SCP al percorso /data

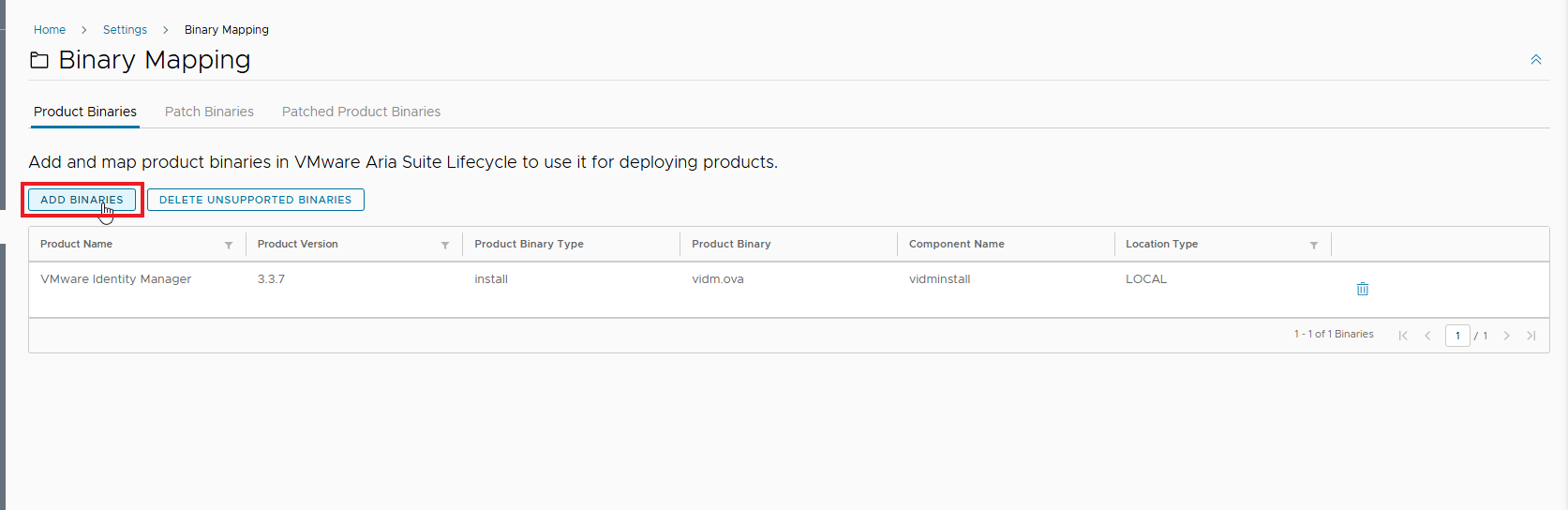

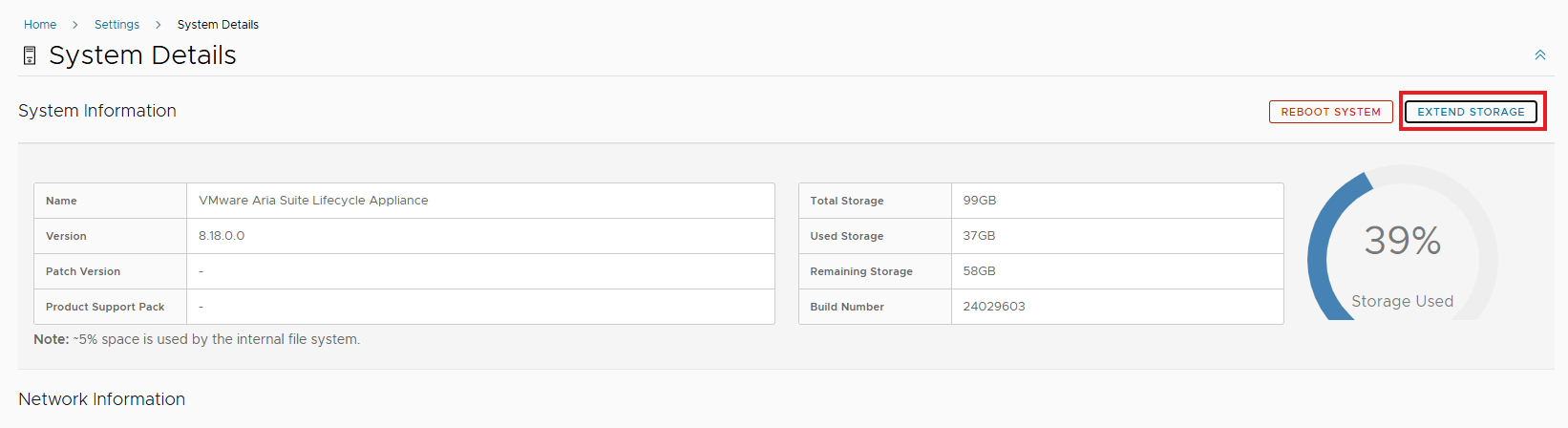

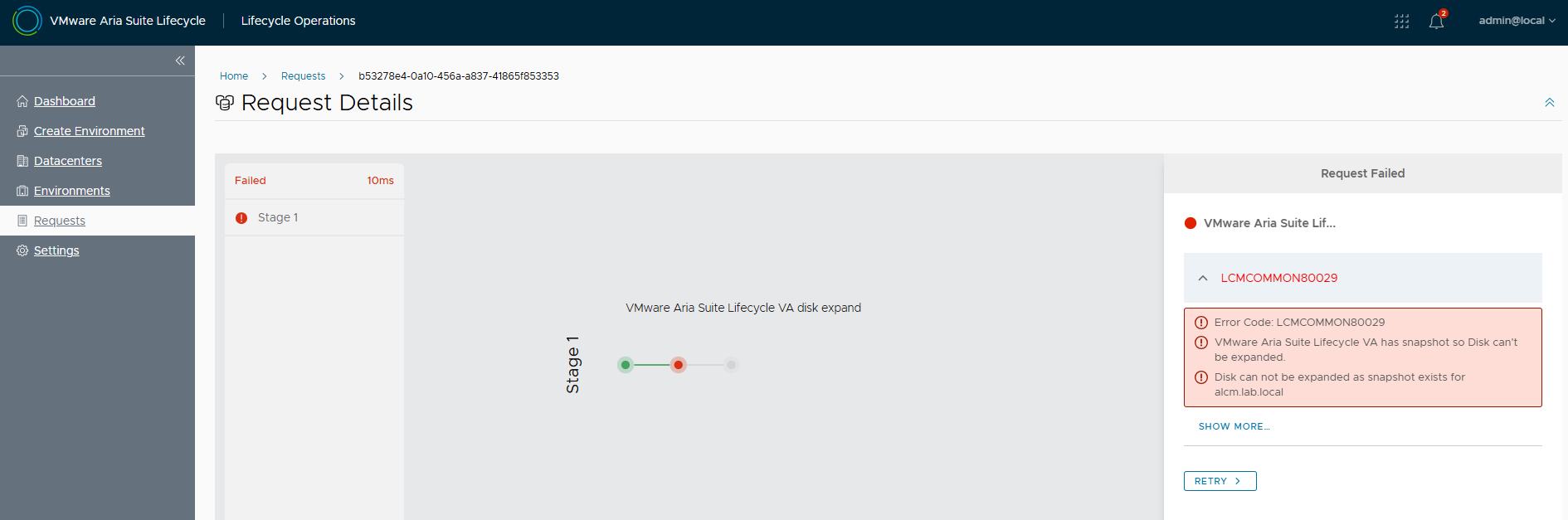

NOTA : Se non c’è abbastanza spazio disponibile sarà necessario rimuovere vra.ova con cui è stata fatta l’installazione da EASY INSTALLER. Oltre a rimuovere l’immagine da Binary Mapping sarà necessario rimuoverla fisicamente da /data via CLI

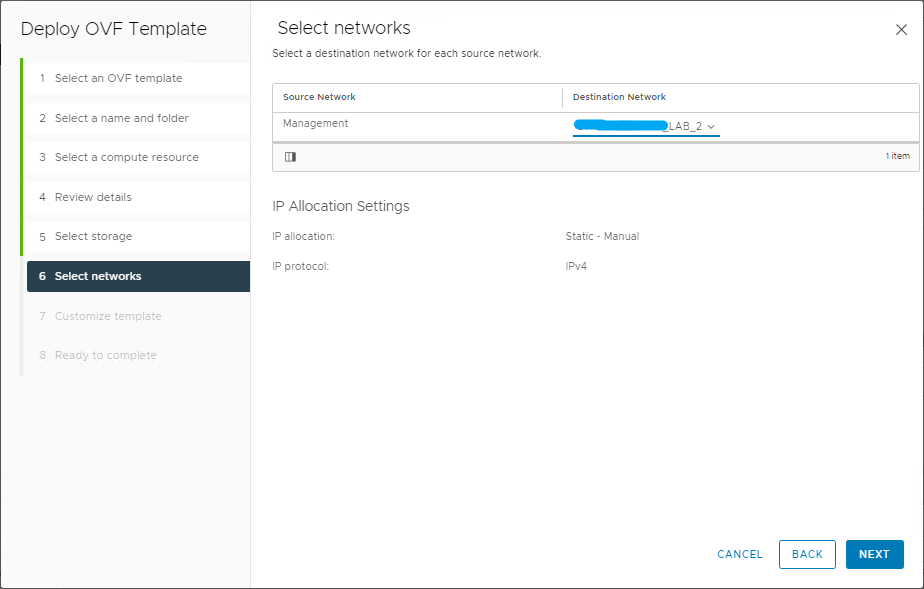

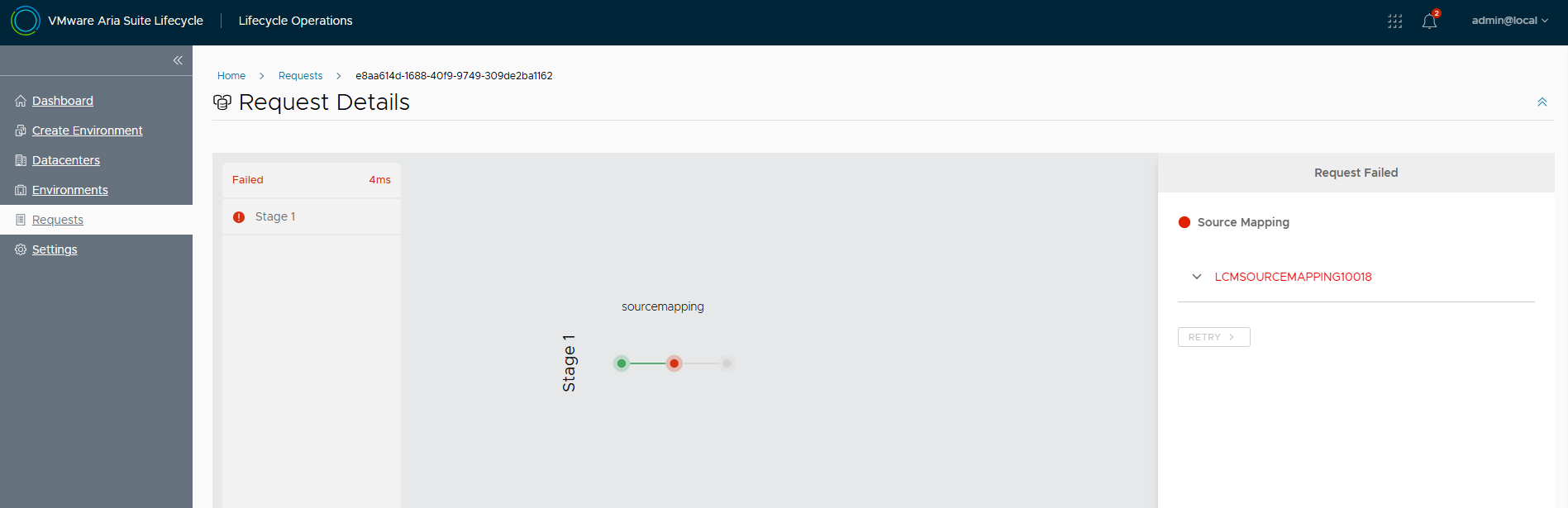

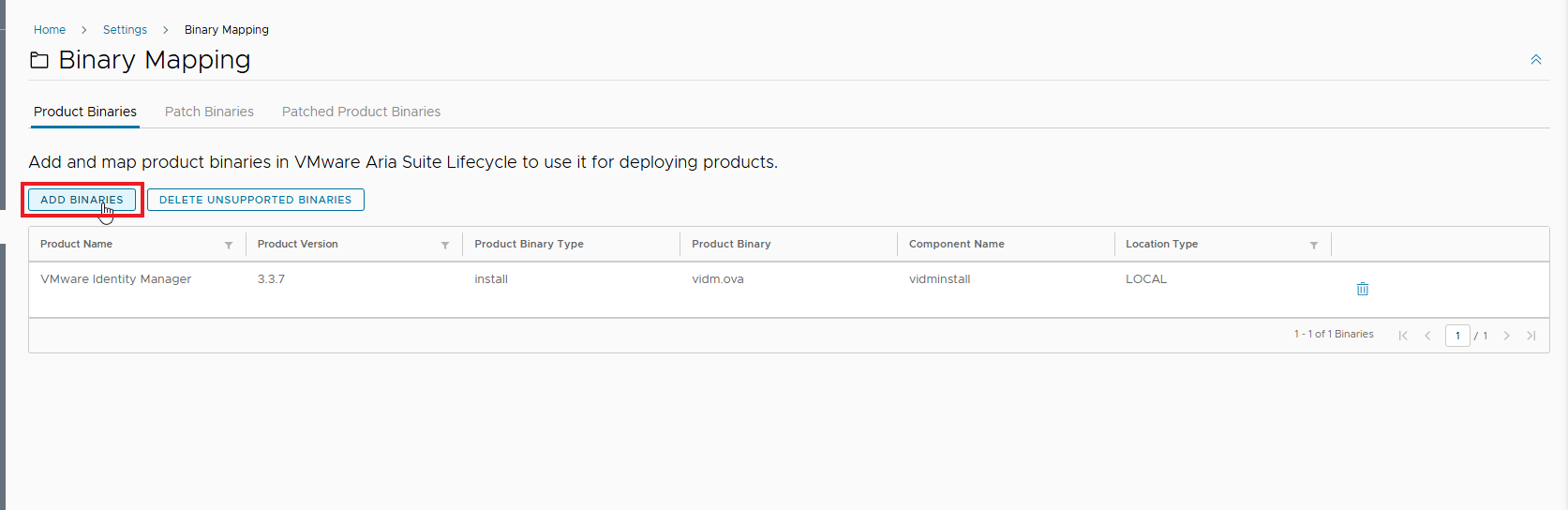

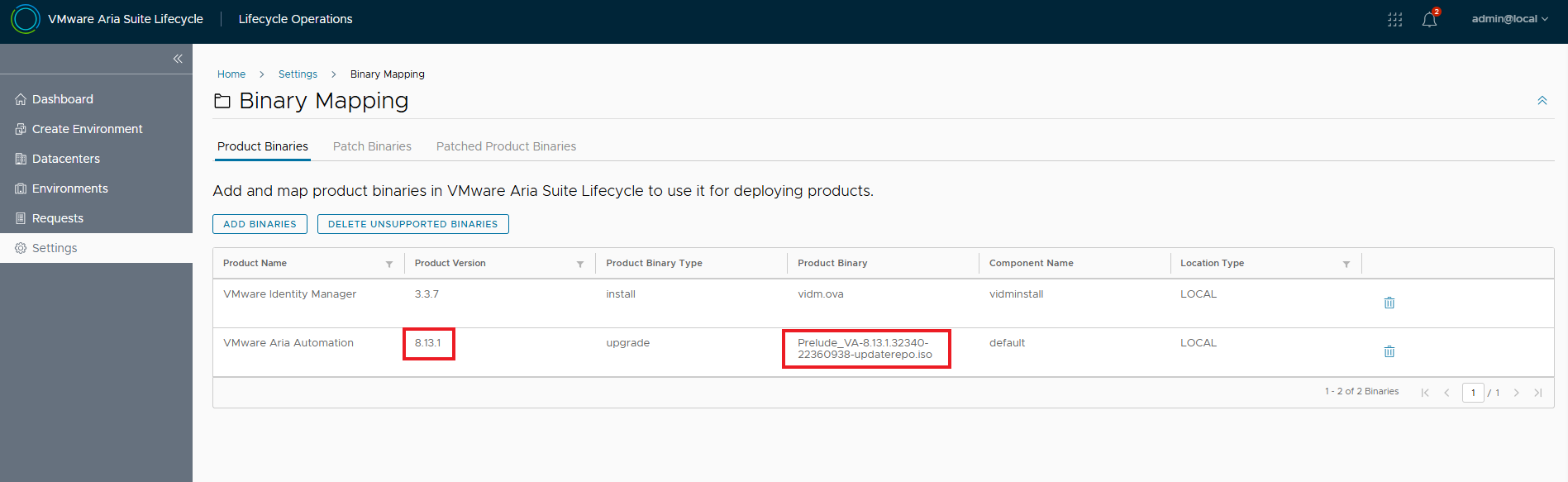

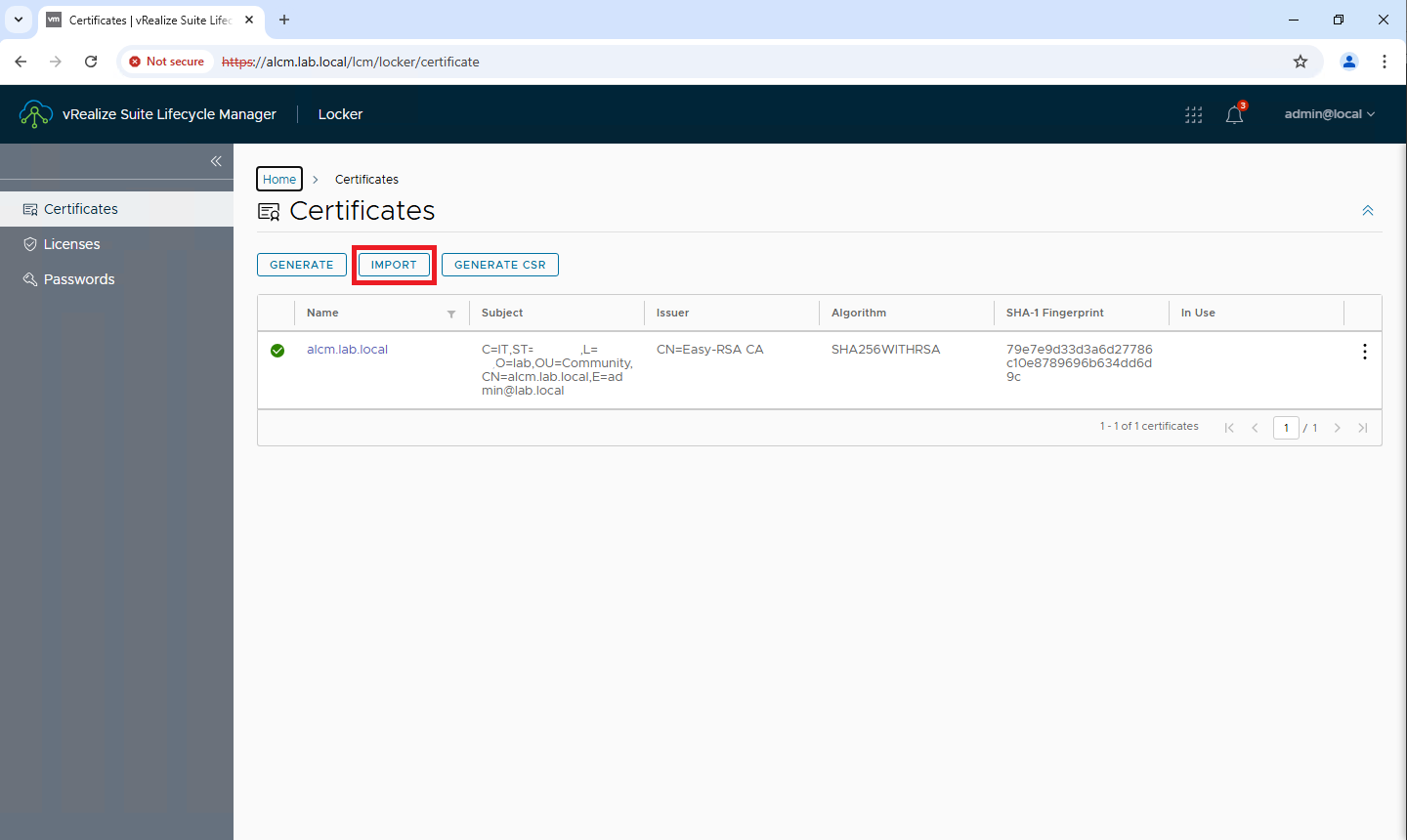

Mappiamo la ISO da Binary Mapping

La nuova immagine è disponibile per l’upgrade!

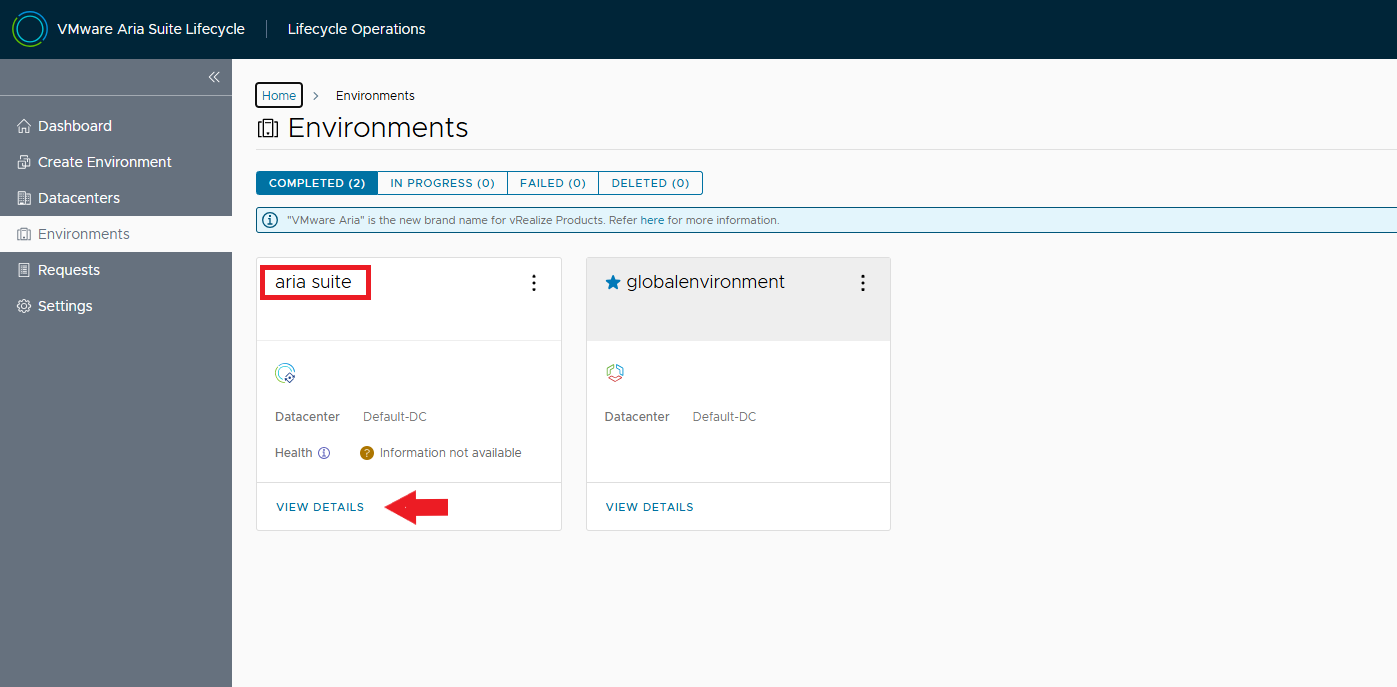

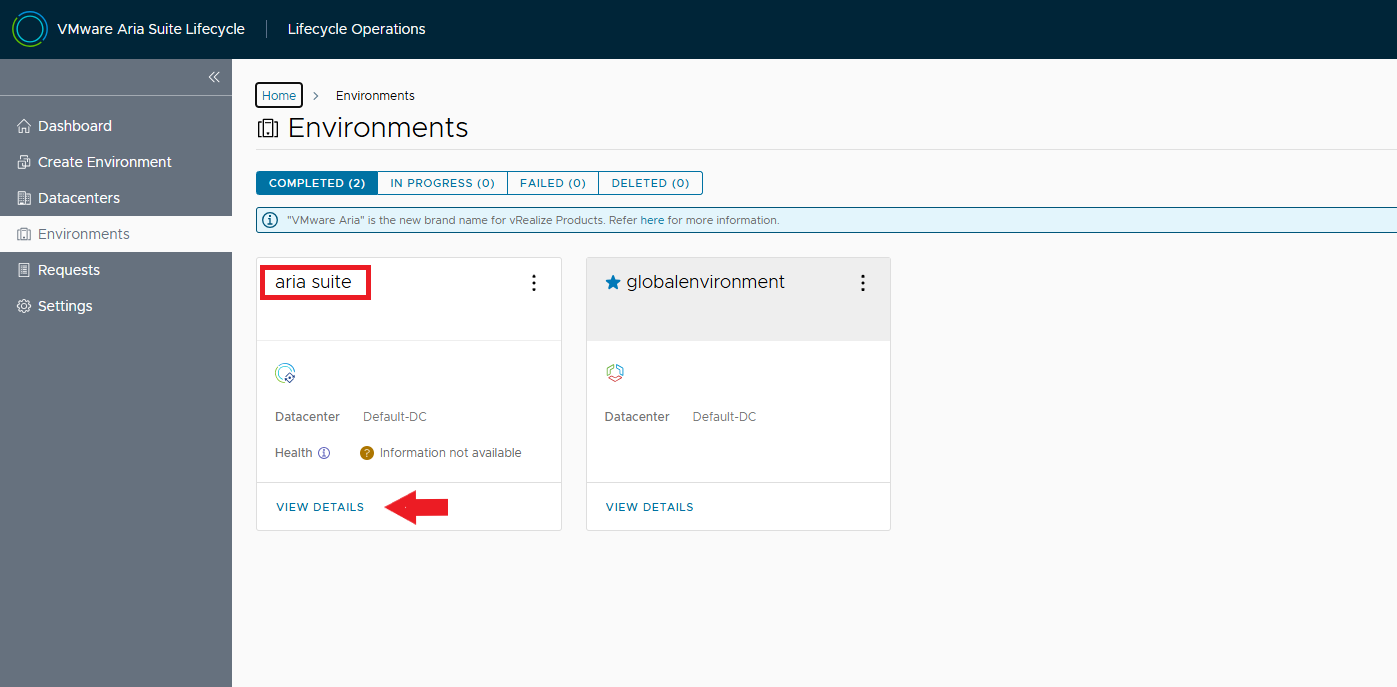

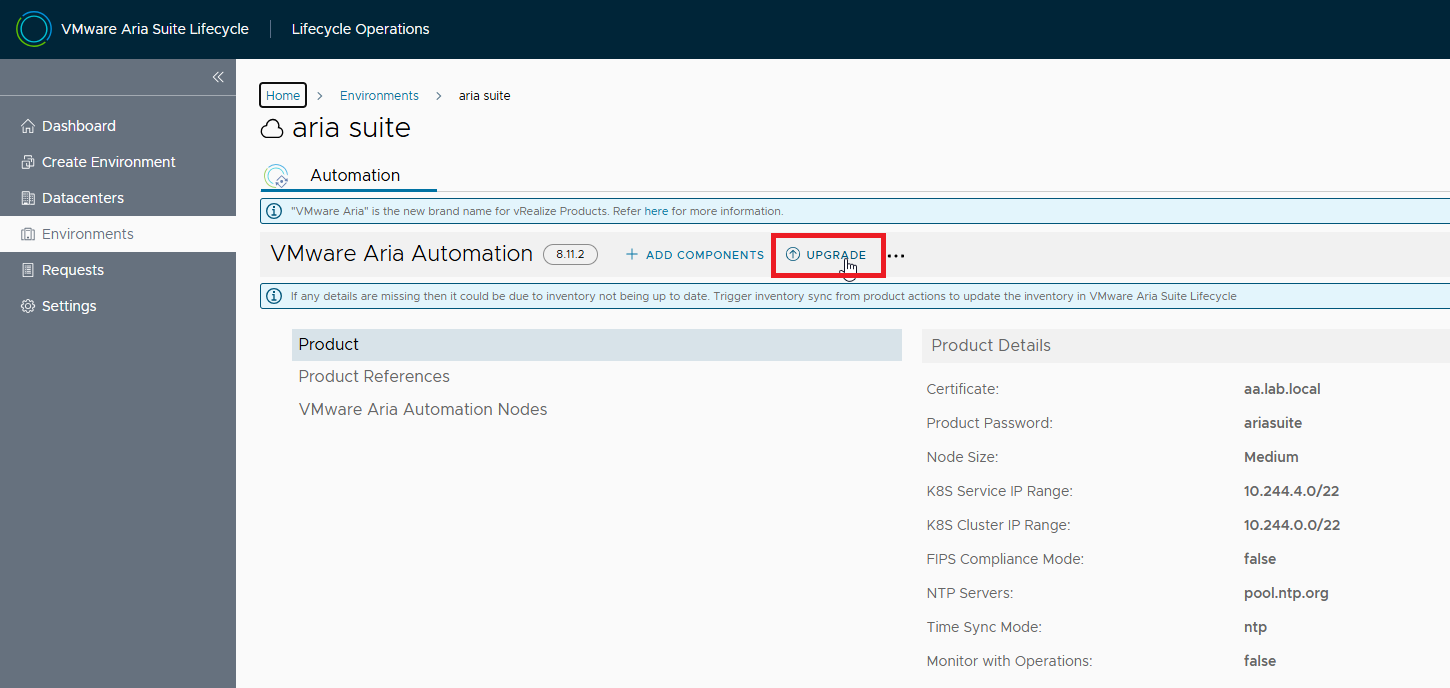

Andiamo a selezionare l’environment che ospita Aria Automation, VIEW DETAILS

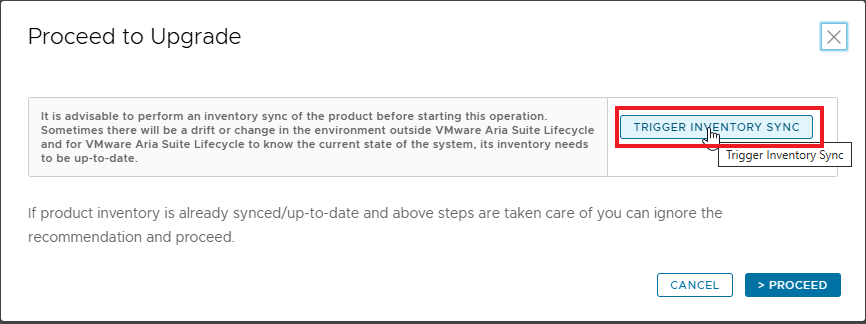

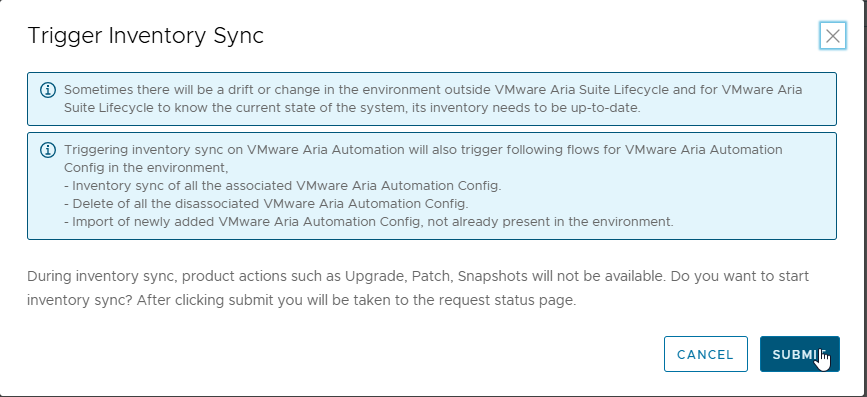

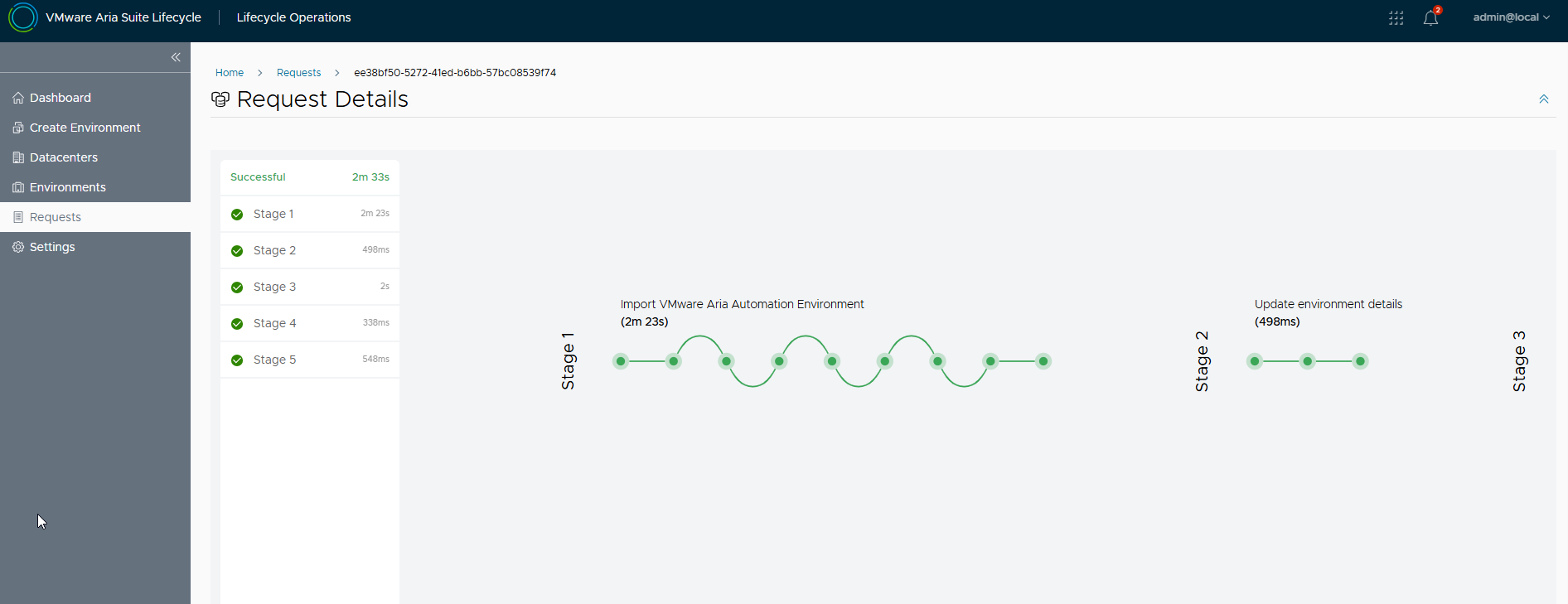

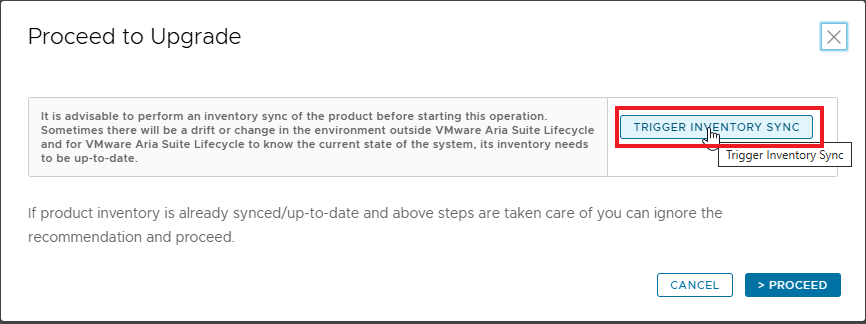

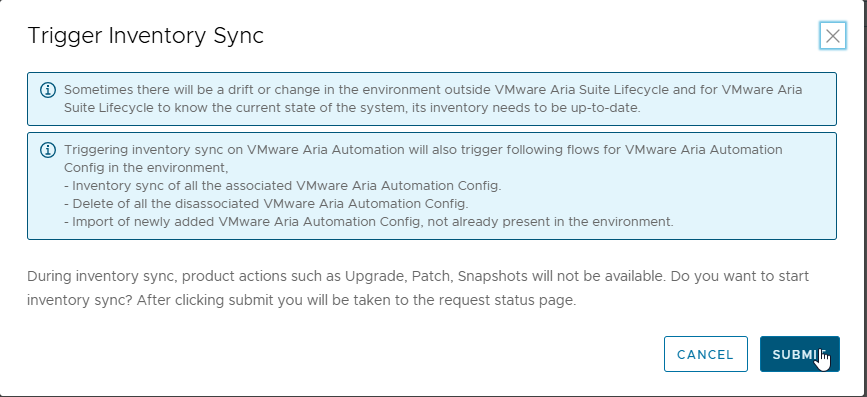

Prima di procedere con l’upgrade eseguire un TRIGGER INVENTORY SYNC e verificare che il job si completi con successo

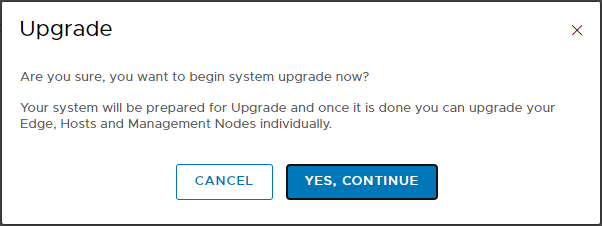

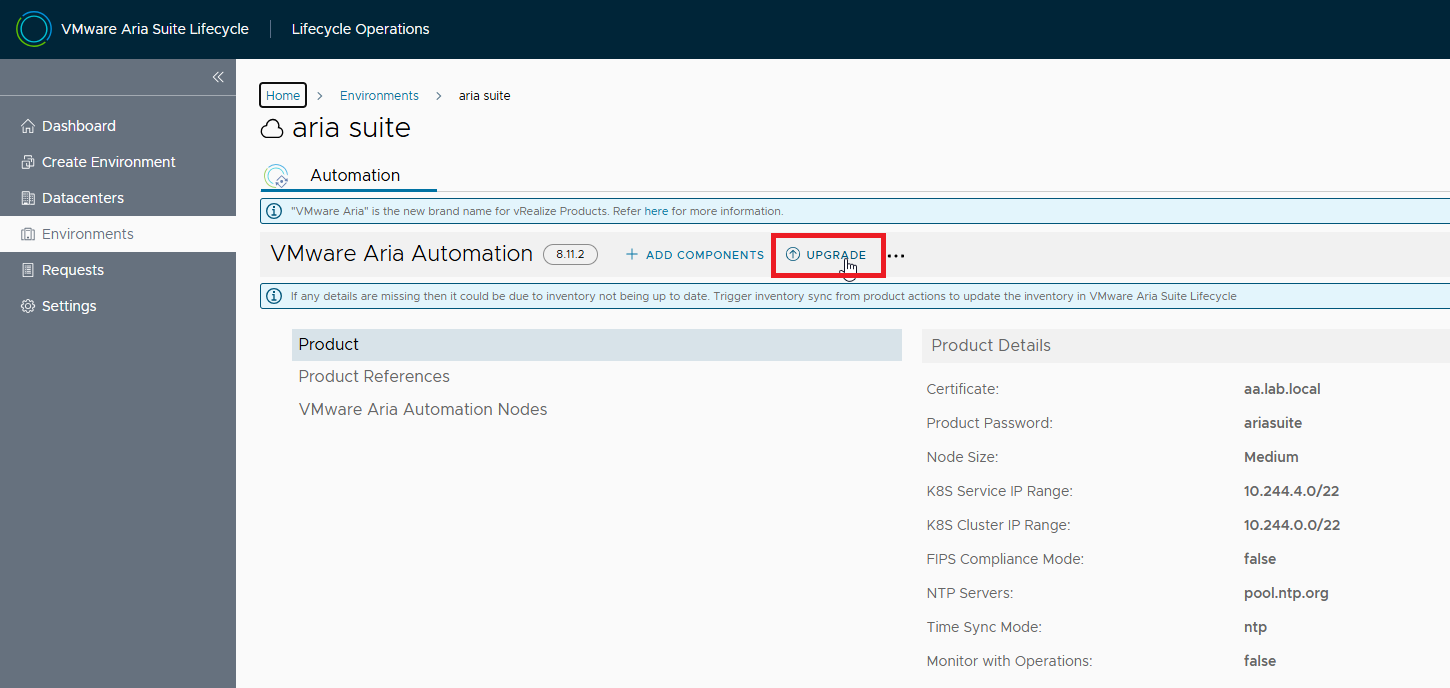

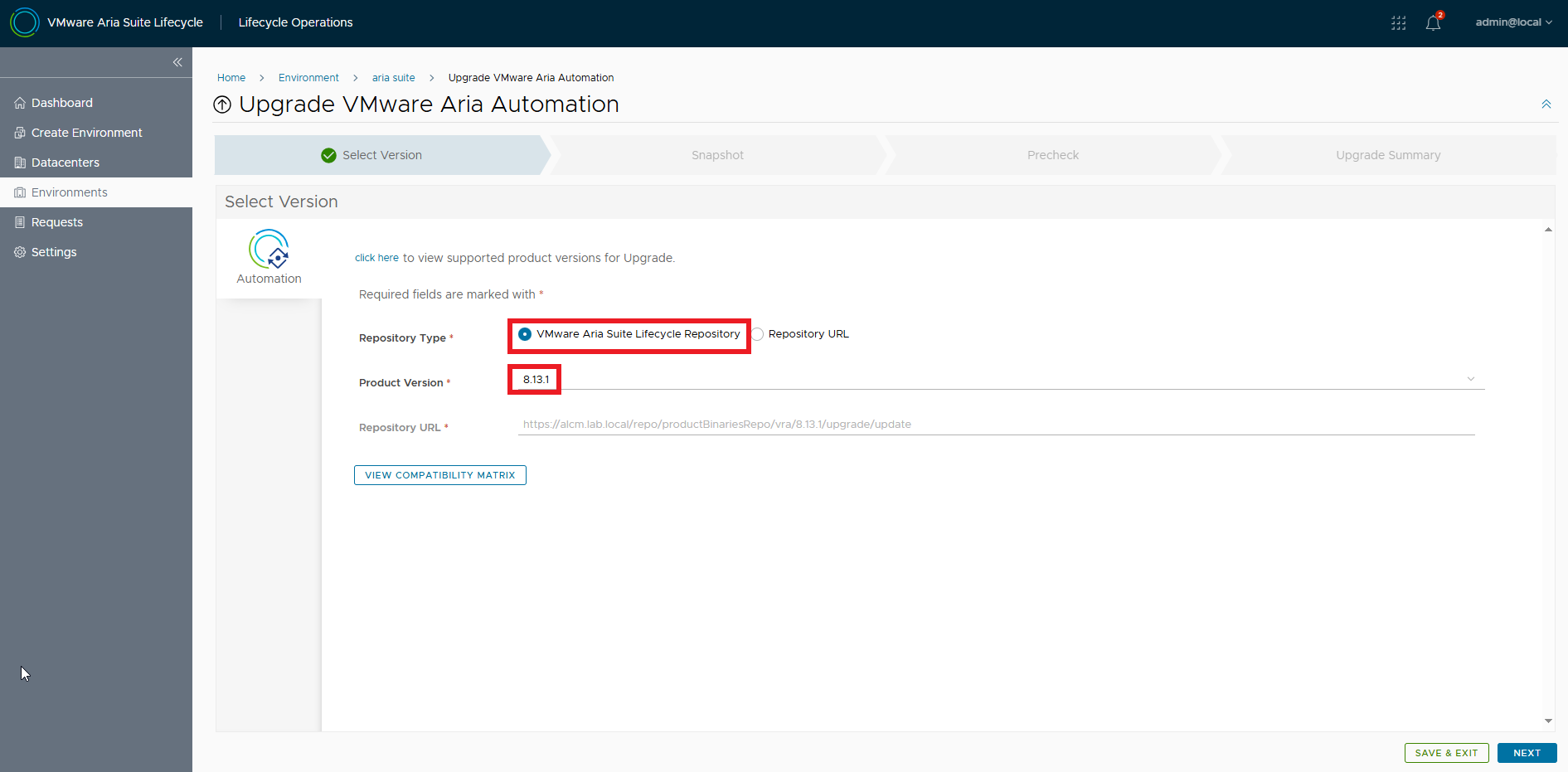

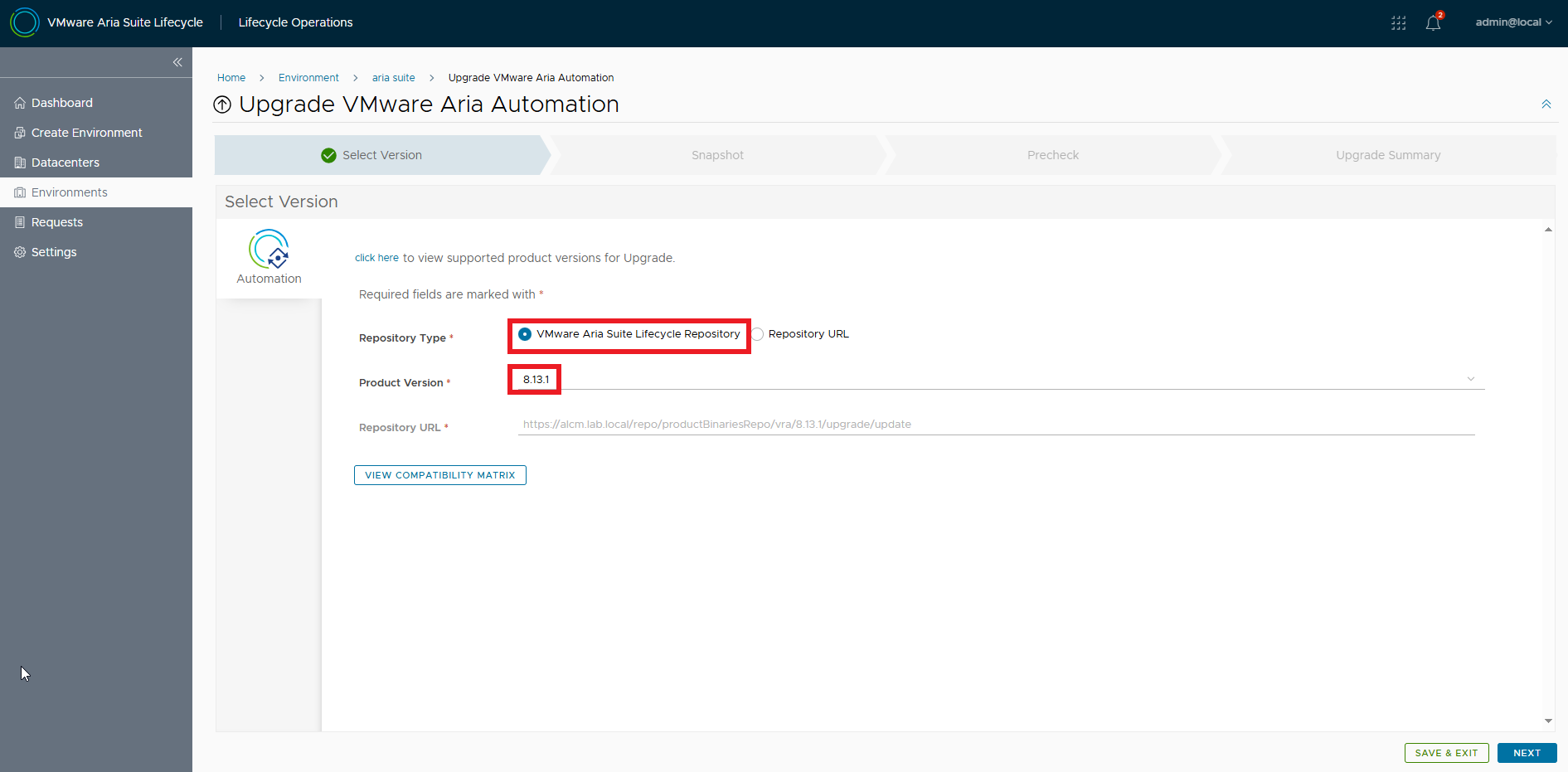

Torniamo alla procedura di upgrade, la nuova release è disponibile

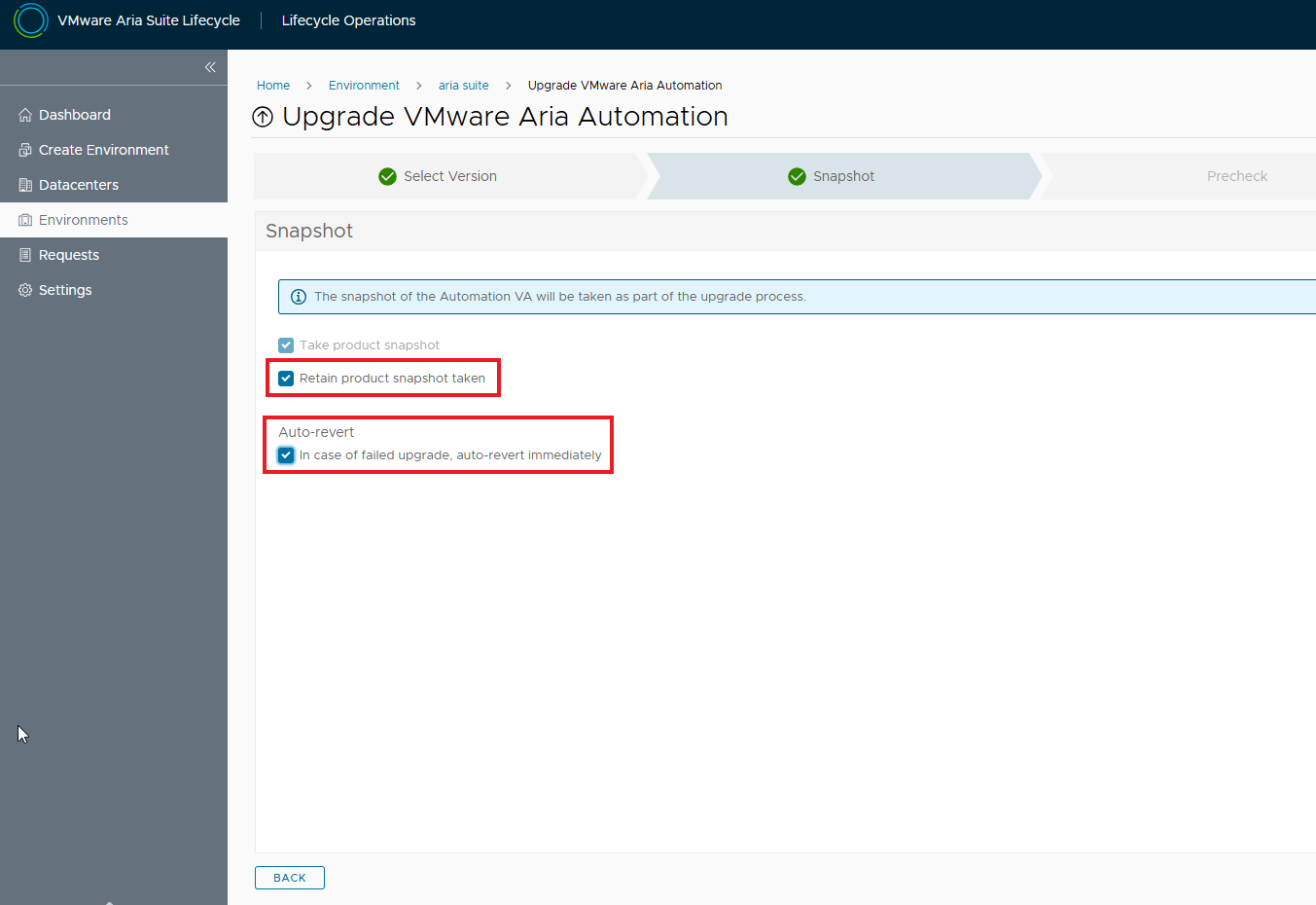

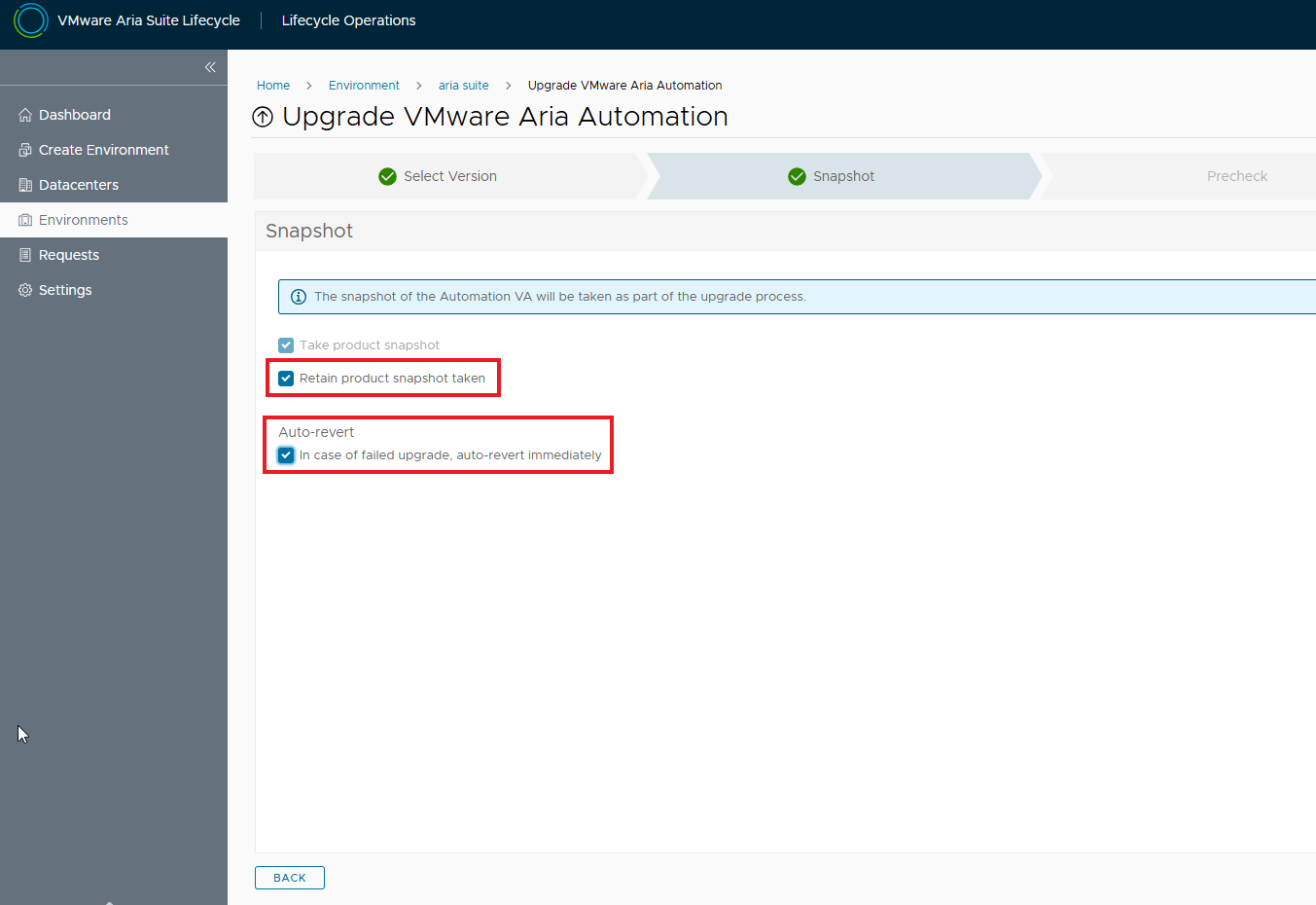

Abilitare i flag per lo snapshot e l’eventuale rollback in caso di problemi durante l’upgrade

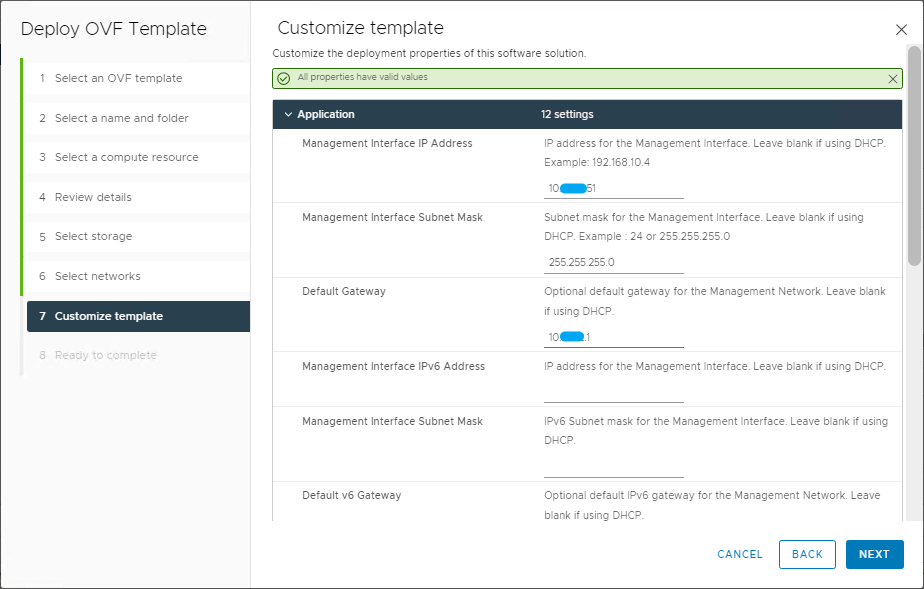

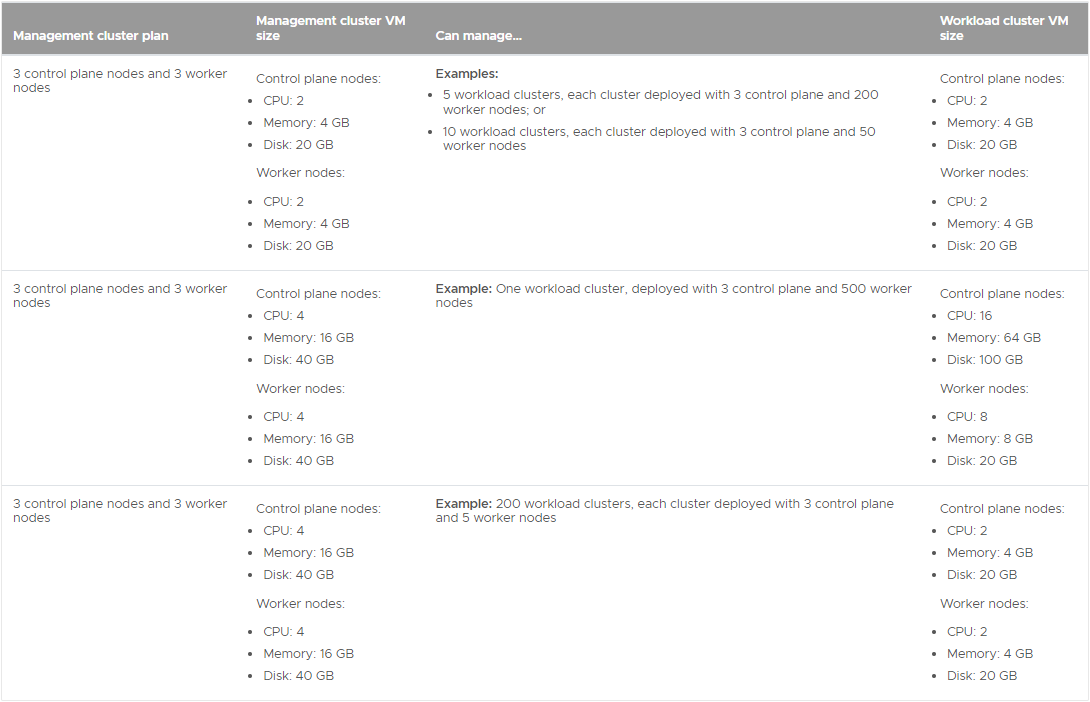

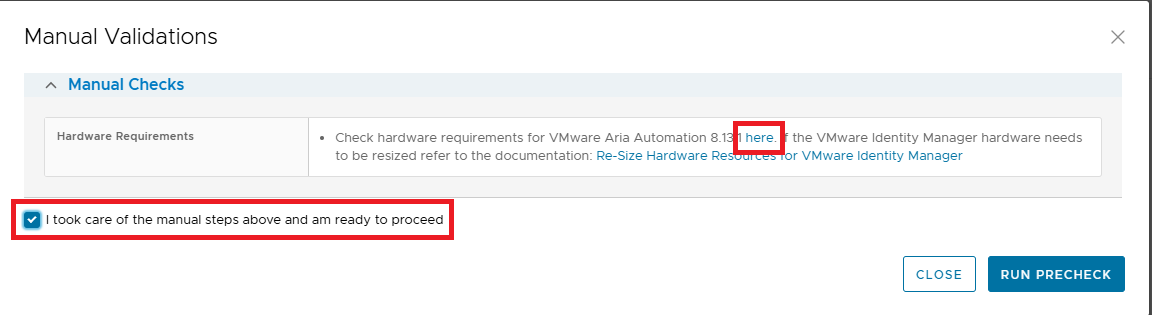

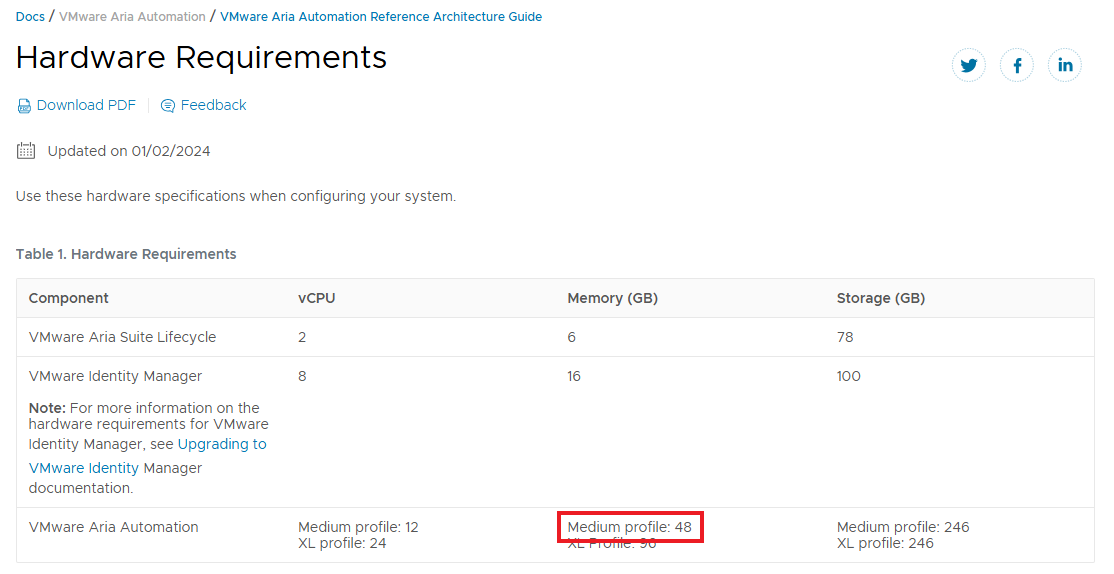

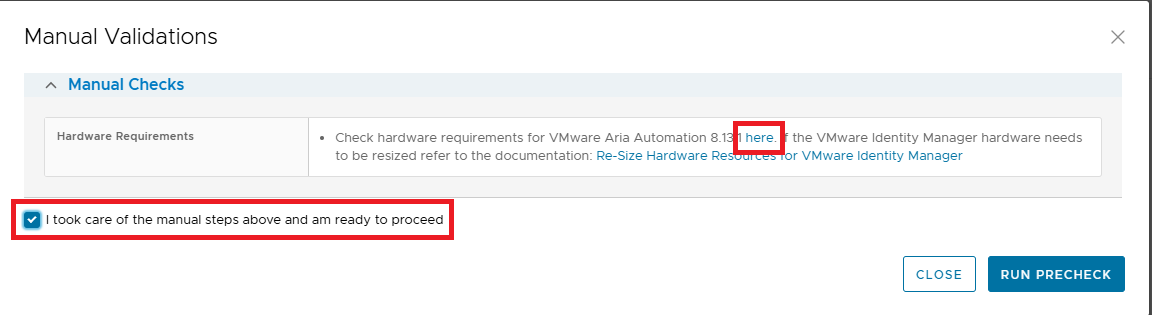

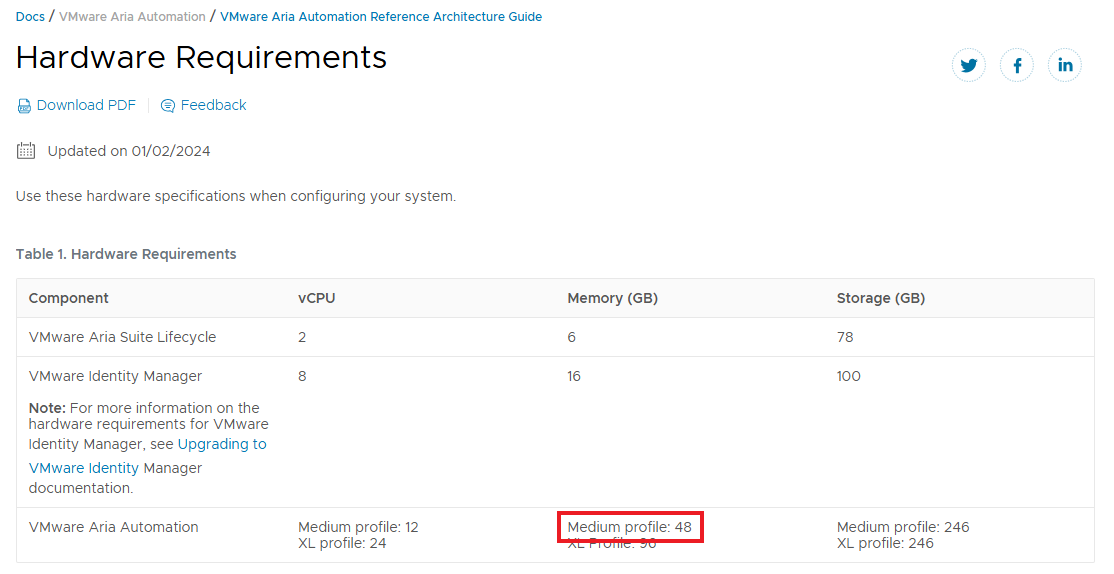

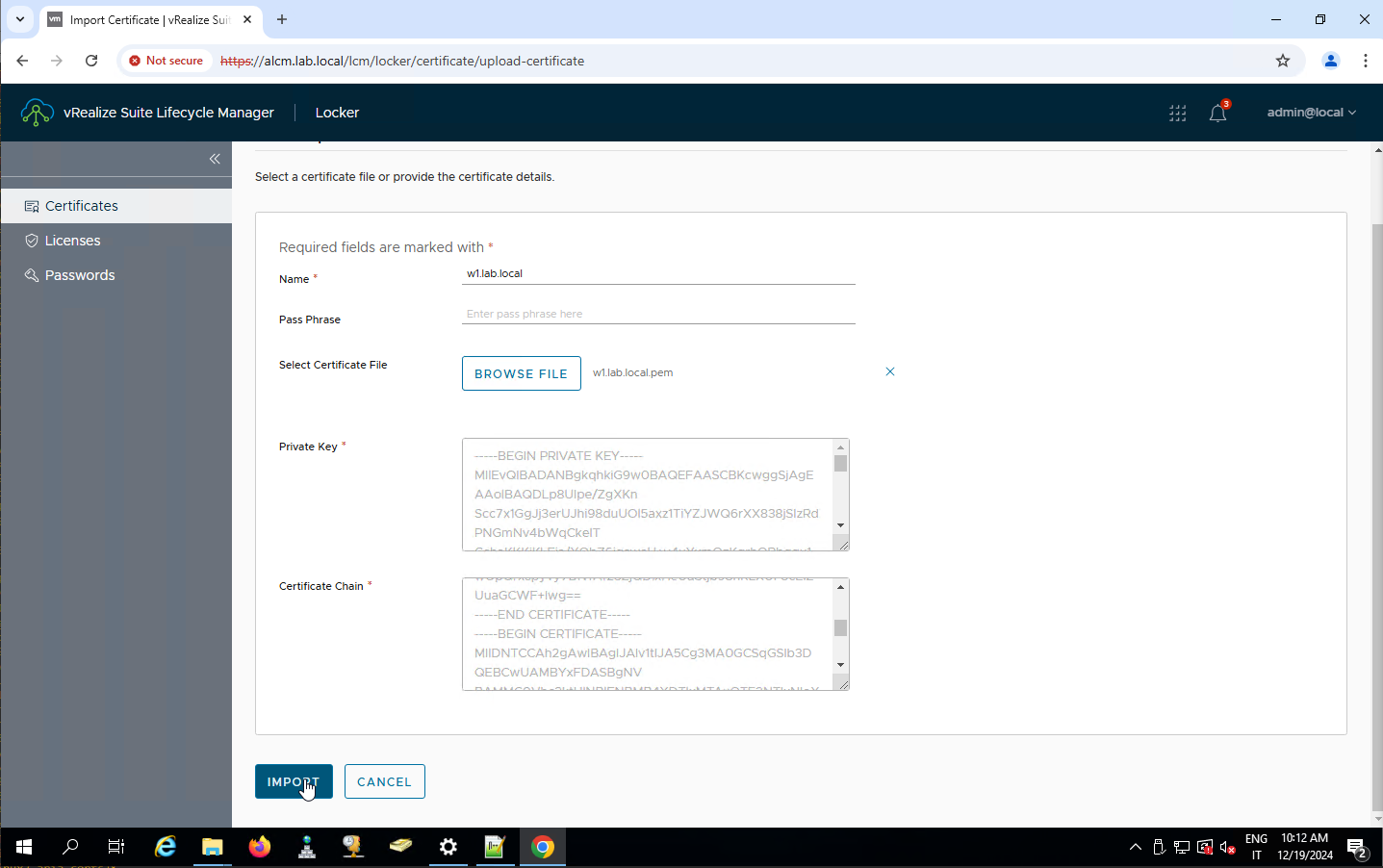

Verifichiamo i requisiti hardware per la nuova release seguendo il link evidenziato

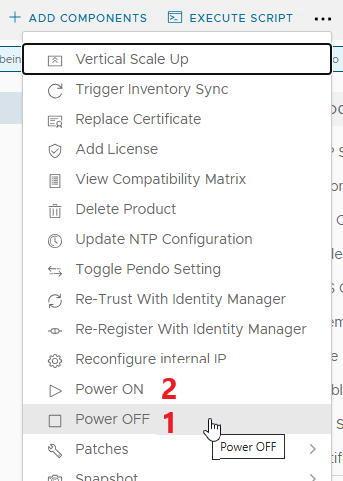

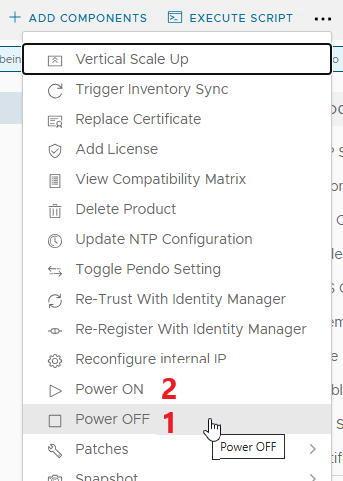

La RAM necessaria è di 48GB, la mia attuale implementazione è MEDIUM e sarà necessario aumentare la RAM come richiesto. Per far questo utilizzare le day 2 operations dall’environment, prima POWER OFF, modificare la RAM dal vSphere Client e poi POWER ON. Attendere che i servizi ritornino attivi (richiede molto tempo!)

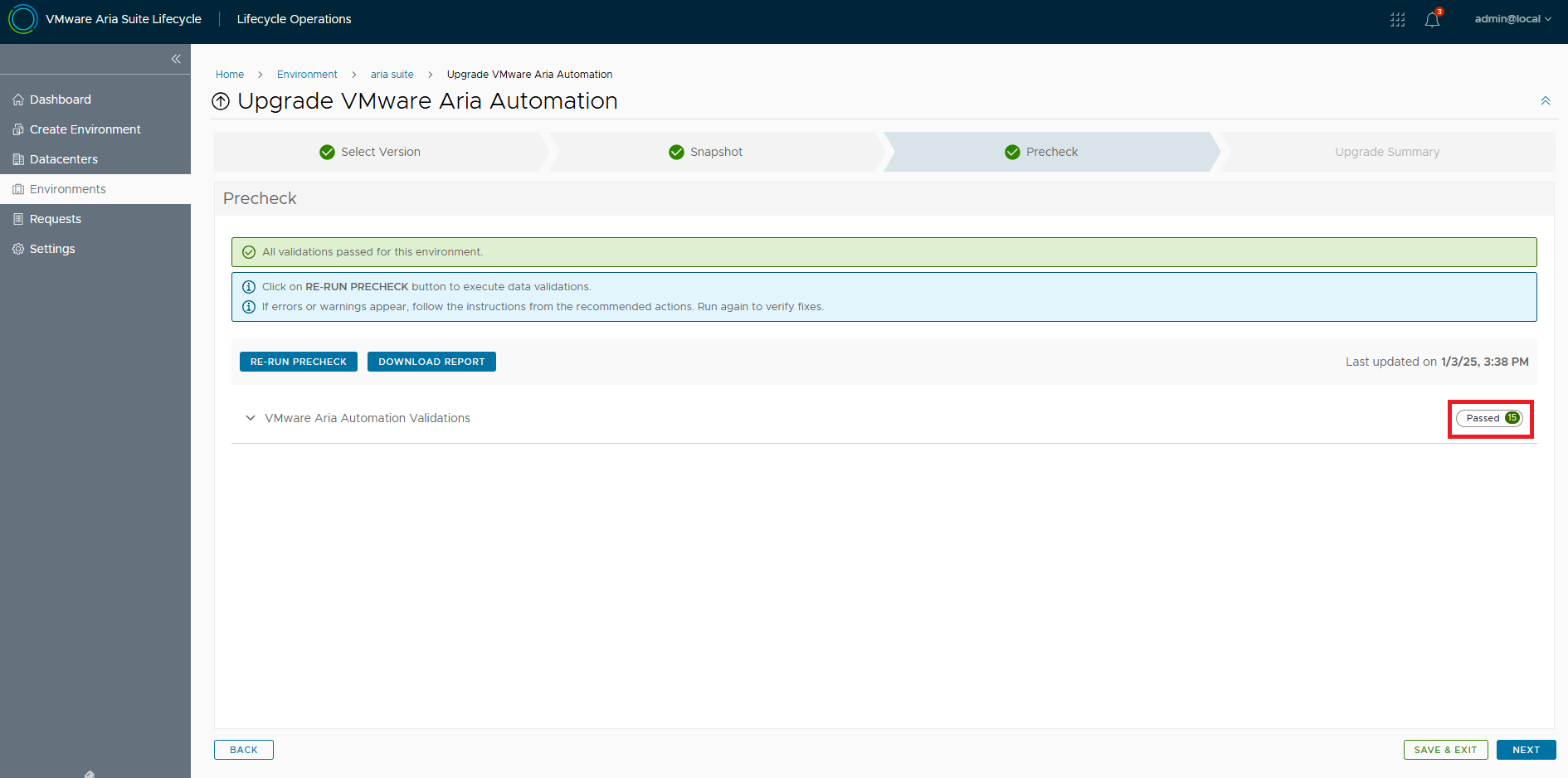

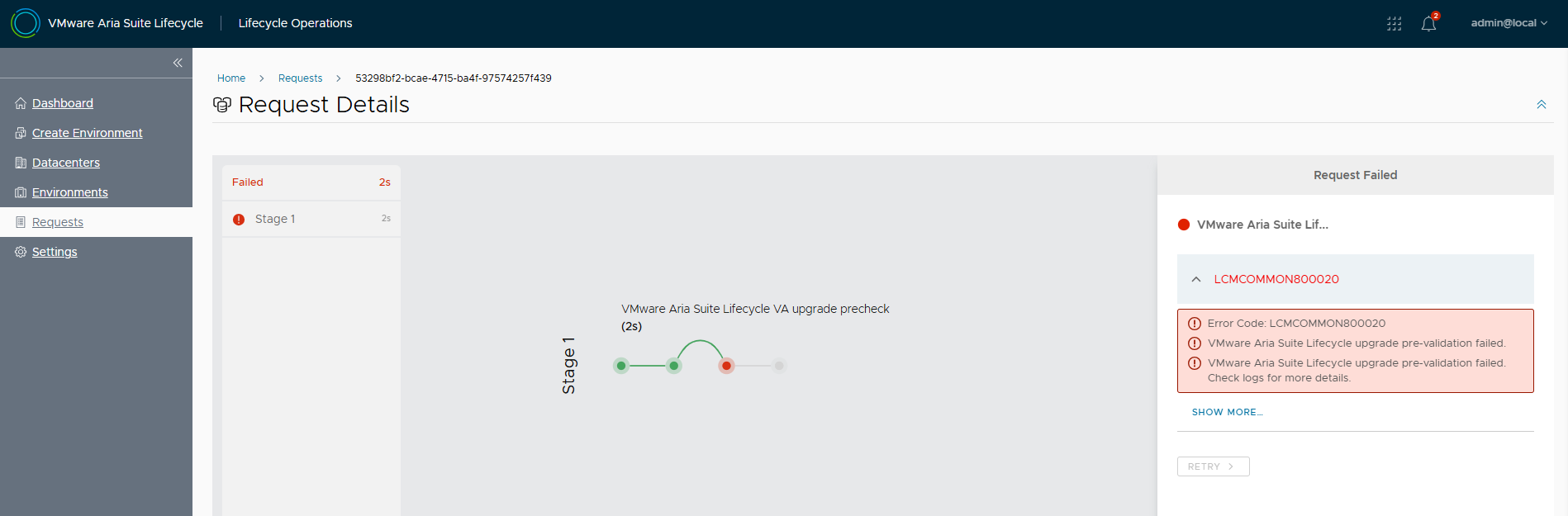

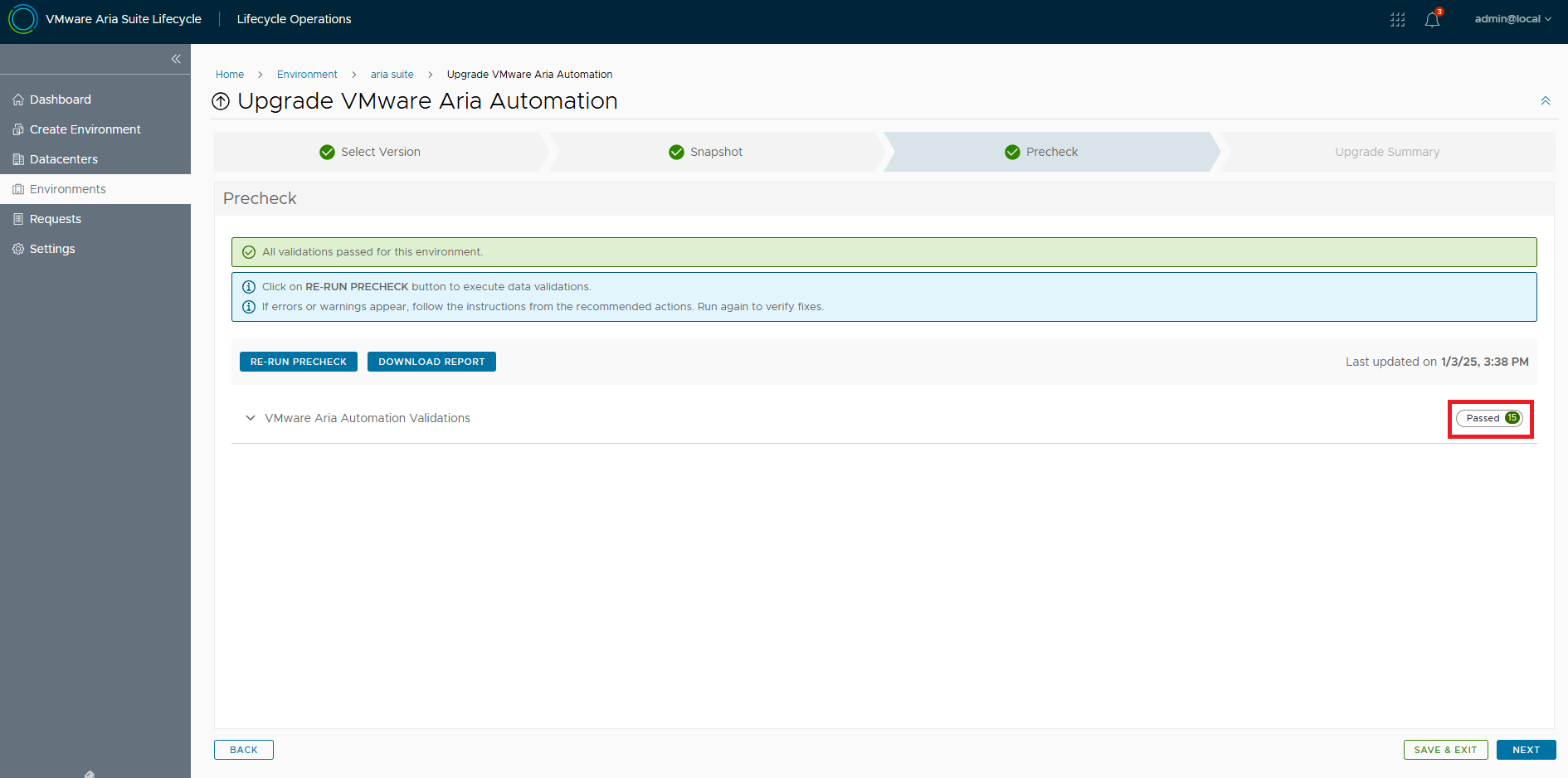

Riprendiamo l’upgrade eseguendo i pre-check

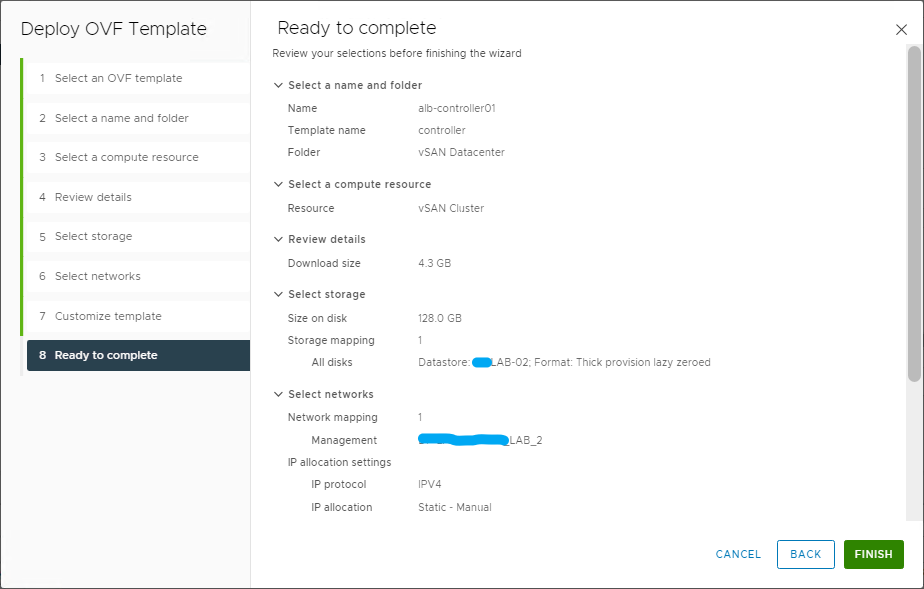

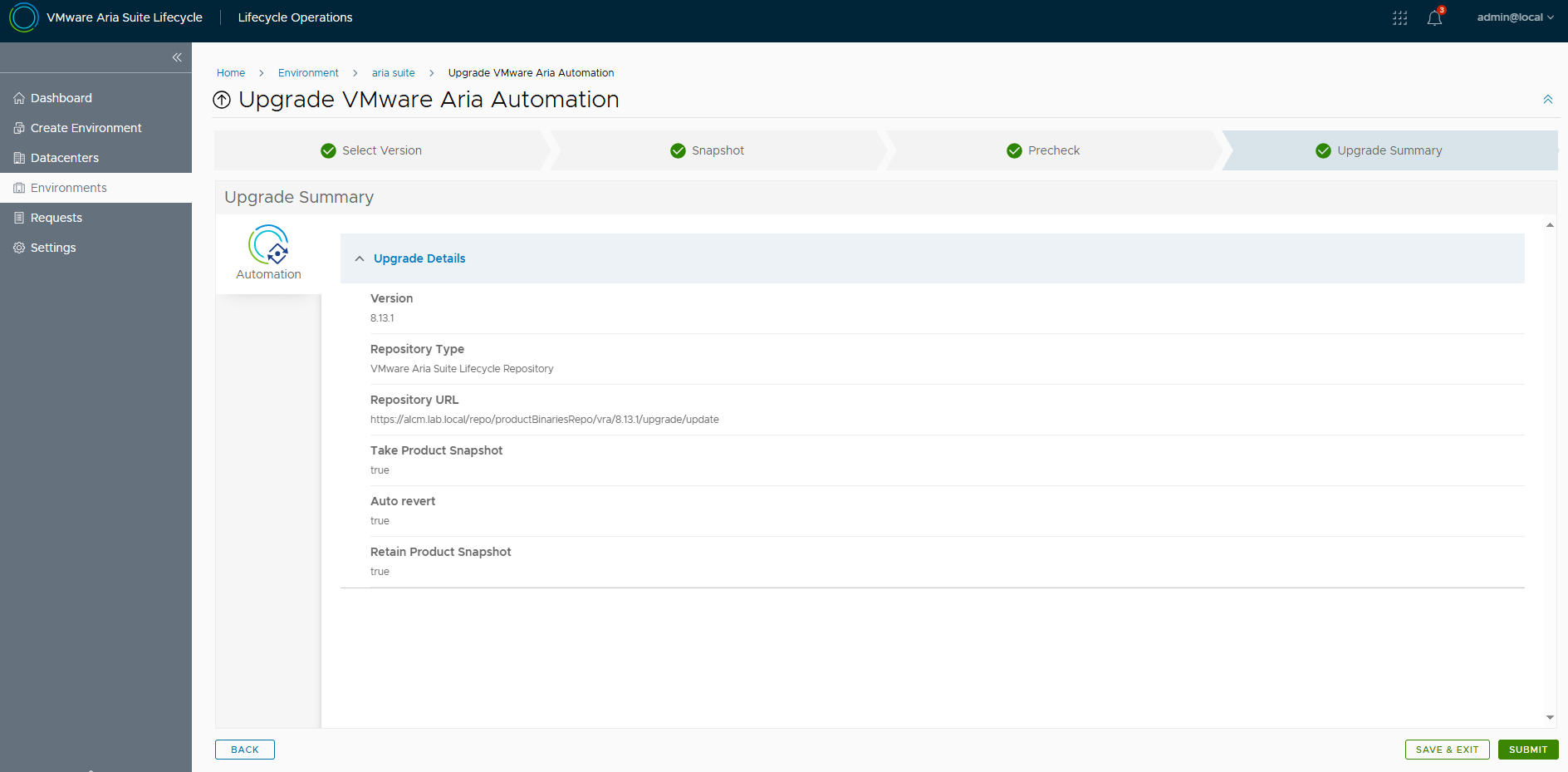

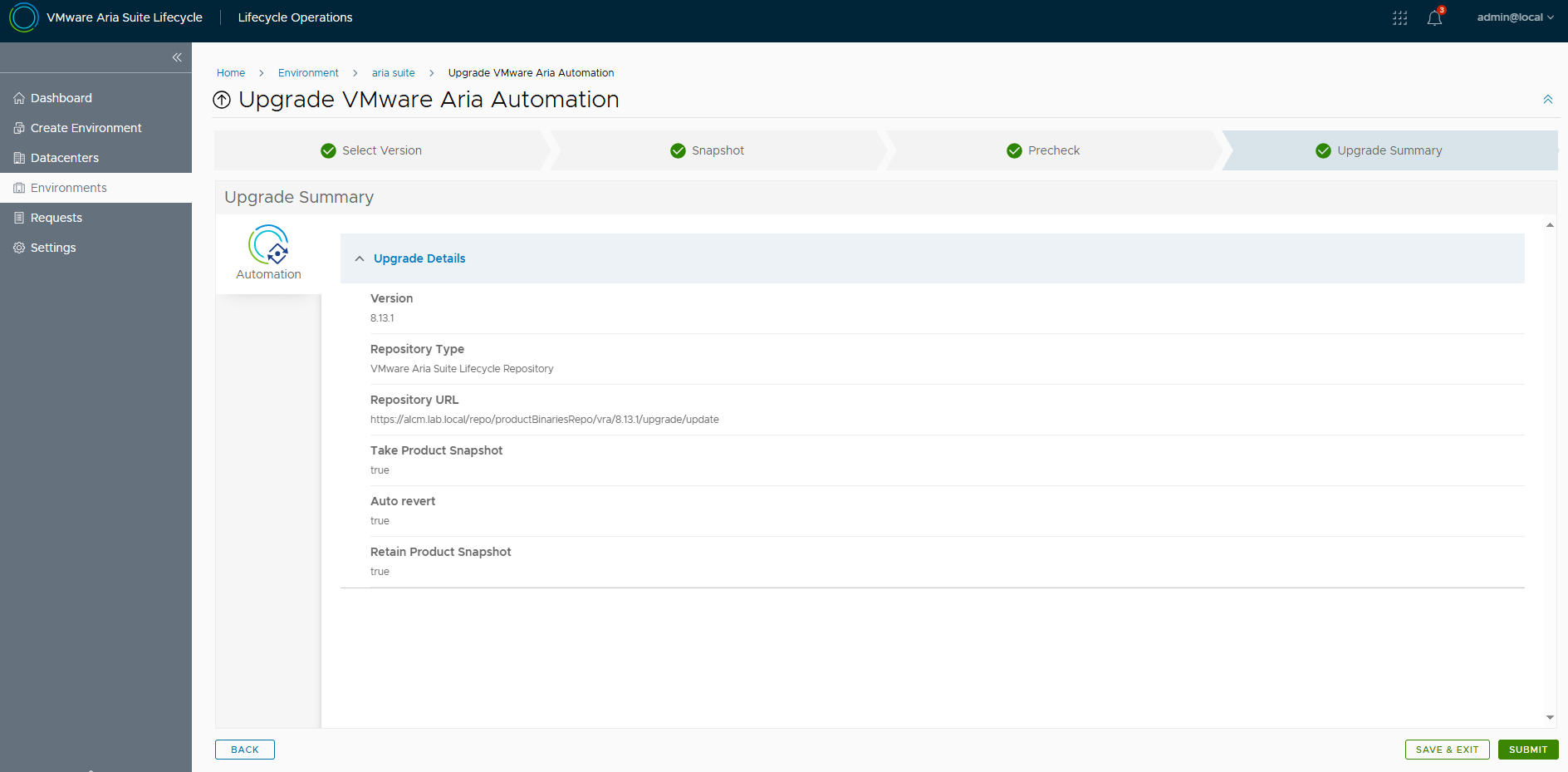

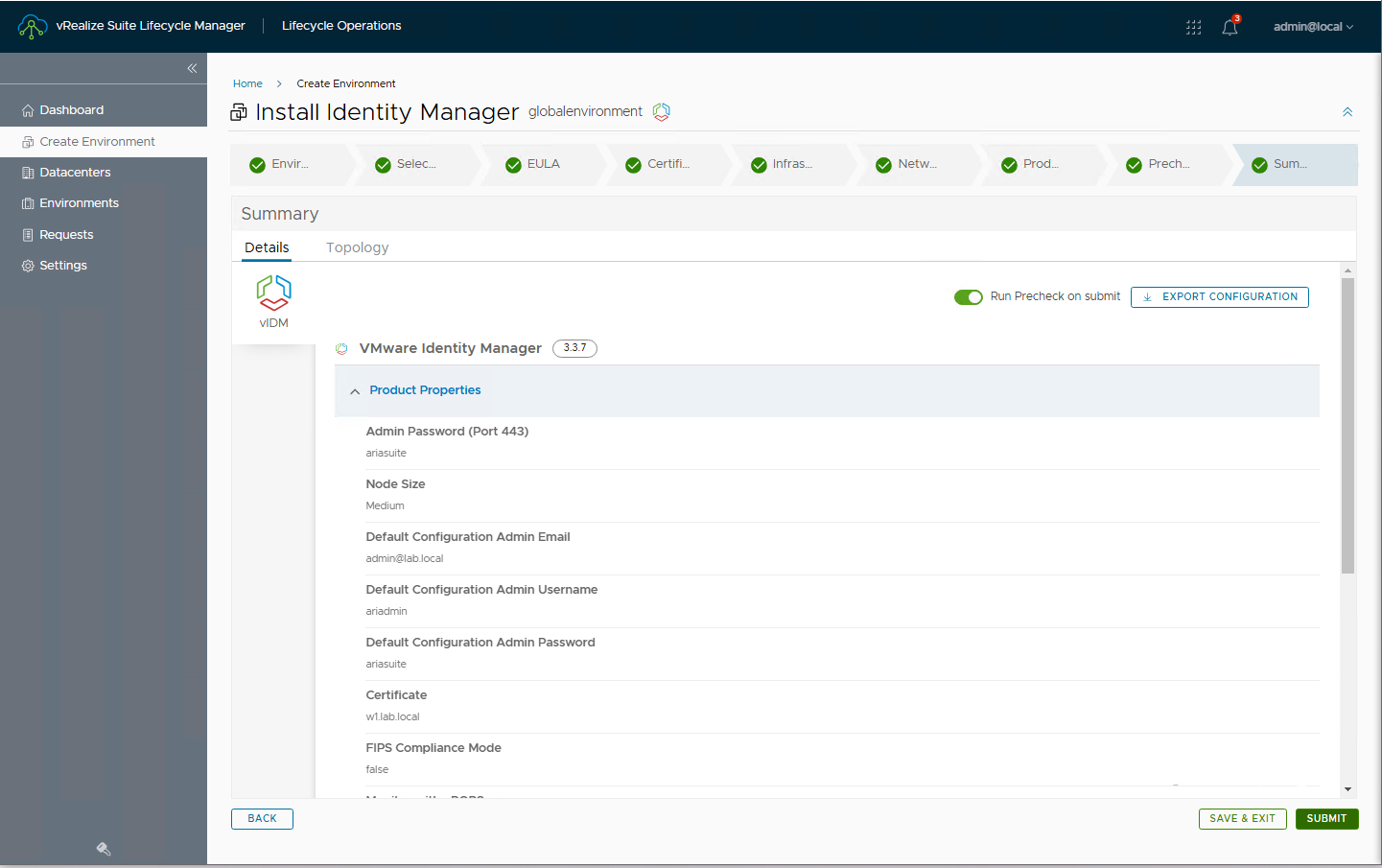

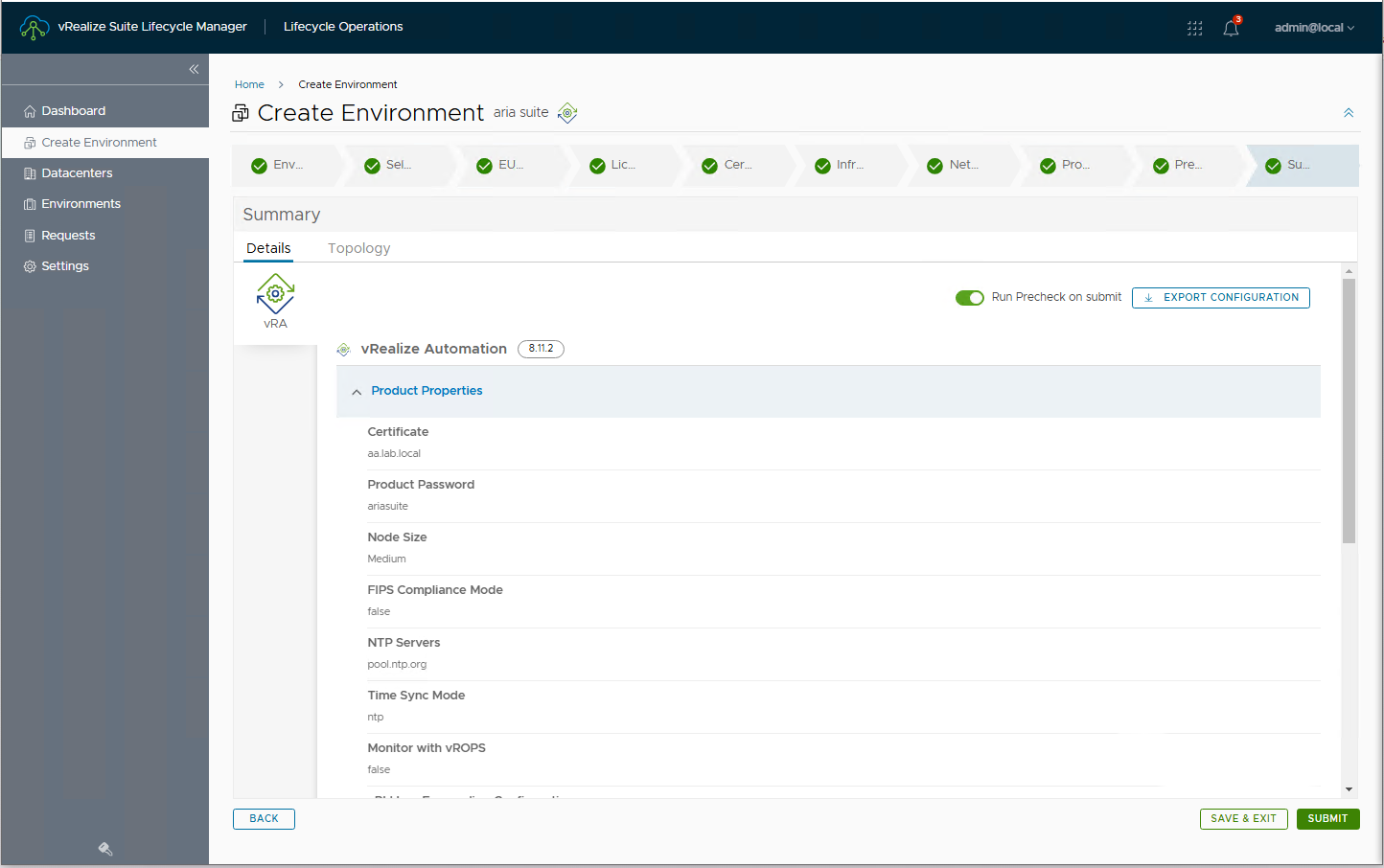

Andiamo all’Upgrade Summary e diamo Submit per iniziare l’upgrade

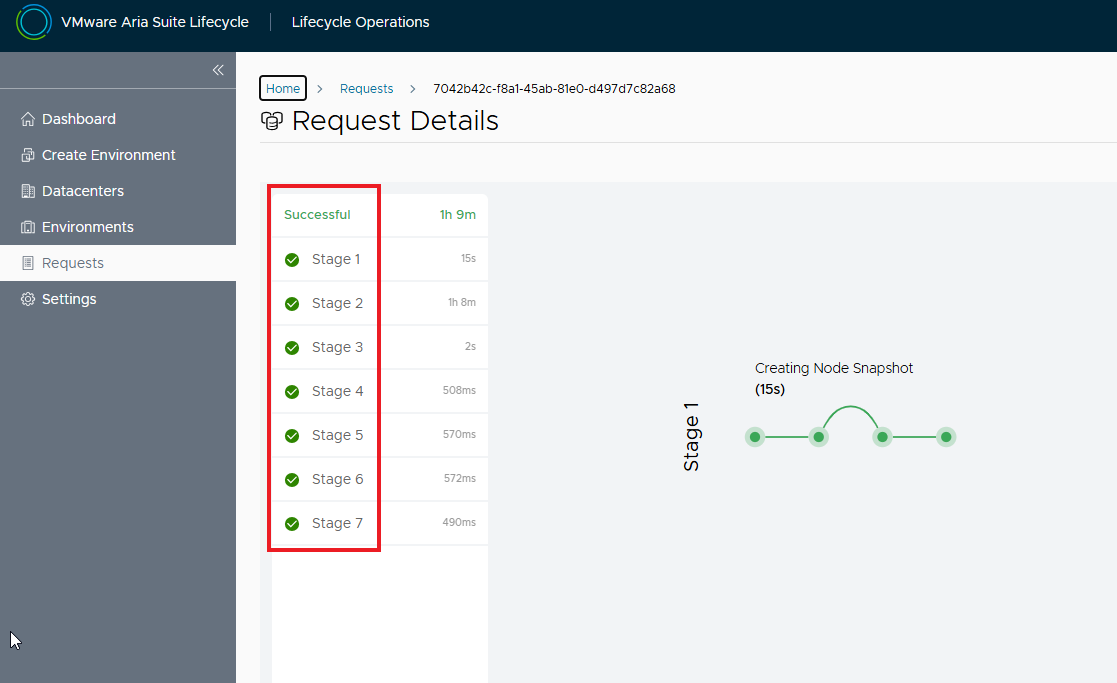

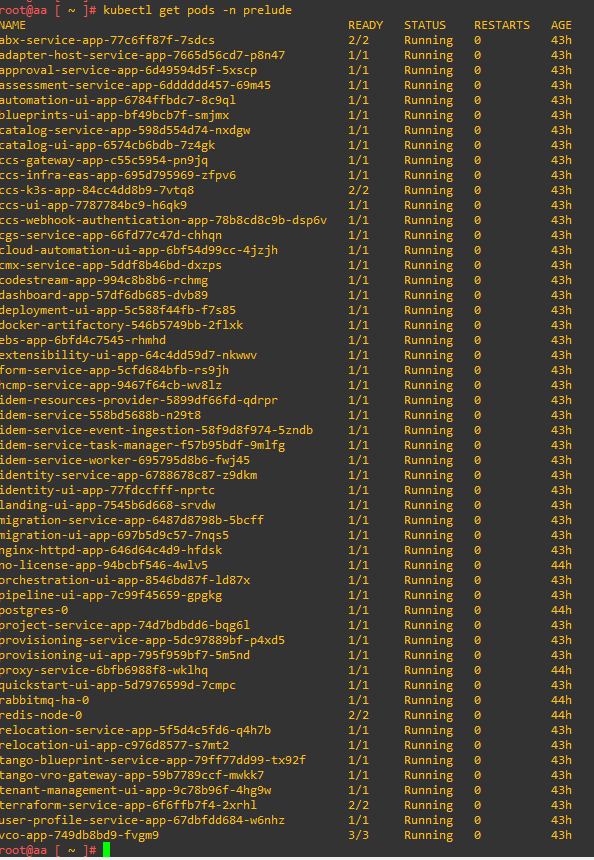

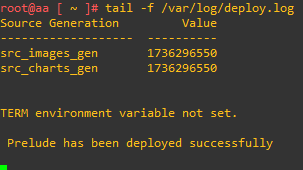

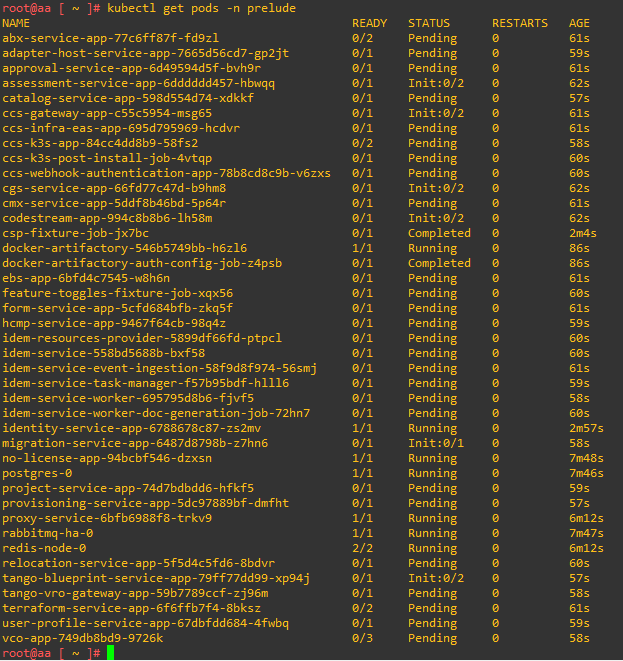

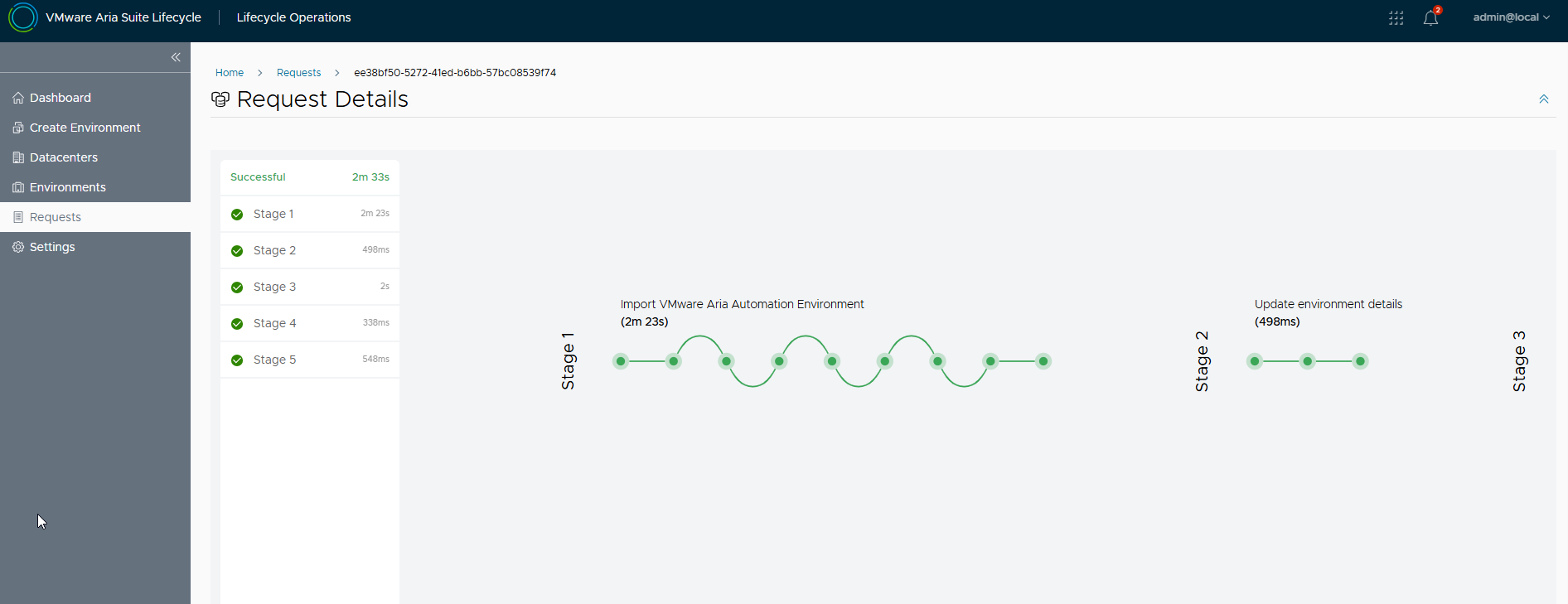

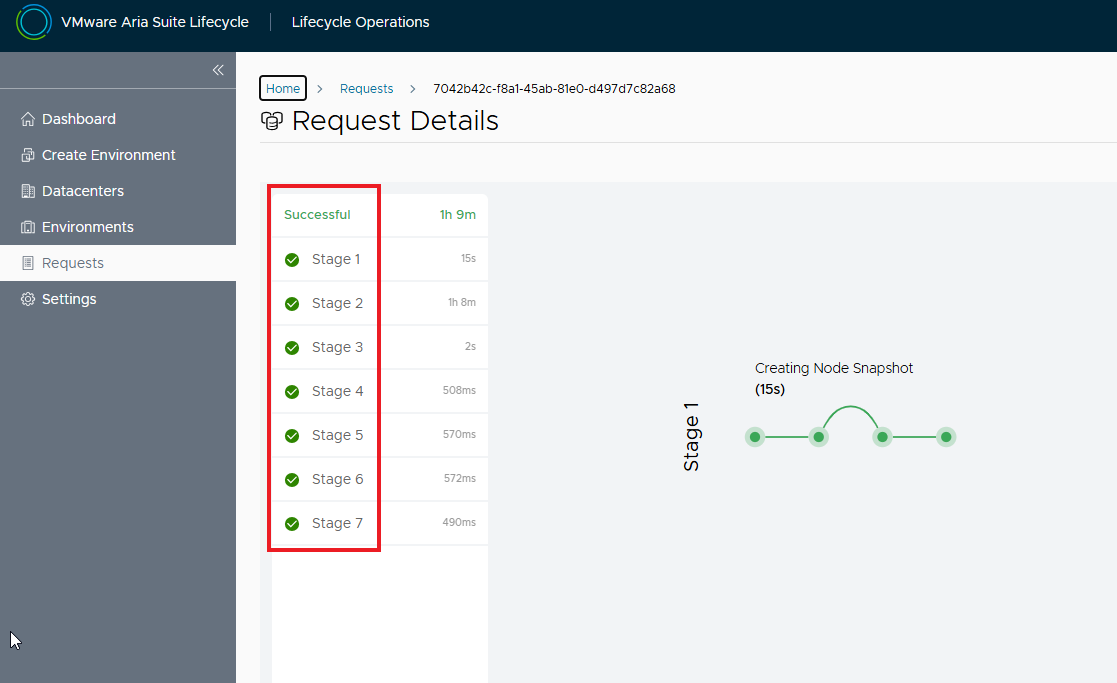

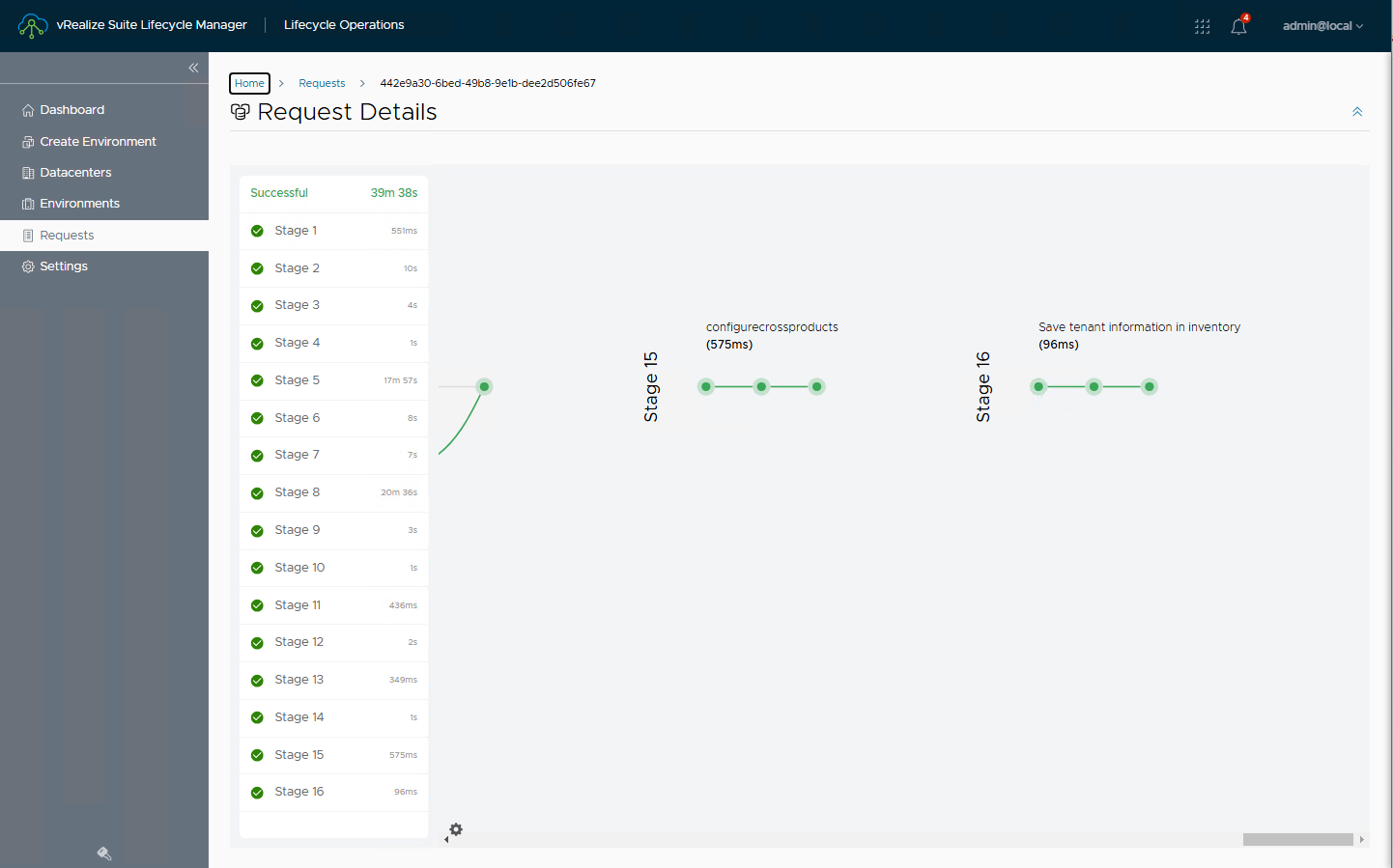

Attendiamo che il processo di upgrade si completi con successo

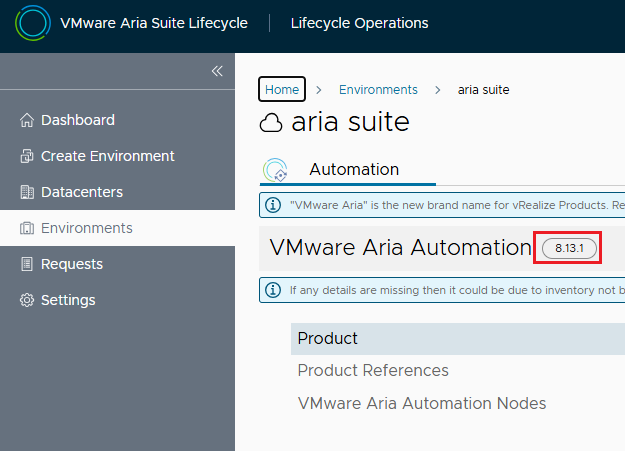

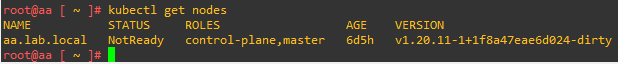

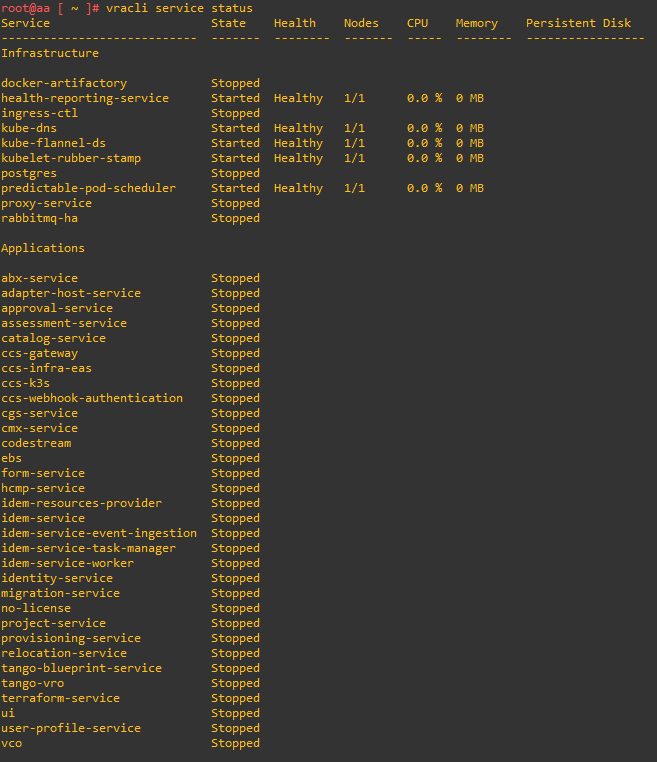

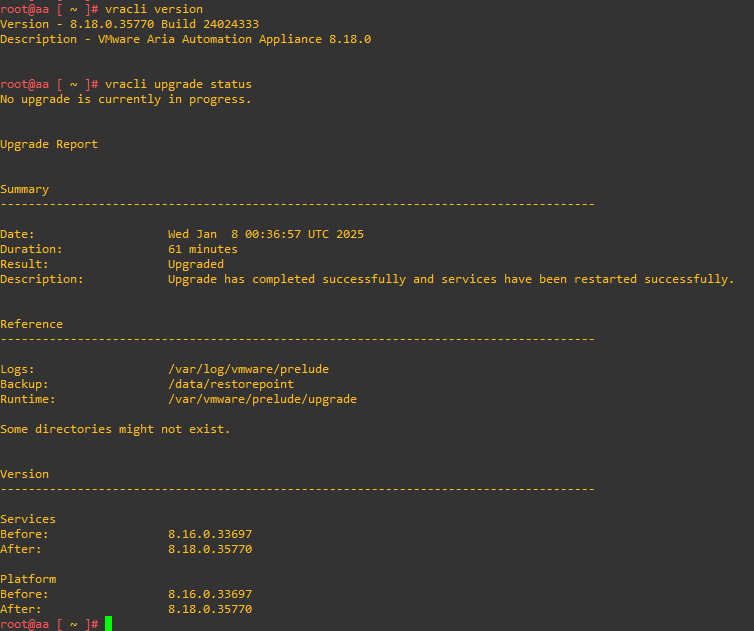

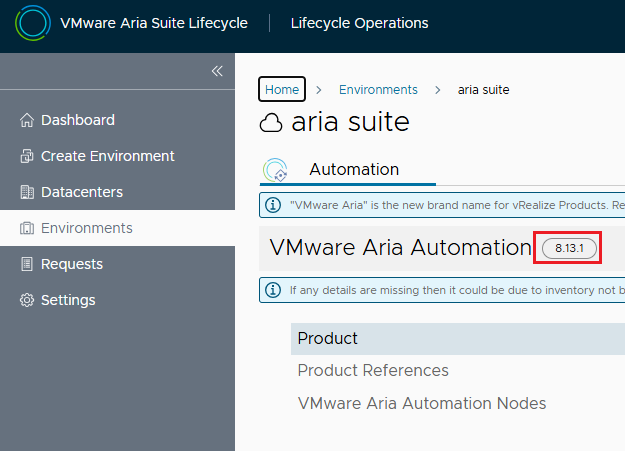

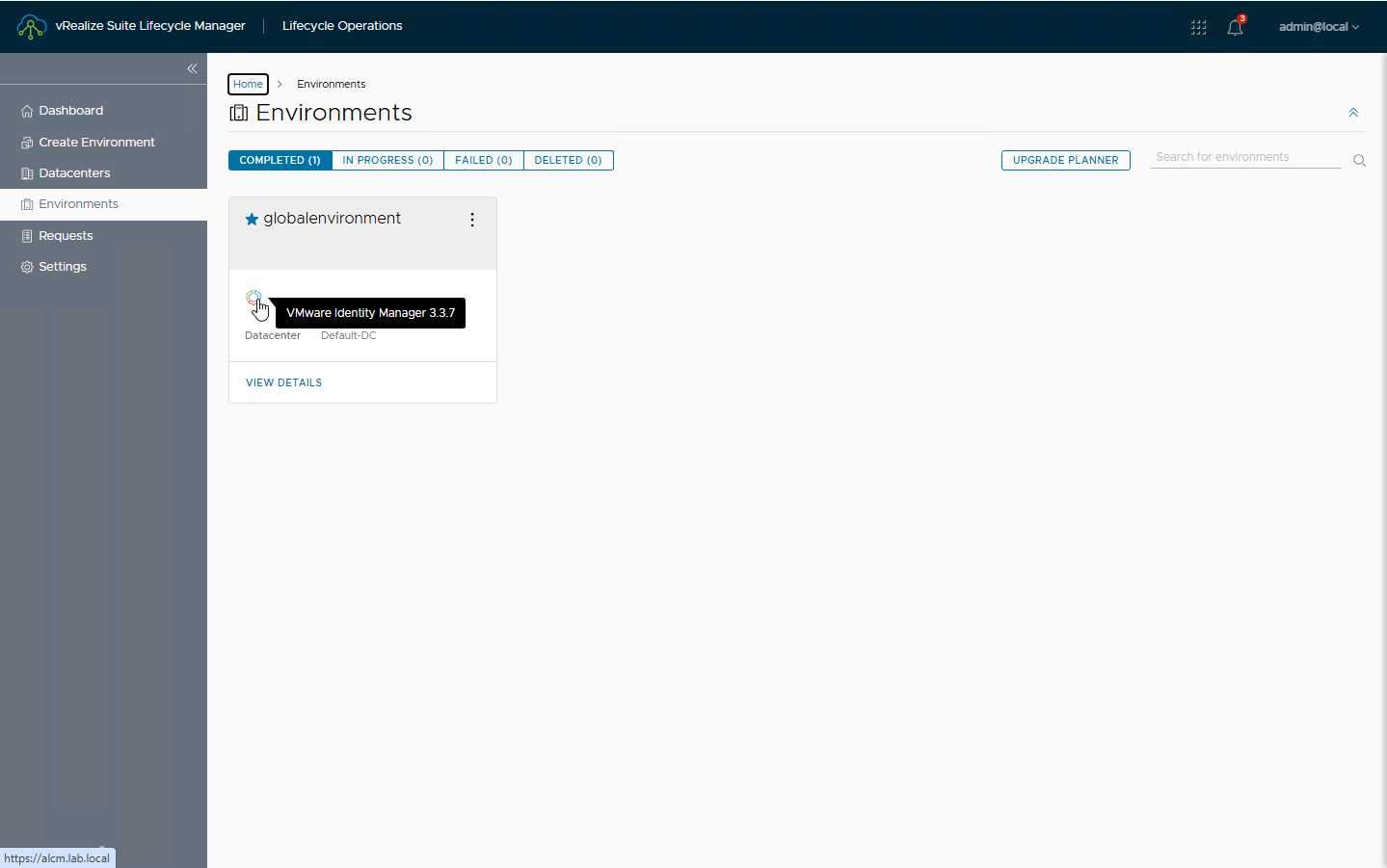

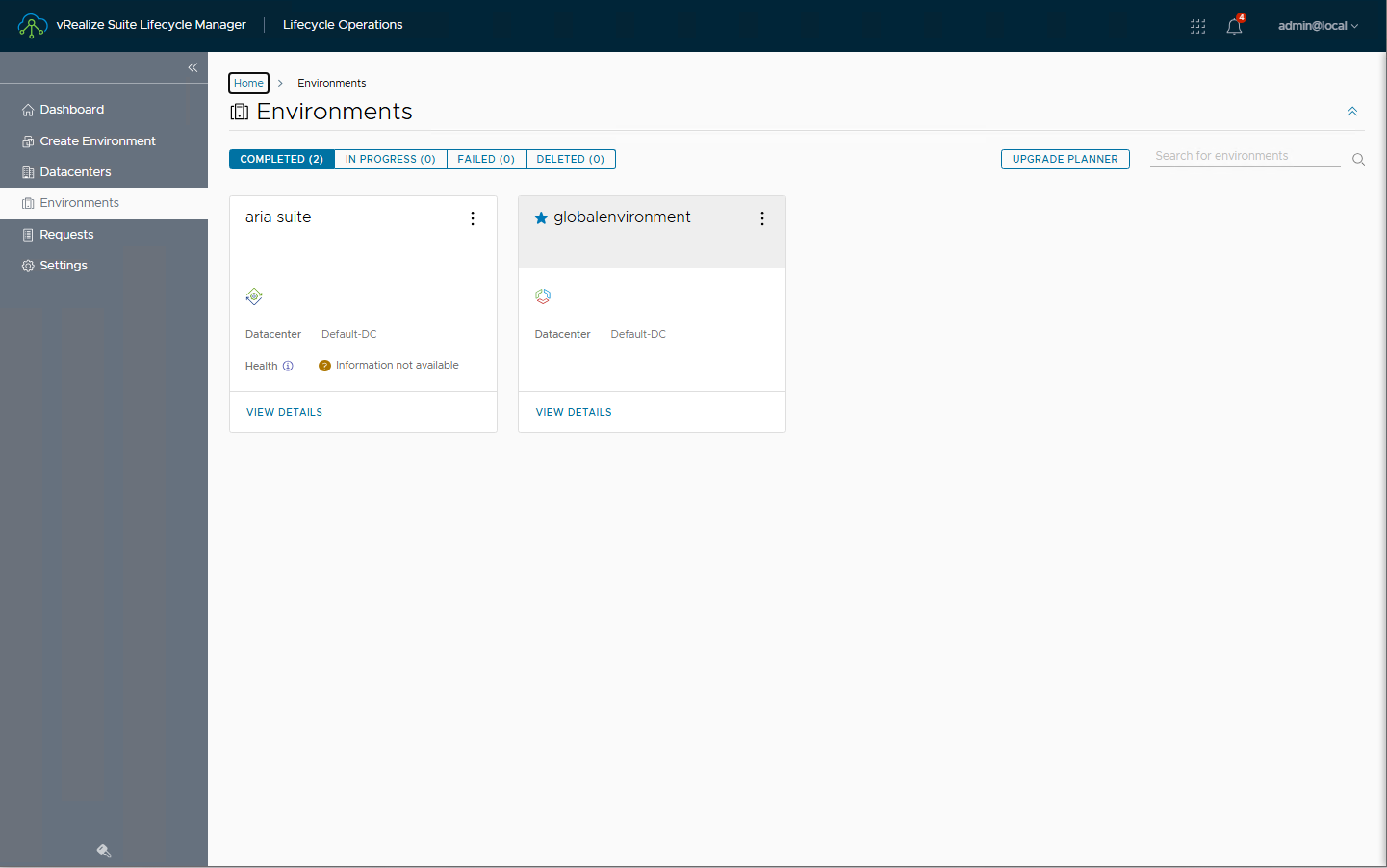

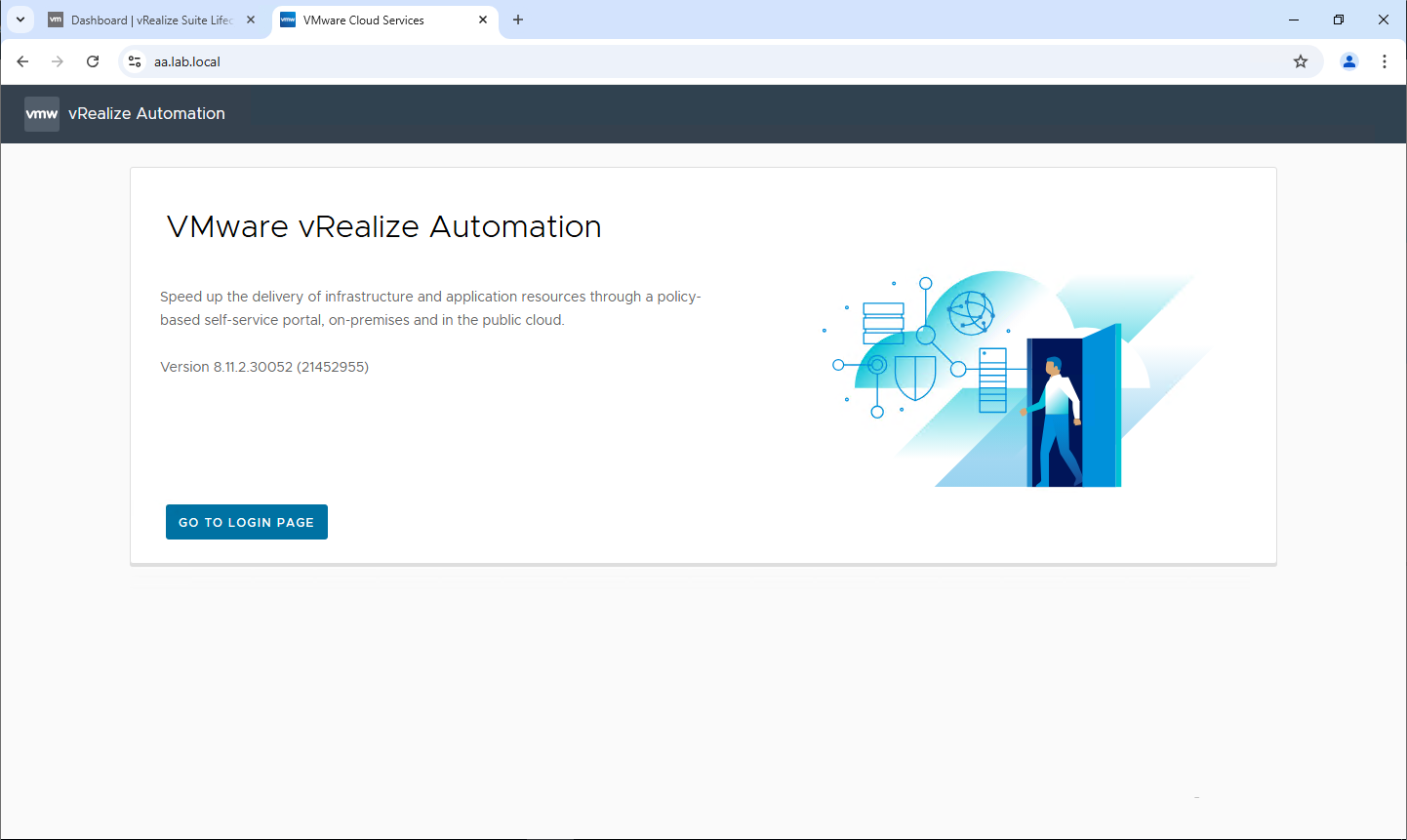

L’intero processo ha durato circa 1 ora, è possibile monitorare lo stato dei servizi direttamante dalla console di Aria Automation. Alla fine dell’upgrade il nostro environment sarà aggiornato 🙂

A questo punto abbiamo eseguito i primi 2 step del path di upgrade, allo stesso modo sarà possibile eseguire tutti gli altri step fino ad arrivare alla release 8.18 di LCM ed Aria Suite

NOTA: l’upgrade di Aria Automatin dalla release 8.16 alla 8.18 chiede 54GB di RAM come prerequisito.

Questi i file da scaricare per eseguire tutti gli upgrade

Prelude_VA-8.13.1.32340-22360938-updaterepo.iso

Prelude_VA-8.16.0.33697-23103949-updaterepo.iso

Prelude_VA-8.18.0.35770-24024333-updaterepo.iso

VMware-Aria-Suite-Lifecycle-Appliance-8.12.0.7-21628952-updaterepo.iso

VMware-Aria-Suite-Lifecycle-Appliance-8.14.0.4-22630472-updaterepo.iso

VMware-Aria-Suite-Lifecycle-Appliance-8.16.0.4-23377566-updaterepo.iso

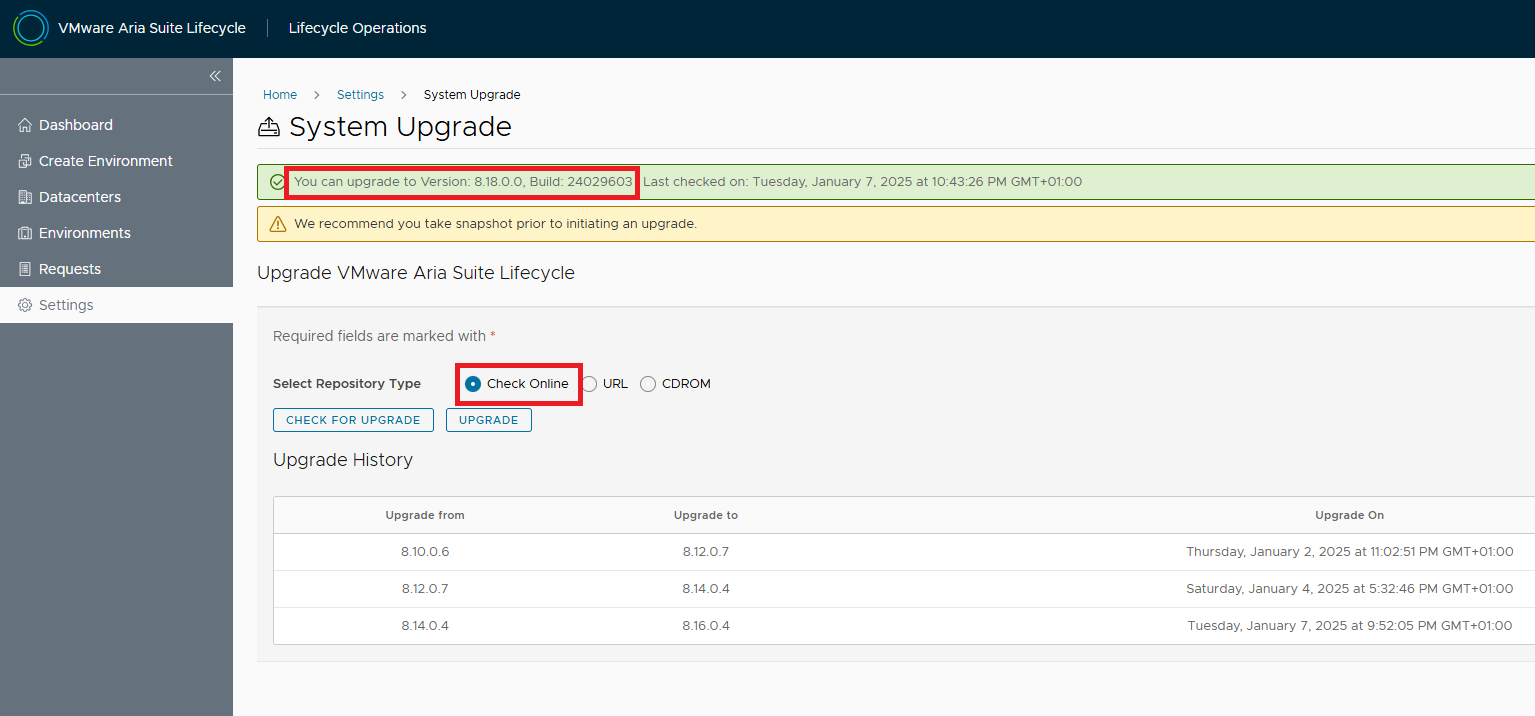

NOTA: l’upgrade a LCM 8.18 può essere fatto direttamente dal repository online 🙂

Nel prossimo articolo racconterò come risolvere alcuni problemi incontrati durante l’upgrade e di come monitorare lo stato dei servizi di Aria Automation via CLI

La Matrice di interoperabilità dei prodotti VMware è disponibile a questo

La Matrice di interoperabilità dei prodotti VMware è disponibile a questo